Teknologi Pengenalan Wajah dan kemampuannya telah berkembang jauh melampaui imajinasi kita sejak algoritme baru untuk memperkuat teknologi ini dalam penegakan hukum menjadi terkenal. Saat ini, teknologi pengenalan wajah digunakan oleh aparat penegak hukum di tingkat terendah dalam proses pengumpulan data untuk mengidentifikasi pelaku kriminal di tengah kerumunan yang ramai. Teknologi ini menggunakan rekaman dari kamera CCTV di tempat-tempat umum dan jalan-jalan dan kemudian menjalankan data yang dikumpulkan terhadap arsip agensi untuk mendeteksi wajah yang dicari untuk tindak pidana.

Teknologi ini telah disematkan lebih jauh ke dalam gadget terkecil, termasuk ponsel dan perangkat pintar yang dapat dipakai. Oleh karena itu, ini tidak hanya melindungi Anda di jalanan tetapi juga bermaksud untuk melindungi informasi pribadi Anda yang tersimpan di perangkat pintar Anda. Menggunakan "cetak wajah" untuk praktik pemasaran dan periklanan telah menjadi hal biasa di era modern kampanye media sosial. Dan kemudian, ada pengawasan pribadi di mal, toko ritel, dll.

Dari perspektif ini, seseorang dapat dengan cepat menunjukkan keuntungan yang tak terbantahkan dari teknologi pengenalan wajah. Tapi itu juga telah diteliti untuk ancaman yang ditimbulkannya terhadap privasi pengguna, perlindungan data, dan tentu saja, transparansi antara hukum dan publik. Merupakan hal yang baik untuk menyadari kelebihan dan kekurangan dari teknologi invasif semacam itu. Namun, ada satu lagi kelemahan dari teknologi pengenalan wajah, yang tampaknya diabaikan orang, dan itu adalah profil rasial dan diskriminasi rasial .

Dalam bagian ini, kita melihat bagaimana teknologi ini mempromosikan bias dan diskriminasi rasial dan seberapa parah dampak dari teknologi invasif tersebut.

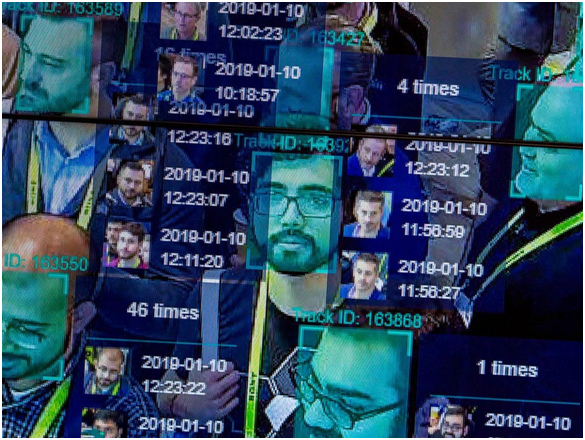

Bagaimana Pengenalan Wajah Bekerja?

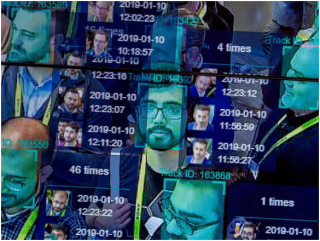

Sumber Gambar: National Post

Langkah 1: Foto Anda diambil dari kamera, akun Anda, email, dll. Bisa berupa foto profil langsung atau foto acak di tengah keramaian.

Langkah 2: Perangkat lunak pengenalan wajah akan menjalankan wajah Anda melalui database sidik jari yang tersimpan. Sidik wajah dikumpulkan melalui pelacakan geometris wajah Anda.

Langkah 3: Persentase kecocokan gambar Anda dengan faceprint yang diketahui dihasilkan menggunakan algoritme di mana penentuan dibuat.

Bias Otomatisasi: Salah Satu dari Banyak Kelemahan Teknologi Pengenalan Wajah

Bias Otomasi atau Bias Mesin mengacu pada skenario di mana algoritme mesin menunjukkan bias tertentu dalam kalibrasi data input, sehingga memberikan output yang tidak menguntungkan. Ini terjadi ketika ada kesalahan dalam kode algoritme, kurangnya kumpulan data yang disimpan untuk kalibrasi, nilai input yang salah, atau data input yang berlebihan, yang berada di luar kemampuan mesin untuk dikalibrasi.

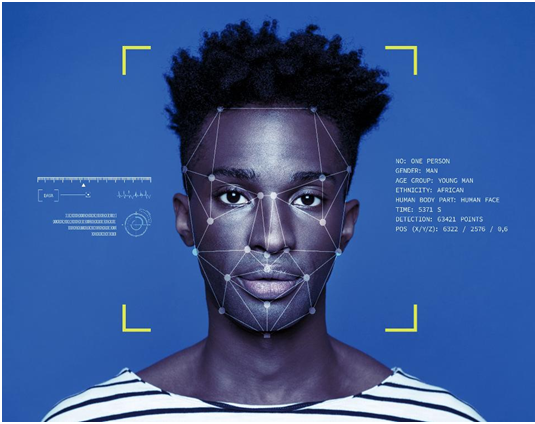

Bagaimana Profil Rasial Berjalan Dengan Semua Ini?

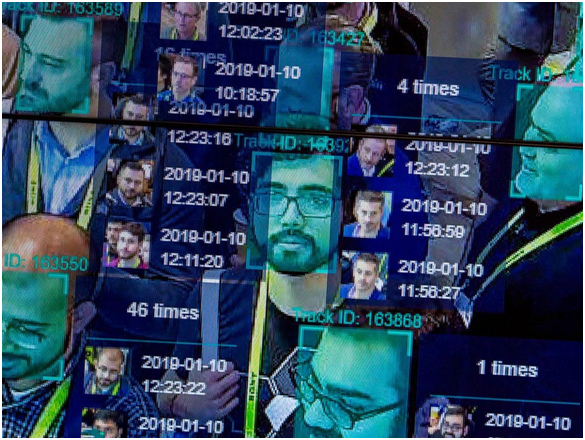

Sumber Gambar: The Guardian

Mari kita mulai dengan sebuah kejadian kuno yang pada saat itu dianggap sepele. Pada tahun 2001, Tampa City menggunakan perangkat lunak pengenal wajah untuk mengawasi kota yang ramai saat turis membanjiri jalan-jalan kota karena Super Bowl 2001. Sesuai laporan New York Times , perangkat lunak tersebut mengidentifikasi 19 orang yang diduga memiliki surat perintah luar biasa terhadap mereka; namun, tidak ada penangkapan yang dilakukan karena infrastruktur stadion tidak memungkinkan untuk menemukan pelaku yang teridentifikasi di antara kerumunan yang membludak.

Sementara tanda-tanda profil rasial tidak terlihat di mana pun dalam kasus khusus ini, ini adalah pertama kalinya teknik pengawasan dilakukan terhadap pelanggaran kebebasan sipil dan privasi individu. Di tahun-tahun mendatang, Polisi Tampa menyerah pada sistem pengawasan ini dengan alasan hasil yang tidak dapat diandalkan.

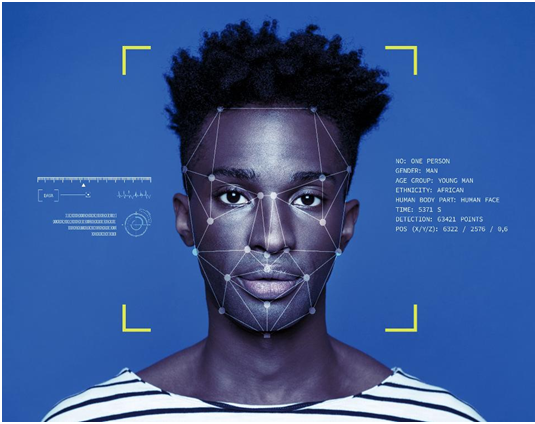

Sumber Gambar: ICO

Maju cepat ke skenario yang agak lebih baru, Ali Breland melaporkan untuk The Guardian , mengenai penangkapan Willie Lynch, seorang pria kulit hitam yang dituduh sebagai pengedar narkoba terkenal di daerah Brentwood, terutama lingkungan orang kulit berwarna. Satu-satunya bukti terhadap Lynch adalah foto-fotonya di ponsel, yang dijalankan terhadap database polisi sebelum polisi menetapkan dia sebagai pelakunya. Lynch dihukum selama delapan tahun, yang sekarang telah mengajukan banding atas vonis tersebut. Apakah dia tersangka penyalur atau bukan, itu pasti menimbulkan kekhawatiran apakah hanya hasil berbasis mesin yang cukup untuk menegakkan keyakinan siapa pun yang sedang diselidiki?

Pada 2019, seperti dilansir Tom Perkins untuk The Guardian , polisi Detroit ditemukan menggunakan pengenalan wajah untuk melakukan penangkapan yang diduga selama dua tahun terakhir. Detroit adalah tempat di mana lebih dari 80% penduduknya berkulit hitam. Sebuah pernyataan dari seorang anggota kulit hitam dari Komisi Kepolisian Detroit menimbulkan kekhawatiran terhadap praktik tersebut. Dia mengatakan bahwa orang kulit hitam memiliki ciri wajah yang sama yang membahayakan algoritme sistem, menyebutnya sebagai "rasisme tekno".

Sumber Gambar: Vox

Dalam penelitian tahun 2019 untuk Journal of Information Communication and Ethics Society, oleh Fabio Bacchini dan Ludovica Lorusso, ditemukan bahwa sistem biometrik dan pengenalan wajah ini tidak 100% dapat diandalkan untuk penegakan hukum. Selain itu, diskriminasi rasial adalah dampak negatif pada semua sistem tersebut, yang memiliki implikasi sosial terbalik lebih lanjut. Studi ini menargetkan masyarakat barat pada khususnya, di mana sistem seperti itu digunakan secara luas untuk pengawasan.

Ini hanya tiga dari banyak contoh kasus disparitas rasial yang disebabkan oleh sistem pengenalan wajah yang terungkap. Tetapi mengapa sistem ini begitu tidak kompeten meskipun akurasi yang meningkat dalam peningkatan pengkodean algoritmik dalam teknologi.

Supremasi Kulit Putih di Negara Barat: Industri Teknologi yang Dominan Kulit Putih

Pada tahun 2014, sebagian besar perusahaan teknologi, termasuk raksasa Apple Inc., diketahui mempekerjakan sebagian besar karyawan pria kulit putih. Di Apple, 55% karyawan berkulit putih, dan demikian pula, kepemimpinan Apple terdiri dari 63% karyawan kulit putih. Perusahaan yang berbagi laporan keragaman serupa termasuk Facebook , Google, dan Twitter juga. Lima tahun kemudian, sebuah laporan di Wired mengungkapkan bahwa hanya ada sedikit peningkatan dalam angka-angka ini.

Sementara Facebook menunjukkan peningkatan yang layak dalam jumlah, persentase pekerja teknis kulit hitam Apple tidak berubah hanya 6% dari total tenaga kerja. Amazon adalah satu-satunya organisasi yang mendaftarkan 42% pekerja kulit hitam atau Amerika Latin di kantornya di AS.

Apa arti dari statistik ini? Di AS, sebagian besar pembuat kode, yang ditugaskan untuk proyek besar seperti merancang algoritme untuk sistem pengawasan, berkulit putih. Ini adalah orang-orang yang membuat keputusan paling signifikan mengenai produk atau layanan yang akan diluncurkan/diluncurkan oleh perusahaan. Dan karenanya, perspektif, pendekatan, dan proses berpikir merekalah yang masuk dalam penciptaan akhir. Ini tidak berarti bahwa orang kulit putih adalah rasis dan sengaja merancang sistem pengawasan seperti itu . TIDAK!

Sumber Gambar: Forbes

Ketika seorang pria kulit putih merancang algoritme pengenalan wajah dan hanya memiliki rekan kulit putih yang berkonsultasi/membantunya, mereka tidak mempertimbangkan orang dengan ciri wajah warna lain sebelum menyelesaikan kode. Karena insinyur kulit putih mendominasi industri teknologi, arsip data yang digunakan untuk menyiapkan kode awal juga dibuat dan dikalibrasi oleh teknisi kulit putih. Dengan demikian, kode itu sendiri dibuat dengan bias dalam algoritme kalkulatif intinya, yang mengakibatkan perbedaan ras dalam hasil pengawasan.

Kode hanya mempelajari apa yang diwujudkan orang kulit putih di dalamnya. Tidak ada perspektif atau kontribusi dari setiap orang dari warna lain.

Masalah Kalibrasi

Penegakan hukum Amerika sangat bergantung pada pengawasan dan pelacakan data. Ada banyak contoh di mana pelapor mengeluarkan informasi mengenai pengawasan yang tidak sah terhadap warga sipil. Pengungkapan Edward Snowden tentang pengawasan ilegal NSA adalah salah satu contohnya.

Sumber Gambar: CBS Lokal

Program pengawasan ini didukung oleh sidik wajah dan informasi pribadi lainnya dari jutaan warga. Jika kita hanya mempertimbangkan sidik wajah, ada jutaan orang Amerika secara terbuka berbagi gambar di platform media sosial. Lalu ada kamera CCTV di setiap jalan negara yang menawarkan rekaman langsung dari ratusan ribu orang yang lewat. Saat ini, ada sekitar 117 juta gambar dalam basis data kepolisian, sementara FBI memiliki lebih dari 400 juta kumpulan data untuk dikalibrasi dalam algoritme pengenalan wajah pengawasan.

Sekarang bayangkan kumpulan data ini dibandingkan dengan satu gambar yang mungkin atau mungkin tidak menangkap semua ciri wajah orang tertentu. Dalam skenario seperti itu, kesalahan mungkin muncul. Ada terlalu banyak data untuk dipahami dan dijalankan dengan satu sidik jari. Tidak ada algoritme yang dapat menjamin jaminan seratus persen dalam hasilnya ketika kalibrasi begitu rumit. Ini akhirnya menambah profil rasial yang disebabkan oleh teknologi pengenalan wajah.

Keandalan Luar Biasa pada Pengenalan Wajah

Sumber Gambar: NY Post

Kasus Willie Lynch adalah pengingat bahwa pengenalan wajah seharusnya tidak menjadi satu-satunya teknik yang dapat diandalkan yang disajikan sebagai bukti dalam hal penegakan hukum. Inilah alasan mengapa polisi kota Tampa menyerah pada teknologi.

Memang benar bahwa pengenalan wajah adalah pilihan yang sangat baik dan sangat membantu polisi. Pelaku Bom Marathon Boston dikenali menggunakan analisis rekaman pengawasan yang ekstensif dan terperinci. Tapi ini tidak bisa menjadi bukti tunggal untuk menghukum siapa pun. Harus ada bukti pendukung untuk membuktikan hasil dari algoritma pengenalan wajah, dan konsep bias otomatisasi harus dipertimbangkan sebelum mencapai penentuan akhir.

Masalah Perangkat Keras: Pengenalan Wajah di Ponsel dan Kamera

Sumber Gambar: TechCrunch

Sistem kamera pengintai dan perangkat keras dan perangkat lunak terkait tidak dirancang oleh satu perusahaan tunggal. Ini adalah industri bernilai miliaran dolar di mana puluhan perusahaan bersaing untuk mendapatkan kontrak dari lembaga penegak hukum. Banyak dari sistem ini berasal dari pabrikan Cina. Ini semua tentang mendapatkan teknologi termurah dengan kualitas terbaik. Begitulah cara kerjanya. Dan oleh karena itu, selalu ada kemungkinan perbedaan dalam kalibrasi sistem yang berbeda, serta variasi dalam kualitas hasil surveilans. Banyak algoritme pengawasan kamera tidak efektif dalam mengkalibrasi gambar orang kulit berwarna hanya karena ketidakmampuan teknis, sehingga mengagungkan diskriminasi rasial.

Masalah teknologi yang menyebabkan rasisme melalui pengenalan wajah juga telah diperhatikan dalam fitur Apple Face Lock. Sebuah kasus dari China menggulingkan bahwa kunci wajah iPhone X tidak dapat membedakan antara dua rekan kerja China yang berbeda, membuat fitur tersebut tidak berguna. Laporan serupa diberhentikan, mengutip masalah dalam fitur dalam memisahkan dua orang kulit hitam dari satu sama lain. Seperti yang dinyatakan di atas, Apple hanya memiliki 6% orang kulit hitam di tim teknis. Ini adalah contoh nyata bagaimana teknologi pengenalan wajah dapat mempromosikan rasisme bahkan di perangkat genggam kita.

Kesimpulan

Ya, Pengenalan Wajah itu rasis, dan itu sudah menjadi rahasia umum sekarang. Sementara teknologi berkembang setiap hari untuk memperbaiki masalah seperti itu, hasilnya tetap sama. Teknologi seharusnya menyatukan dunia atas tujuan umum kemajuan dan pengembangan teknis, tetapi beberapa teknik hanya menyebabkan kerusakan pada harmoni ras dan komunal.

Untuk saat ini, hal terbaik yang dapat dilakukan aparat penegak hukum adalah tidak mendukung kasus mereka berdasarkan bukti dari kalibrasi algoritmik, yang bahkan tidak dapat diandalkan. Selain itu, sudah saatnya keragaman dan inklusi di tempat kerja ditanggapi dengan serius sehingga orang-orang dari semua etnis dapat bersatu untuk menciptakan produk yang bebas dari perbedaan ras. Ada ribuan ras di dunia, dan orang-orang telah tumbuh untuk mengesampingkan perbedaan ras, yang begitu lama menghantui masyarakat global. Jika itu harus dipertahankan, maka mesin yang sangat kita andalkan harus diajarkan hal yang sama.