ZPanel y Sentora en CentOS 6 x64

ZPanel, un panel de control de alojamiento web popular, se bifurcó en 2014 a un nuevo proyecto llamado Sentora. Aprende a instalar Sentora en tu servidor con este tutorial.

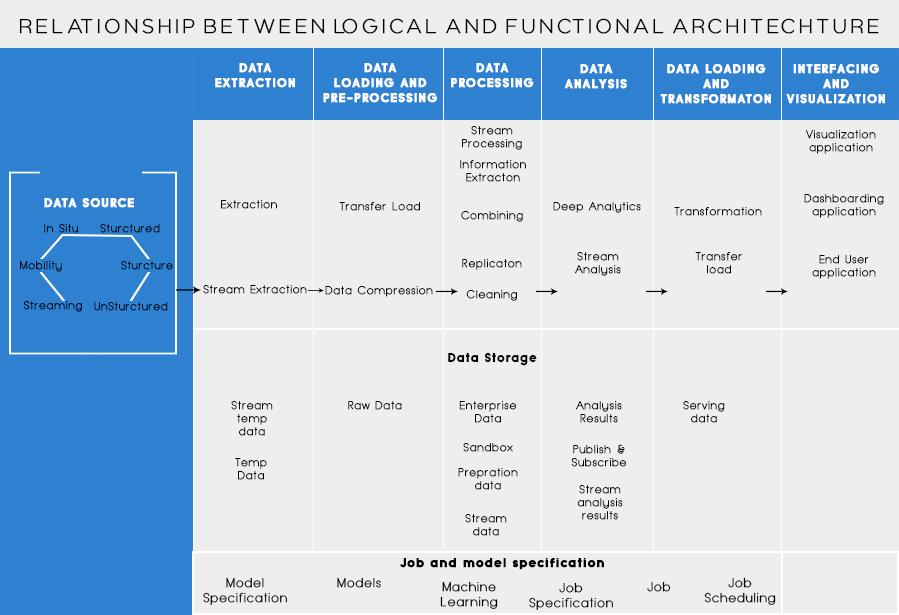

En mi último post , hablamos sobre el análisis del problema empresarial y los pasos básicos para diseñar la Arquitectura de Big Data. Hoy voy a hablar sobre diferentes capas de la Arquitectura Big Data y sus funcionalidades.

Capas lógicas de la arquitectura de referencia de Big Data

Detrás de la arquitectura de big data, la idea central es documentar una base adecuada de arquitectura, infraestructura y aplicaciones. En consecuencia, esto permite a las empresas utilizar big data de forma más eficaz a diario.

Es creado por arquitectos / diseñadores de big data antes de implementar físicamente una solución. La creación de una arquitectura de big data generalmente requiere comprender la empresa / organización y sus necesidades de big data. Por lo general, las arquitecturas de big data describen los componentes de hardware y software que son necesarios para cumplir con la solución de big data. Los documentos de arquitectura de big data también pueden describir protocolos para compartir datos, integraciones de aplicaciones y seguridad de la información.

Más información: Guía para principiantes de análisis de macrodatos

También implica interconectar y organizar los recursos existentes para satisfacer las necesidades de big data.

Las capas lógicas de la arquitectura de referencia son las siguientes:

La creación de perfiles de origen es uno de los pasos más importantes para decidir la arquitectura o el big data. Implica identificar diferentes sistemas fuente y categorizarlos, según su naturaleza y tipo.

Puntos a tener en cuenta al elaborar perfiles de fuentes de datos:

La ingestión de datos tiene que ver con la extracción de datos de las fuentes mencionadas anteriormente. Estos datos se almacenan en el almacenamiento y luego se transforman para su posterior procesamiento.

Puntos a considerar:

Uno debería poder almacenar grandes cantidades de datos de cualquier tipo y debería poder escalar según sea necesario. También debemos considerar el número de IOPS (operaciones de entrada y salida por segundo) que puede proporcionar. El sistema de archivos distribuido Hadoop es el marco de almacenamiento más utilizado en el mundo de Big Data, otros son los almacenes de datos NoSQL: MongoDB, HBase, Cassandra, etc.

Aspectos a tener en cuenta al planificar la metodología de almacenamiento:

No solo la cantidad de datos que se almacenan, sino que el procesamiento también se ha multiplicado.

Los datos a los que se accedía con frecuencia anteriormente se almacenaban en RAM dinámicas. Pero ahora, se almacena en varios discos en varias máquinas conectadas a través de la red debido al gran volumen. Por lo tanto, en lugar de recopilar fragmentos de datos para su procesamiento, los módulos de procesamiento se llevan al big data. Por lo tanto, se reduce significativamente la E / S de la red. La metodología de procesamiento se basa en los requisitos comerciales. Se puede clasificar en Lotes, en tiempo real o Híbrido según el SLA.

Esta capa consume la salida proporcionada por la capa de procesamiento. Los diferentes usuarios, como el administrador, los usuarios comerciales, el proveedor, los socios, etc. pueden consumir datos en diferentes formatos. El motor de recomendaciones puede consumir la salida del análisis o los procesos comerciales se pueden activar en función del análisis.

Las diferentes formas de consumo de datos son:

Lea también: Big Data: ¿Una pesadilla futura?

Capas funcionales de la arquitectura de Big Data:

Podría haber una forma más de definir la arquitectura, es decir, a través de la división de funcionalidad. Pero las categorías de funcionalidad podrían agruparse en la capa lógica de la arquitectura de referencia, por lo que la arquitectura preferida es la que se realiza con capas lógicas.

La estratificación basada en las funcionalidades es la siguiente:

El análisis de todas las fuentes de las que una organización recibe datos y que podrían ayudar a la organización a tomar sus decisiones futuras debe incluirse en esta categoría. Las fuentes de datos enumeradas aquí son independientes del hecho de que los datos estén estructurados, no estructurados o semiestructurados.

Antes de que pueda almacenar, analizar o visualizar sus datos, debe tener algunos. La extracción de datos consiste en tomar algo que no está estructurado, como una página web, y convertirlo en una tabla estructurada. Una vez que lo haya estructurado, puede manipularlo de muchas formas, utilizando las herramientas que se describen a continuación, para encontrar información.

La necesidad básica al trabajar con big data es pensar en cómo almacenar esos datos. Parte de cómo Big Data obtuvo la distinción como “GRANDE” es que se volvió demasiado para que lo manejen los sistemas tradicionales. Un buen proveedor de almacenamiento de datos debería ofrecerle una infraestructura en la que ejecutar todas sus otras herramientas de análisis, así como un lugar para almacenar y consultar sus datos.

Un paso previo necesario antes de que realmente comencemos a extraer los datos para obtener información. Siempre es una buena práctica crear un conjunto de datos limpio y bien estructurado. Los conjuntos de datos pueden tener todas las formas y tamaños, especialmente cuando provienen de la web. Elija una herramienta según sus requisitos de datos.

La minería de datos es el proceso de descubrir información dentro de una base de datos. El objetivo de la minería de datos es tomar decisiones y hacer predicciones sobre los datos que tiene a mano. Elija un software que le brinde las mejores predicciones para todo tipo de datos y le permita crear sus propios algoritmos para extraer los datos.

Si bien la minería de datos se trata de examinar sus datos en busca de patrones previamente no reconocidos, el análisis de datos se trata de desglosar esos datos y evaluar el impacto de esos patrones en el tiempo. La analítica consiste en hacer preguntas específicas y encontrar las respuestas en los datos. ¡Incluso puede hacer preguntas sobre lo que sucederá en el futuro!

Las visualizaciones son una forma fácil y brillante de transmitir conocimientos de datos complejos. Y la mejor parte es que la mayoría de ellos no requieren codificación. Las empresas de visualización de datos harán que sus datos cobren vida. Parte del desafío para cualquier científico de datos es transmitir la información de esos datos al resto de su empresa. Las herramientas pueden ayudarlo a crear gráficos, mapas y otros gráficos similares a partir de sus conocimientos de datos.

Las plataformas de integración de datos son el pegamento entre cada programa. Conectan las diferentes inferencias de las herramientas con otros softwares. Puede compartir los resultados de sus herramientas de visualización directamente en Facebook a través de estas herramientas.

Habrá momentos en su carrera de datos en los que una herramienta simplemente no será suficiente. Si bien las herramientas de hoy son cada vez más poderosas y fáciles de usar, a veces es mejor codificarlas usted mismo. Hay diferentes lenguajes que le ayudan en diferentes aspectos como la computación estadística y los gráficos. Estos lenguajes podrían funcionar como un complemento para la minería de datos y los softwares estadísticos.

La clave a recordar al diseñar la Arquitectura de Big Data es:

Sé que estaría pensando en diferentes herramientas a utilizar para crear una solución de Big Data totalmente a prueba. Bueno, en mis próximas publicaciones sobre Big Data, cubriría algunas de las mejores herramientas para lograr diferentes tareas en la arquitectura de Big Data .

ZPanel, un panel de control de alojamiento web popular, se bifurcó en 2014 a un nuevo proyecto llamado Sentora. Aprende a instalar Sentora en tu servidor con este tutorial.

Aprende cómo instalar Vtiger CRM, una aplicación de gestión de relaciones con el cliente, en CentOS 7 para aumentar tus ventas y mejorar el servicio al cliente.

Esta guía completa le mostrará cómo configurar un servidor Counter-Strike 1.6 en Linux, optimizando el rendimiento y la seguridad para el mejor juego. Aprende los pasos más recientes aquí.

Los ataques de ransomware van en aumento, pero ¿puede la IA ayudar a lidiar con el último virus informático? ¿Es la IA la respuesta? Lea aquí, sepa que la IA es una bendición o una perdición

ReactOS, un sistema operativo de código abierto y gratuito, está aquí con la última versión. ¿Puede satisfacer las necesidades de los usuarios de Windows de hoy en día y acabar con Microsoft? Averigüemos más sobre este estilo antiguo, pero una experiencia de sistema operativo más nueva.

Whatsapp finalmente lanzó la aplicación de escritorio para usuarios de Mac y Windows. Ahora puede acceder a Whatsapp desde Windows o Mac fácilmente. Disponible para Windows 8+ y Mac OS 10.9+

Lea esto para saber cómo la Inteligencia Artificial se está volviendo popular entre las empresas de pequeña escala y cómo está aumentando las probabilidades de hacerlas crecer y dar ventaja a sus competidores.

Recientemente, Apple lanzó macOS Catalina 10.15.4, una actualización complementaria para solucionar problemas, pero parece que la actualización está causando más problemas que conducen al bloqueo de las máquinas Mac. Lee este artículo para obtener más información

13 Herramientas comerciales de extracción de datos de Big Data

Nuestra computadora almacena todos los datos de una manera organizada conocida como sistema de archivos de diario. Es un método eficiente que permite a la computadora buscar y mostrar archivos tan pronto como presiona buscar.