ZPanel y Sentora en CentOS 6 x64

ZPanel, un panel de control de alojamiento web popular, se bifurcó en 2014 a un nuevo proyecto llamado Sentora. Aprende a instalar Sentora en tu servidor con este tutorial.

' Big Data ' es la aplicación de técnicas y tecnologías especializadas para procesar grandes conjuntos de datos. Estos conjuntos de datos suelen ser tan grandes y complejos que resultan difíciles de procesar con las herramientas de gestión de bases de datos disponibles.

El crecimiento radical de la tecnología de la información ha dado lugar a varias condiciones complementarias en la industria. Uno de los resultados más persistentes y posiblemente más presentes es la presencia de Big Data. El término Big Data es un eslogan que se acuñó para describir la presencia de enormes cantidades de datos. El efecto resultante de tener una cantidad tan grande de datos es el análisis de datos.

El análisis de datos es el proceso de estructuración de Big Data. Dentro de Big Data, existen diferentes patrones y correlaciones que hacen posible que la analítica de datos realice una caracterización mejor calculada de los datos. Esto hace que el análisis de datos sea una de las partes más importantes de la tecnología de la información.

Por lo tanto, aquí estoy enumerando las 26 técnicas de análisis de big data. Esta lista no es de ninguna manera exhaustiva.

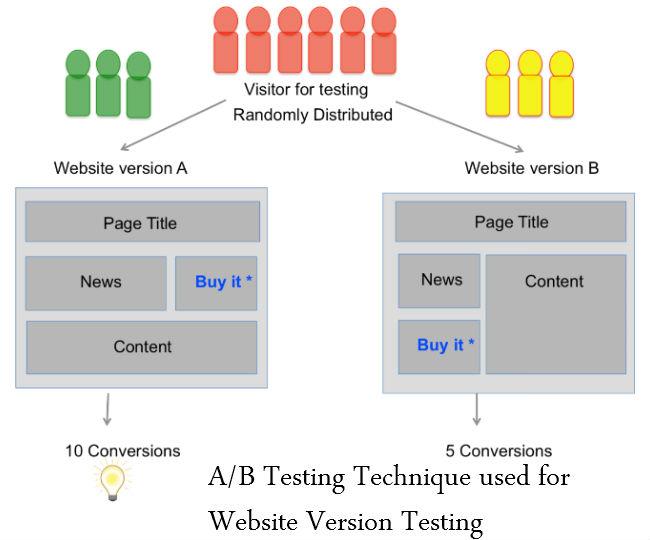

Pruebas A / B

Las pruebas A / B son una herramienta de evaluación para identificar qué versión de una página web o una aplicación ayuda a una organización o individuo a alcanzar un objetivo comercial de manera más efectiva. Esta decisión se toma comparando qué versión de algo funciona mejor. Las pruebas A / B se utilizan comúnmente en el desarrollo web para garantizar que los cambios en una página web o en un componente de la página sean impulsados por datos y no por opiniones personales.

También se denomina prueba de derrames o prueba de cubeta.

Consulte también: El área gris de Big Data: lo que se debe y no se debe hacer

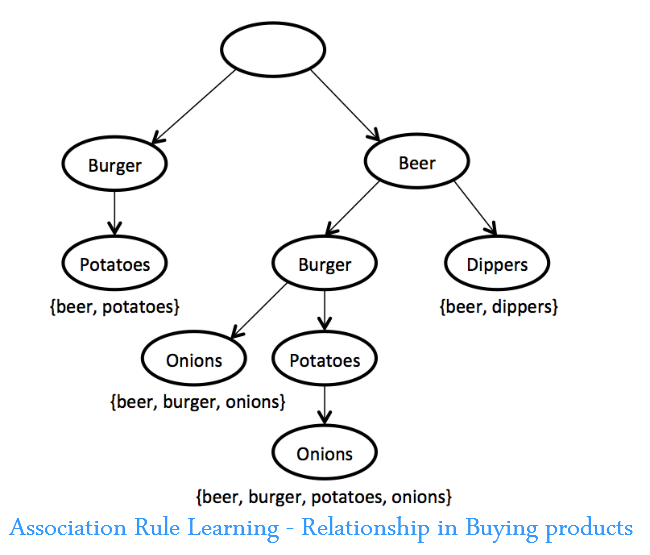

Aprendizaje de reglas de asociación

Un conjunto de técnicas para descubrir relaciones interesantes, es decir, "reglas de asociación", entre variables en grandes bases de datos. Estas técnicas consisten en una variedad de algoritmos para generar y probar posibles reglas.

Una aplicación es el análisis de la cesta de la compra, en el que un minorista puede determinar qué productos se compran juntos con frecuencia y utilizar esta información para fines de marketing. (Un ejemplo comúnmente citado es el descubrimiento de que muchos compradores de supermercados que compran nachos también compran cerveza).

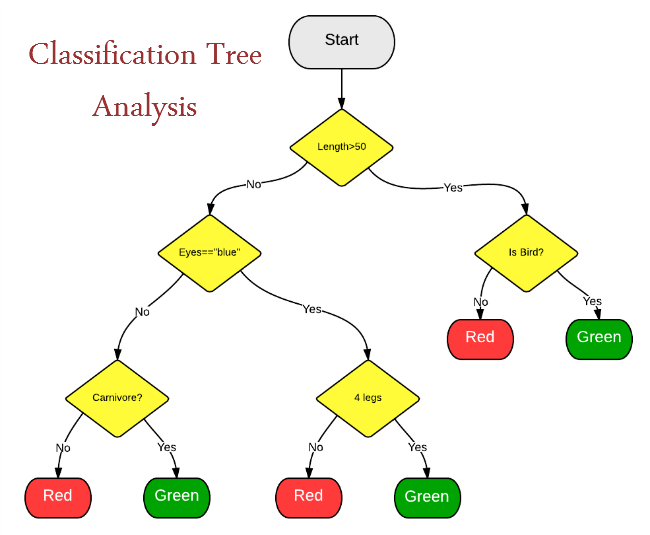

Análisis del árbol de clasificación

La clasificación estadística es un método para identificar categorías a las que pertenece una nueva observación. Requiere un conjunto de entrenamiento de observaciones correctamente identificadas; en otras palabras, datos históricos.

La clasificación estadística se utiliza para:

Análisis de conglomerados

Un método estadístico para clasificar objetos que divide un grupo diverso en grupos más pequeños de objetos similares, cuyas características de similitud no se conocen de antemano. Un ejemplo de análisis de conglomerados es segmentar a los consumidores en grupos auto-similares para el marketing dirigido. Utilizado para minería de datos.

Crowdsourcing

En el crowdsourcing, el matiz es que una tarea o un trabajo se subcontrata, pero no a un profesional u organización designado, sino al público en general en forma de convocatoria abierta. El crowdsourcing es una técnica que se puede implementar para recopilar datos de diversas fuentes, como mensajes de texto, actualizaciones de redes sociales, blogs, etc. Este es un tipo de colaboración masiva y una instancia de uso de la Web.

Fusión e integración de datos

Un proceso multinivel que se ocupa de la asociación, correlación, combinación de datos e información de fuentes únicas y múltiples para lograr una posición refinada, identificar estimaciones y evaluaciones completas y oportunas de situaciones, amenazas y su importancia.

Las técnicas de fusión de datos combinan datos de múltiples sensores e información relacionada de bases de datos asociadas para lograr una mayor precisión y más inferencias específicas que las que se podrían lograr con el uso de un solo sensor.

Ver también: Una guía para principiantes sobre análisis de macrodatos

Procesamiento de datos

La minería de datos consiste en clasificar datos para identificar patrones y establecer relaciones. La minería de datos se refiere a las técnicas colectivas de extracción de datos que se realizan en un gran volumen de datos. Los parámetros de minería de datos incluyen asociación, análisis de secuencia, clasificación, agrupamiento y pronóstico.

Las aplicaciones incluyen la extracción de datos de clientes para determinar los segmentos con más probabilidades de responder a una oferta, la extracción de datos de recursos humanos para identificar las características de los empleados más exitosos o el análisis de la cesta de la compra para modelar el comportamiento de compra de los clientes.

Aprendizaje conjunto

Es un arte de combinar diversos conjuntos de algoritmos de aprendizaje para improvisar sobre la estabilidad y el poder predictivo del modelo. Este es un tipo de aprendizaje supervisado.

Algoritmos genéticos

Técnicas de optimización que utilizan procesos como combinación genética, mutación y selección natural en un diseño basado en los conceptos de evolución natural. Los algoritmos genéticos son técnicas que se utilizan para identificar los videos, programas de televisión y otras formas de medios más visualizados. Existe un patrón evolutivo que se puede realizar mediante el uso de algoritmos genéticos. El análisis de video y medios se puede realizar mediante el uso de algoritmos genéticos.

Aprendizaje automático

El aprendizaje automático es otra técnica que se puede utilizar para clasificar y determinar el resultado probable de un conjunto específico de datos. El aprendizaje automático define un software que puede determinar los posibles resultados de un determinado conjunto de eventos. Por tanto, se utiliza en análisis predictivo. Un ejemplo de analítica predictiva es la probabilidad de ganar casos legales o el éxito de determinadas producciones.

Procesamiento natural del lenguaje

Un conjunto de técnicas de una subespecialidad de la informática (dentro de un campo históricamente llamado "inteligencia artificial") y la lingüística que utiliza algoritmos informáticos para analizar el lenguaje humano (natural). Muchas técnicas de PNL son tipos de aprendizaje automático. Una aplicación de la PNL está utilizando el análisis de sentimientos en las redes sociales para determinar cómo reaccionan los clientes potenciales a una campaña de marca.

Redes neuronales

Modelos predictivos no lineales que aprenden a través del entrenamiento y se asemejan a las redes neuronales biológicas en su estructura. Se pueden utilizar para el reconocimiento y la optimización de patrones. Algunas aplicaciones de redes neuronales implican aprendizaje supervisado y otras implican aprendizaje no supervisado. Los ejemplos de aplicaciones incluyen la identificación de clientes de alto valor que están en riesgo de dejar una empresa en particular y la identificación de reclamaciones de seguros fraudulentas.

Lea también: 40 hechos alucinantes sobre Big Data

Mejoramiento

Un portafolio de técnicas numéricas utilizadas para rediseñar sistemas y procesos complejos para mejorar su desempeño de acuerdo con una o más medidas objetivas (por ejemplo, costo, velocidad o confiabilidad). Entre los ejemplos de aplicaciones se incluyen la mejora de los procesos operativos, como la programación, el enrutamiento y el diseño de la planta, y la toma de decisiones estratégicas, como la estrategia de gama de productos, el análisis de inversiones vinculadas y la estrategia de cartera de I + D. Los algoritmos genéticos son un ejemplo de técnica de optimización.

En mi próximo blog, describiría las 13 técnicas de análisis de Big Data restantes.

Leer: Siguiente parte de una visión de 26 técnicas analíticas de Big Data

ZPanel, un panel de control de alojamiento web popular, se bifurcó en 2014 a un nuevo proyecto llamado Sentora. Aprende a instalar Sentora en tu servidor con este tutorial.

Aprende cómo instalar Vtiger CRM, una aplicación de gestión de relaciones con el cliente, en CentOS 7 para aumentar tus ventas y mejorar el servicio al cliente.

Esta guía completa le mostrará cómo configurar un servidor Counter-Strike 1.6 en Linux, optimizando el rendimiento y la seguridad para el mejor juego. Aprende los pasos más recientes aquí.

Los ataques de ransomware van en aumento, pero ¿puede la IA ayudar a lidiar con el último virus informático? ¿Es la IA la respuesta? Lea aquí, sepa que la IA es una bendición o una perdición

ReactOS, un sistema operativo de código abierto y gratuito, está aquí con la última versión. ¿Puede satisfacer las necesidades de los usuarios de Windows de hoy en día y acabar con Microsoft? Averigüemos más sobre este estilo antiguo, pero una experiencia de sistema operativo más nueva.

Whatsapp finalmente lanzó la aplicación de escritorio para usuarios de Mac y Windows. Ahora puede acceder a Whatsapp desde Windows o Mac fácilmente. Disponible para Windows 8+ y Mac OS 10.9+

Lea esto para saber cómo la Inteligencia Artificial se está volviendo popular entre las empresas de pequeña escala y cómo está aumentando las probabilidades de hacerlas crecer y dar ventaja a sus competidores.

Recientemente, Apple lanzó macOS Catalina 10.15.4, una actualización complementaria para solucionar problemas, pero parece que la actualización está causando más problemas que conducen al bloqueo de las máquinas Mac. Lee este artículo para obtener más información

13 Herramientas comerciales de extracción de datos de Big Data

Nuestra computadora almacena todos los datos de una manera organizada conocida como sistema de archivos de diario. Es un método eficiente que permite a la computadora buscar y mostrar archivos tan pronto como presiona buscar.