ZPanel y Sentora en CentOS 6 x64

ZPanel, un panel de control de alojamiento web popular, se bifurcó en 2014 a un nuevo proyecto llamado Sentora. Aprende a instalar Sentora en tu servidor con este tutorial.

Hasta ahora, en mis blogs sobre Big Data , los he familiarizado con diferentes aspectos de Big Data, desde lo que realmente significa hasta los hechos, lo que se debe y lo que no se debe hacer. En el blog anterior vimos algunas técnicas de análisis de Big Data. Llevando la lista más lejos en este blog.

El reconocimiento de patrones es una rama del aprendizaje automático que se centra en el reconocimiento de patrones y regularidades en los datos, aunque en algunos casos se considera casi sinónimo de aprendizaje automático. En muchos casos, los sistemas de reconocimiento de patrones se entrenan a partir de datos etiquetados de “entrenamiento” (aprendizaje supervisado), pero cuando no hay datos etiquetados disponibles, se pueden usar otros algoritmos para descubrir patrones previamente desconocidos (aprendizaje no supervisado).

La analítica predictiva comprende una variedad de técnicas que predicen resultados futuros basados en datos históricos y actuales. En la práctica, el análisis predictivo se puede aplicar a casi todas las disciplinas, desde predecir la falla de los motores a reacción en función del flujo de datos de varios miles de sensores, hasta predecir los próximos movimientos de los clientes en función de lo que compran, cuándo compran e incluso qué. dicen en las redes sociales. Las técnicas de análisis predictivo se basan principalmente en métodos estadísticos.

Ver también: Una guía para principiantes sobre análisis de macrodatos

Esta es una técnica que toma el uso de variables independientes y cómo afectan a las variables dependientes. Esta puede ser una técnica muy útil para determinar el análisis de las redes sociales, como la probabilidad de encontrar el amor a través de una plataforma de Internet.

El análisis de sentimientos ayuda a los investigadores a determinar los sentimientos de los oradores o escritores con respecto a un tema. El análisis de sentimientos se está utilizando para ayudar a:

El procesamiento de señales es una tecnología habilitadora que abarca la teoría fundamental, las aplicaciones, los algoritmos y las implementaciones del procesamiento o la transferencia de información contenida en muchos formatos físicos, simbólicos o abstractos diferentes, ampliamente designados como señales . Utiliza representaciones, formalismos y técnicas matemáticas, estadísticas, computacionales, heurísticas y lingüísticas para la representación, modelado, análisis, síntesis, descubrimiento, recuperación, detección, adquisición, extracción, aprendizaje, seguridad o análisis forense. Las aplicaciones de muestra incluyen el modelado para el análisis de series de tiempo o la implementación de la fusión de datos para determinar una lectura más precisa combinando datos de un conjunto de fuentes de datos menos precisas (es decir, extrayendo la señal del ruido).

El análisis espacial es el proceso mediante el cual convertimos los datos sin procesar en información útil. Es el proceso de examinar las ubicaciones, los atributos y las relaciones de las características en los datos espaciales mediante la superposición y otras técnicas analíticas para abordar una pregunta o adquirir conocimientos útiles. El análisis espacial extrae o crea nueva información a partir de datos espaciales.

En estadística, el análisis de datos exploratorios es un enfoque para analizar conjuntos de datos para resumir sus características principales, a menudo con métodos visuales. Se puede usar o no un modelo estadístico, pero principalmente EDA es para ver qué nos pueden decir los datos más allá del modelado formal o la tarea de prueba de hipótesis. Las técnicas estadísticas también se utilizan para reducir la probabilidad de errores de Tipo I ("falsos positivos") y errores de Tipo II ("falsos negativos"). Un ejemplo de una aplicación son las pruebas A / B para determinar qué tipos de material de marketing aumentarán más los ingresos.

Ver también: 40 hechos alucinantes sobre Big Data

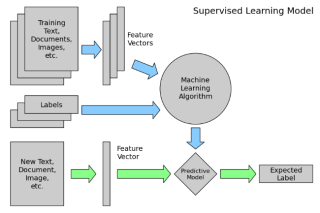

El aprendizaje supervisado es la tarea de aprendizaje automático de inferir una función a partir de datos de entrenamiento etiquetados. Los datos de entrenamiento consisten en un conjunto de ejemplos de entrenamiento . En el aprendizaje supervisado, cada ejemplo es un par que consta de un objeto de entrada (típicamente un vector) y un valor de salida deseado (también llamado señal de supervisión ). Un algoritmo de aprendizaje supervisado analiza los datos de entrenamiento y produce una función inferida, que puede usarse para mapear nuevos ejemplos.

El análisis de redes sociales es una técnica que se utilizó por primera vez en la industria de las telecomunicaciones y luego fue rápidamente adoptada por los sociólogos para estudiar las relaciones interpersonales. Ahora se está aplicando para analizar las relaciones entre personas en muchos campos y actividades comerciales. Los nodos representan a los individuos dentro de una red, mientras que los lazos representan las relaciones entre los individuos.

Modelar el comportamiento de sistemas complejos, a menudo utilizados para pronosticar, predecir y planificar escenarios. Las simulaciones de Monte Carlo, por ejemplo, son una clase de algoritmos que se basan en un muestreo aleatorio repetido, es decir, ejecutan miles de simulaciones, cada una basada en diferentes supuestos. El resultado es un histograma que proporciona una distribución de probabilidad de los resultados. Una aplicación es evaluar la probabilidad de alcanzar los objetivos financieros dadas las incertidumbres sobre el éxito de varias iniciativas.

El análisis de series de tiempo comprende métodos para analizar datos de series de tiempo con el fin de extraer estadísticas significativas y otras características de los datos. Los datos de series de tiempo a menudo surgen al monitorear procesos industriales o rastrear métricas comerciales corporativas. El análisis de series de tiempo tiene en cuenta el hecho de que los puntos de datos tomados a lo largo del tiempo pueden tener una estructura interna (como autocorrelación, tendencia o variación estacional) que debe tenerse en cuenta. Los ejemplos de análisis de series de tiempo incluyen el valor horario de un índice bursátil o el número de pacientes diagnosticados con una condición determinada todos los días.

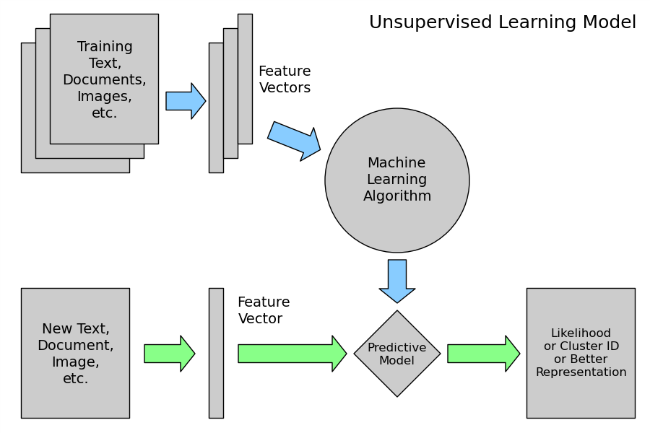

El aprendizaje no supervisado es la tarea de aprendizaje automático de inferir una función para describir una estructura oculta a partir de datos no etiquetados. Dado que los ejemplos que se le dan al alumno no están etiquetados, no hay señal de error o recompensa para evaluar una solución potencial; esto distingue el aprendizaje no supervisado del aprendizaje supervisado y el aprendizaje reforzado.

Sin embargo, el aprendizaje no supervisado también abarca muchas otras técnicas que buscan resumir y explicar las características clave de los datos.

La visualización de datos es la preparación de datos en formato pictórico o gráfico. Permite a los responsables de la toma de decisiones ver los análisis presentados visualmente, de modo que puedan captar conceptos difíciles o identificar nuevos patrones. Con la visualización interactiva, puede llevar el concepto un paso más allá mediante el uso de la tecnología para profundizar en tablas y gráficos para obtener más detalles, cambiando de forma interactiva los datos que ve y cómo se procesan.

Conclusión

El análisis de big data ha sido uno de los avances más importantes en la industria de la tecnología de la información. De hecho, el Big Data ha demostrado su importancia y necesidad en casi todos los sectores, y en todos los departamentos de esas industrias. No hay un solo aspecto de la vida que no se haya visto afectado por Big Data, ni siquiera nuestra vida personal. Por lo tanto, necesitamos Big Data Analytics para administrar esta enorme cantidad de datos de manera eficiente.

Como se dijo antes, esta lista no es exhaustiva. Los investigadores todavía están experimentando nuevas formas de analizar estas enormes cantidades de datos que están presentes en una variedad de formas cuya velocidad de generación aumenta con el tiempo para derivar valores para nuestros usos específicos.

ZPanel, un panel de control de alojamiento web popular, se bifurcó en 2014 a un nuevo proyecto llamado Sentora. Aprende a instalar Sentora en tu servidor con este tutorial.

Aprende cómo instalar Vtiger CRM, una aplicación de gestión de relaciones con el cliente, en CentOS 7 para aumentar tus ventas y mejorar el servicio al cliente.

Esta guía completa le mostrará cómo configurar un servidor Counter-Strike 1.6 en Linux, optimizando el rendimiento y la seguridad para el mejor juego. Aprende los pasos más recientes aquí.

Los ataques de ransomware van en aumento, pero ¿puede la IA ayudar a lidiar con el último virus informático? ¿Es la IA la respuesta? Lea aquí, sepa que la IA es una bendición o una perdición

ReactOS, un sistema operativo de código abierto y gratuito, está aquí con la última versión. ¿Puede satisfacer las necesidades de los usuarios de Windows de hoy en día y acabar con Microsoft? Averigüemos más sobre este estilo antiguo, pero una experiencia de sistema operativo más nueva.

Whatsapp finalmente lanzó la aplicación de escritorio para usuarios de Mac y Windows. Ahora puede acceder a Whatsapp desde Windows o Mac fácilmente. Disponible para Windows 8+ y Mac OS 10.9+

Lea esto para saber cómo la Inteligencia Artificial se está volviendo popular entre las empresas de pequeña escala y cómo está aumentando las probabilidades de hacerlas crecer y dar ventaja a sus competidores.

Recientemente, Apple lanzó macOS Catalina 10.15.4, una actualización complementaria para solucionar problemas, pero parece que la actualización está causando más problemas que conducen al bloqueo de las máquinas Mac. Lee este artículo para obtener más información

13 Herramientas comerciales de extracción de datos de Big Data

Nuestra computadora almacena todos los datos de una manera organizada conocida como sistema de archivos de diario. Es un método eficiente que permite a la computadora buscar y mostrar archivos tan pronto como presiona buscar.