วิธีการติดตั้ง Directus 6.4 CMS บน CentOS 7 LAMP VPS

เรียนรู้วิธีการติดตั้ง Directus 6.4 CMS บน CentOS 7; ระบบการจัดการเนื้อหา Headless ที่มีความยืดหยุ่นสูงและปลอดภัย

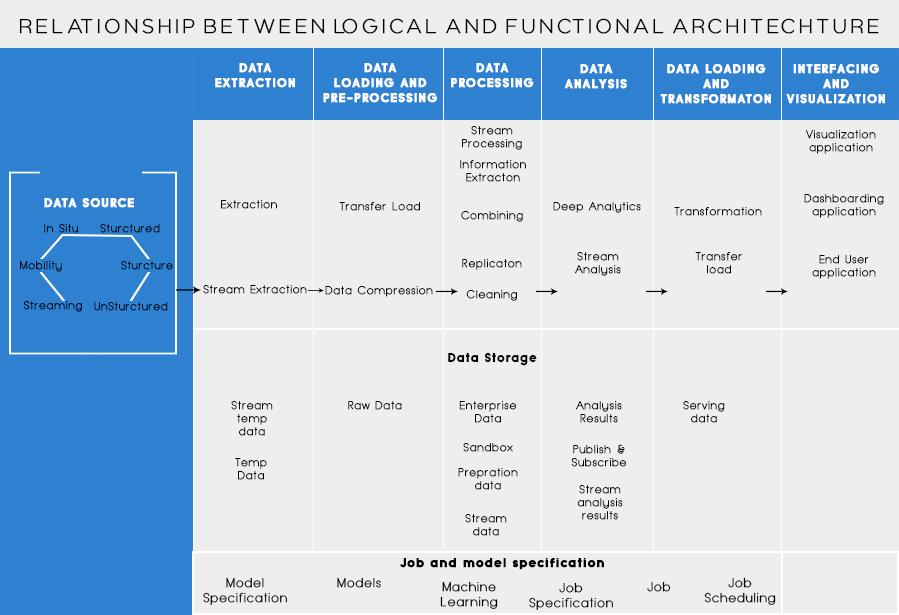

ในโพสต์ที่แล้ว เราได้พูดคุยกันเกี่ยวกับการวิเคราะห์ปัญหาทางธุรกิจและขั้นตอนพื้นฐานในการออกแบบสถาปัตยกรรม Big Data วันนี้ ฉันจะพูดถึงเลเยอร์ต่างๆ ใน Big Data Architecture และฟังก์ชันของเลเยอร์เหล่านั้น

เลเยอร์ตรรกะของสถาปัตยกรรมอ้างอิงข้อมูลขนาดใหญ่

เบื้องหลังสถาปัตยกรรมบิ๊กดาต้า แนวคิดหลักคือการจัดทำเอกสารพื้นฐานที่ถูกต้องของสถาปัตยกรรม โครงสร้างพื้นฐาน และแอปพลิเคชัน ส่งผลให้ธุรกิจต่างๆ ใช้ข้อมูลขนาดใหญ่ได้อย่างมีประสิทธิภาพมากขึ้นทุกวัน

มันถูกสร้างขึ้นโดยนักออกแบบ/สถาปนิกบิ๊กดาต้าก่อนที่จะนำโซลูชันไปใช้จริง การสร้างสถาปัตยกรรมบิ๊กดาต้าโดยทั่วไปต้องมีความเข้าใจในธุรกิจ/องค์กรและความต้องการบิ๊กดาต้า โดยทั่วไป สถาปัตยกรรมบิ๊กดาต้าจะร่างส่วนประกอบฮาร์ดแวร์และซอฟต์แวร์ที่จำเป็นต่อการแก้ปัญหาบิ๊กดาต้า เอกสารสถาปัตยกรรมข้อมูลขนาดใหญ่อาจอธิบายโปรโตคอลสำหรับการแบ่งปันข้อมูล การรวมแอปพลิเคชัน และความปลอดภัยของข้อมูล

ข้อมูลเพิ่มเติม: คู่มือเริ่มต้นสำหรับการวิเคราะห์ข้อมูลขนาดใหญ่

นอกจากนี้ยังเกี่ยวข้องกับการเชื่อมต่อและจัดระเบียบทรัพยากรที่มีอยู่เพื่อตอบสนองความต้องการข้อมูลขนาดใหญ่

เลเยอร์ตรรกะของสถาปัตยกรรมอ้างอิงมีดังนี้:

การทำโปรไฟล์ต้นทางเป็นหนึ่งในขั้นตอนที่สำคัญที่สุดในการตัดสินใจเลือกสถาปัตยกรรมหรือข้อมูลขนาดใหญ่ มันเกี่ยวข้องกับการระบุระบบต้นทางที่แตกต่างกันและจัดหมวดหมู่ตามลักษณะและประเภทของระบบ

ประเด็นที่ต้องพิจารณาขณะทำโปรไฟล์แหล่งข้อมูล:

การนำเข้าข้อมูลเป็นข้อมูลเกี่ยวกับการดึงข้อมูลจากแหล่งที่กล่าวถึงข้างต้น ข้อมูลนี้ถูกเก็บไว้ในที่จัดเก็บและหลังจากนั้นจะถูกแปลงสำหรับการประมวลผลต่อไป

ประเด็นที่ต้องพิจารณา:

หนึ่งควรสามารถจัดเก็บข้อมูลจำนวนมากได้ทุกประเภทและควรสามารถปรับขนาดได้ตามความต้องการ เราควรพิจารณาจำนวน IOPS (การดำเนินการอินพุตเอาต์พุตต่อวินาที) ที่สามารถให้ได้ ระบบไฟล์แบบกระจายของ Hadoop เป็นเฟรมเวิร์กพื้นที่เก็บข้อมูลที่ใช้กันมากที่สุดในโลกของ Big Data ส่วนอื่นๆ ได้แก่ พื้นที่เก็บข้อมูล NoSQL – MongoDB, HBase, Cassandra เป็นต้น

สิ่งที่ต้องพิจารณาขณะวางแผนวิธีการจัดเก็บ:

ไม่เพียงแค่ปริมาณข้อมูลที่จัดเก็บเท่านั้น แต่การประมวลผลยังเพิ่มขึ้นหลายเท่า

ข้อมูลที่เข้าถึงบ่อยก่อนหน้านี้ถูกเก็บไว้ใน Dynamic RAM แต่ตอนนี้ มันถูกเก็บไว้ในดิสก์หลายตัวในเครื่องจำนวนหนึ่งที่เชื่อมต่อผ่านเครือข่ายเนื่องจากมีปริมาณมาก ดังนั้น แทนที่จะรวบรวมข้อมูลสำหรับการประมวลผล โมดูลการประมวลผลจะถูกนำไปที่ข้อมูลขนาดใหญ่ ดังนั้น ลด I/O ของเครือข่ายลงอย่างมาก วิธีการประมวลผลเป็นไปตามข้อกำหนดทางธุรกิจ สามารถจัดประเภทเป็นแบทช์ เรียลไทม์ หรือไฮบริดตาม SLA

เลเยอร์นี้ใช้เอาต์พุตที่มาจากเลเยอร์การประมวลผล ผู้ใช้ที่แตกต่างกัน เช่น ผู้ดูแลระบบ ผู้ใช้ทางธุรกิจ ผู้ขาย คู่ค้า ฯลฯ สามารถใช้ข้อมูลในรูปแบบที่แตกต่างกันได้ ผลลัพธ์ของการวิเคราะห์สามารถใช้ได้โดยกลไกการแนะนำ หรือกระบวนการทางธุรกิจสามารถทริกเกอร์ได้ตามการวิเคราะห์

การใช้ข้อมูลในรูปแบบต่างๆ ได้แก่

อ่านเพิ่มเติม: Big Data: ฝันร้ายในอนาคต?

เลเยอร์การทำงานของสถาปัตยกรรมบิ๊กดาต้า:

อาจมีอีกวิธีหนึ่งในการกำหนดสถาปัตยกรรม กล่าวคือ ผ่านแผนกฟังก์ชันการทำงาน แต่หมวดหมู่การทำงานสามารถจัดกลุ่มเข้าด้วยกันเป็นเลเยอร์ตรรกะของสถาปัตยกรรมอ้างอิง ดังนั้นสถาปัตยกรรมที่ต้องการจึงทำได้โดยใช้ Logical Layers

การแบ่งชั้นตามฟังก์ชันมีดังนี้:

การวิเคราะห์แหล่งที่มาทั้งหมดที่องค์กรได้รับข้อมูลและที่อาจช่วยองค์กรในการตัดสินใจในอนาคตควรแสดงอยู่ในหมวดหมู่นี้ แหล่งข้อมูลที่แสดงในที่นี้โดยไม่คำนึงถึงข้อเท็จจริงว่าข้อมูลมีโครงสร้าง ไม่มีโครงสร้าง หรือกึ่งมีโครงสร้าง

ก่อนที่คุณจะสามารถจัดเก็บ วิเคราะห์ หรือแสดงภาพข้อมูลของคุณ คุณต้องมีบางอย่างเสียก่อน การดึงข้อมูลเป็นเรื่องเกี่ยวกับการนำสิ่งที่ไม่มีโครงสร้างมาใช้ เช่น หน้าเว็บ และเปลี่ยนให้เป็นตารางที่มีโครงสร้าง เมื่อคุณจัดโครงสร้างแล้ว คุณสามารถจัดการได้หลายวิธี โดยใช้เครื่องมือที่อธิบายไว้ด้านล่างเพื่อค้นหาข้อมูลเชิงลึก

ความจำเป็นพื้นฐานในการทำงานกับข้อมูลขนาดใหญ่คือการคิดว่าจะจัดเก็บข้อมูลนั้นอย่างไร ส่วนหนึ่งของการที่ Big Data ถูกมองว่าเป็น “BIG” ก็คือการที่ระบบดั้งเดิมจัดการได้มากเกินไป ผู้ให้บริการจัดเก็บข้อมูลที่ดีควรเสนอโครงสร้างพื้นฐานสำหรับใช้งานเครื่องมือวิเคราะห์อื่นๆ ทั้งหมดของคุณ รวมถึงสถานที่สำหรับจัดเก็บและสืบค้นข้อมูลของคุณ

ขั้นตอนที่จำเป็นก่อนที่เราจะเริ่มต้นขุดข้อมูลเพื่อข้อมูลเชิงลึก แนวทางปฏิบัติที่ดีในการสร้างชุดข้อมูลที่สะอาดและมีโครงสร้างที่ดีถือเป็นแนวทางปฏิบัติที่ดี ชุดข้อมูลสามารถมาในรูปทรงและขนาดต่างๆ ได้ โดยเฉพาะเมื่อมาจากเว็บ เลือกเครื่องมือตามความต้องการข้อมูลของคุณ

การทำเหมืองข้อมูลเป็นกระบวนการในการค้นหาข้อมูลเชิงลึกภายในฐานข้อมูล เป้าหมายของการขุดข้อมูลคือการตัดสินใจและคาดการณ์ข้อมูลที่คุณมีอยู่ เลือกซอฟต์แวร์ที่ให้การคาดการณ์ที่ดีที่สุดสำหรับข้อมูลทุกประเภท และให้คุณสร้างอัลกอริทึมของคุณเองสำหรับการขุดข้อมูล

แม้ว่าการทำเหมืองข้อมูลจะเกี่ยวกับการกลั่นกรองข้อมูลของคุณในการค้นหารูปแบบที่ไม่รู้จักก่อนหน้านี้ การวิเคราะห์ข้อมูลเป็นการทำลายข้อมูลนั้นลงและประเมินผลกระทบของรูปแบบการทำงานล่วงเวลาเหล่านั้น Analytics เป็นการถามคำถามเฉพาะและค้นหาคำตอบในข้อมูล คุณยังสามารถถามคำถามเกี่ยวกับสิ่งที่จะเกิดขึ้นในอนาคตได้อีกด้วย!

การแสดงภาพเป็นวิธีที่สดใสและง่ายดายในการถ่ายทอดข้อมูลเชิงลึกที่ซับซ้อน และส่วนที่ดีที่สุดคือส่วนใหญ่ไม่ต้องการการเข้ารหัส บริษัทสร้างภาพข้อมูลจะทำให้ข้อมูลของคุณมีชีวิตชีวา ความท้าทายส่วนหนึ่งของนักวิทยาศาสตร์ด้านข้อมูลคือการถ่ายทอดข้อมูลเชิงลึกจากข้อมูลนั้นไปยังส่วนอื่นๆ ในบริษัทของคุณ เครื่องมือสามารถช่วยคุณสร้างแผนภูมิ แผนที่ และกราฟิกอื่นๆ จากข้อมูลเชิงลึกของคุณ

แพลตฟอร์มการรวมข้อมูลเป็นตัวเชื่อมระหว่างแต่ละโปรแกรม พวกเขาเชื่อมต่อการอนุมานต่างๆ ของเครื่องมือกับซอฟต์แวร์อื่นๆ คุณสามารถแชร์ผลลัพธ์ของเครื่องมือสร้างภาพของคุณโดยตรงบน Facebook ผ่านเครื่องมือเหล่านี้

จะมีบางครั้งในอาชีพข้อมูลของคุณที่เครื่องมือไม่สามารถตัดมันได้ แม้ว่าเครื่องมือในปัจจุบันจะมีประสิทธิภาพมากขึ้นและใช้งานง่ายขึ้น แต่บางครั้งก็เป็นการดีกว่าที่จะเขียนโค้ดด้วยตัวเอง มีภาษาต่างๆ ที่ช่วยคุณในด้านต่างๆ เช่น การคำนวณทางสถิติและกราฟิก ภาษาเหล่านี้สามารถใช้เป็นส่วนเสริมสำหรับการทำเหมืองข้อมูลและซอฟต์แวร์ทางสถิติ

สิ่งสำคัญที่ต้องจำในการออกแบบ Big Data Architecture คือ:

ฉันรู้ว่าคุณกำลังคิดเกี่ยวกับเครื่องมือต่างๆ ที่จะใช้เพื่อสร้างโซลูชัน Big Data แบบสมบูรณ์ ทั้งในการโพสต์ที่จะเกิดขึ้นของฉันเกี่ยวกับข้อมูลขนาดใหญ่ฉันจะครอบคลุมเครื่องมือที่ดีที่สุดเพื่อให้บรรลุงานที่แตกต่างกันในสถาปัตยกรรมข้อมูลขนาดใหญ่

เรียนรู้วิธีการติดตั้ง Directus 6.4 CMS บน CentOS 7; ระบบการจัดการเนื้อหา Headless ที่มีความยืดหยุ่นสูงและปลอดภัย

เรียนรู้วิธีการตั้งค่า Nginx บน Ubuntu สำหรับการสตรีมวิดีโอสด HLS ด้วยคำแนะนำที่ชัดเจนและเป็นประโยชน์

เรียนรู้การใช้ Percona XtraBackup สำหรับการสำรองข้อมูลด้วยวิธีที่เป็นระบบและง่ายดายบน WordPress ออนไลน์ของคุณ

ReactOS ซึ่งเป็นโอเพ่นซอร์สและระบบปฏิบัติการฟรีพร้อมเวอร์ชันล่าสุดแล้ว สามารถตอบสนองความต้องการของผู้ใช้ Windows ยุคใหม่และล้ม Microsoft ได้หรือไม่? มาหาข้อมูลเพิ่มเติมเกี่ยวกับรูปแบบเก่านี้ แต่เป็นประสบการณ์ OS ที่ใหม่กว่ากัน

การโจมตีของ Ransomware กำลังเพิ่มขึ้น แต่ AI สามารถช่วยจัดการกับไวรัสคอมพิวเตอร์ตัวล่าสุดได้หรือไม่? AI คือคำตอบ? อ่านที่นี่รู้ว่า AI boone หรือ bane

ในที่สุด Whatsapp ก็เปิดตัวแอพเดสก์ท็อปสำหรับผู้ใช้ Mac และ Windows ตอนนี้คุณสามารถเข้าถึง Whatsapp จาก Windows หรือ Mac ได้อย่างง่ายดาย ใช้ได้กับ Windows 8+ และ Mac OS 10.9+

อ่านข้อมูลนี้เพื่อทราบว่าปัญญาประดิษฐ์กำลังได้รับความนิยมในหมู่บริษัทขนาดเล็กอย่างไร และเพิ่มโอกาสในการทำให้พวกเขาเติบโตและทำให้คู่แข่งได้เปรียบ

เมื่อเร็ว ๆ นี้ Apple เปิดตัว macOS Catalina 10.15.4 การอัปเดตเสริมเพื่อแก้ไขปัญหา แต่ดูเหมือนว่าการอัปเดตทำให้เกิดปัญหามากขึ้นที่นำไปสู่การสร้างเครื่อง Mac อ่านบทความนี้เพื่อเรียนรู้เพิ่มเติม

13 เครื่องมือดึงข้อมูลเชิงพาณิชย์ของ Big Data

คอมพิวเตอร์ของเราจัดเก็บข้อมูลทั้งหมดในลักษณะที่เรียกว่าระบบไฟล์บันทึก เป็นวิธีการที่มีประสิทธิภาพที่ช่วยให้คอมพิวเตอร์สามารถค้นหาและแสดงไฟล์ได้ทันทีที่คุณกดค้นหาhttps://wethegeek.com/?p=94116&preview=true