Kann KI mit zunehmender Anzahl von Ransomware-Angriffen kämpfen?

Ransomware-Angriffe nehmen zu, aber kann KI helfen, den neuesten Computervirus zu bekämpfen? Ist KI die Antwort? Lesen Sie hier, ob KI boone oder bane ist

„ Big Data “ ist die Anwendung spezialisierter Techniken und Technologien zur Verarbeitung sehr großer Datenmengen. Diese Datensätze sind oft so groß und komplex, dass es schwierig wird, sie mit verfügbaren Datenbankverwaltungstools zu verarbeiten.

Das radikale Wachstum der Informationstechnologie hat zu mehreren komplementären Bedingungen in der Branche geführt. Eines der hartnäckigsten und wohl präsentesten Ergebnisse ist das Vorhandensein von Big Data. Der Begriff Big Data ist ein Schlagwort, das geprägt wurde, um das Vorhandensein riesiger Datenmengen zu beschreiben. Der resultierende Effekt einer so großen Datenmenge ist Data Analytics.

Data Analytics ist der Prozess der Strukturierung von Big Data. Innerhalb von Big Data gibt es unterschiedliche Muster und Zusammenhänge, die es Data Analytics ermöglichen, die Daten besser kalkuliert zu charakterisieren. Dies macht Datenanalyse zu einem der wichtigsten Teile der Informationstechnologie.

Daher liste ich hier die 26 Big-Data-Analysetechniken auf. Diese Liste ist keineswegs vollständig.

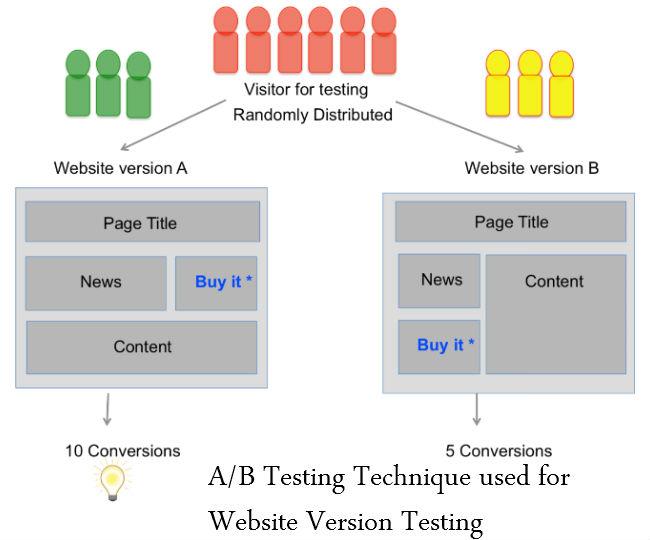

A/B-Tests

A/B-Tests sind ein Bewertungstool, mit dem festgestellt werden kann, welche Version einer Webseite oder App einer Organisation oder Einzelperson hilft, ein Geschäftsziel effektiver zu erreichen. Diese Entscheidung wird getroffen, indem verglichen wird, welche Version von etwas besser funktioniert. A/B-Tests werden häufig in der Webentwicklung verwendet, um sicherzustellen, dass Änderungen an einer Webseite oder Seitenkomponente auf Daten und nicht auf der persönlichen Meinung beruhen.

Es wird auch als Verschüttungstest oder Eimertest bezeichnet.

Siehe auch: Die Big-Data-Grauzone – Do's and Don'ts

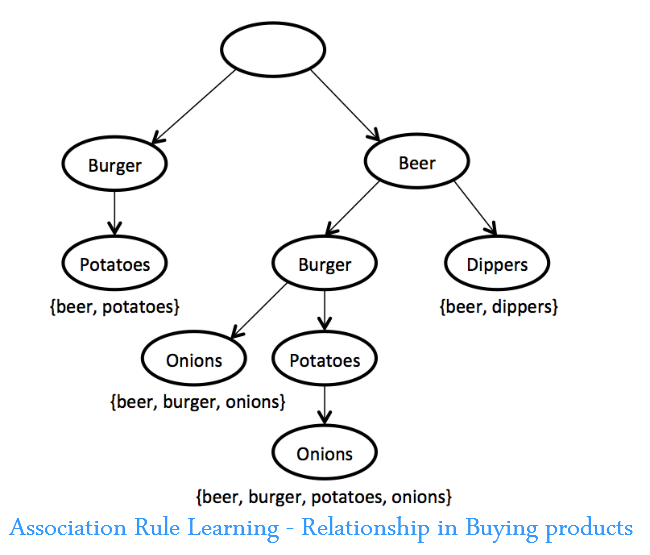

Assoziationsregel lernen

Eine Reihe von Techniken zum Entdecken interessanter Beziehungen, dh „Assoziationsregeln“, zwischen Variablen in großen Datenbanken. Diese Techniken bestehen aus einer Vielzahl von Algorithmen, um mögliche Regeln zu generieren und zu testen.

Eine Anwendung ist die Warenkorbanalyse, bei der ein Händler feststellen kann, welche Produkte häufig zusammen gekauft werden und diese Informationen für das Marketing nutzen. (Ein häufig zitiertes Beispiel ist die Entdeckung, dass viele Supermarktkäufer, die Nachos kaufen, auch Bier kaufen.)

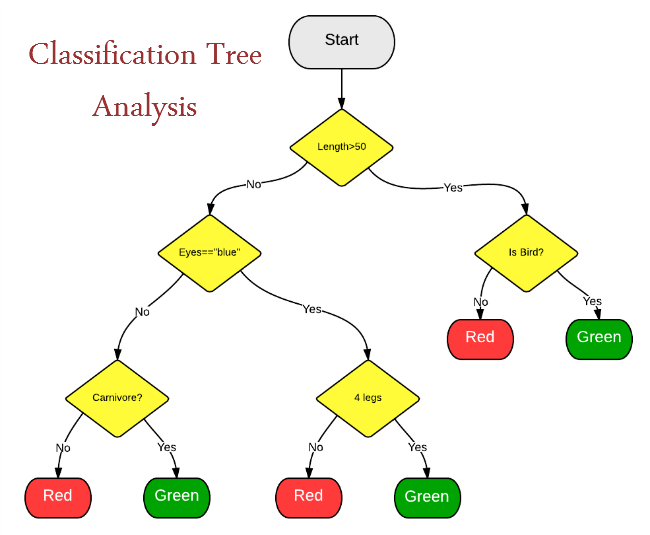

Klassifikationsbaumanalyse

Statistische Klassifikation ist eine Methode zur Identifizierung von Kategorien, zu denen eine neue Beobachtung gehört. Es erfordert einen Trainingssatz korrekt identifizierter Beobachtungen – mit anderen Worten historische Daten.

Die statistische Klassifizierung wird verwendet, um:

Clusteranalyse

Ein statistisches Verfahren zur Klassifizierung von Objekten, das eine diverse Gruppe in kleinere Gruppen ähnlicher Objekte aufteilt, deren Ähnlichkeitsmerkmale nicht im Voraus bekannt sind. Ein Beispiel für die Clusteranalyse ist die Segmentierung von Verbrauchern in selbstähnliche Gruppen für gezieltes Marketing. Wird für Data-Mining verwendet.

Crowdsourcing

Beim Crowdsourcing besteht die Nuance darin, dass eine Aufgabe oder ein Job ausgelagert wird, jedoch nicht an eine bestimmte Fachkraft oder Organisation, sondern in Form eines offenen Aufrufs an die Öffentlichkeit. Crowdsourcing ist eine Technik, die eingesetzt werden kann, um Daten aus verschiedenen Quellen wie Textnachrichten, Social-Media-Updates, Blogs usw. zu sammeln. Dies ist eine Art von Massenkollaboration und eine Instanz der Nutzung des Webs.

Datenfusion und Datenintegration

Ein mehrstufiger Prozess, der sich mit der Assoziation, Korrelation, Kombination von Daten und Informationen aus einzelnen und mehreren Quellen befasst, um eine verfeinerte Position zu erreichen, Schätzungen zu identifizieren und Situationen, Bedrohungen und deren Bedeutung vollständig und zeitnah zu bewerten.

Datenfusionstechniken kombinieren Daten von mehreren Sensoren und verwandte Informationen aus zugehörigen Datenbanken, um eine verbesserte Genauigkeit und spezifischere Schlussfolgerungen zu erreichen, als dies durch die Verwendung eines einzigen Sensors allein erreicht werden könnte.

Siehe auch: Ein Leitfaden für Anfänger zur Big-Data-Analyse

Data-Mining

Data Mining ist das Sortieren von Daten, um Muster zu erkennen und Beziehungen herzustellen. Data Mining bezieht sich auf die kollektiven Datenextraktionstechniken, die mit großen Datenmengen durchgeführt werden. Zu den Data-Mining-Parametern gehören Assoziation, Sequenzanalyse, Klassifizierung, Clustering und Prognose.

Zu den Anwendungen gehören das Mining von Kundendaten, um Segmente zu bestimmen, die am wahrscheinlichsten auf ein Angebot reagieren, das Mining von Personaldaten, um die Merkmale der erfolgreichsten Mitarbeiter zu identifizieren, oder die Warenkorbanalyse, um das Kaufverhalten von Kunden zu modellieren.

Ensemble-Lernen

Es ist eine Kunst, verschiedene Lernalgorithmen zu kombinieren, um die Stabilität und Vorhersagekraft des Modells zu improvisieren. Dies ist eine Form des überwachten Lernens.

Genetische Algorythmen

Optimierungstechniken, die Prozesse wie genetische Kombination, Mutation und natürliche Selektion in einem Design verwenden, das auf den Konzepten der natürlichen Evolution basiert. Genetische Algorithmen sind Techniken, die verwendet werden, um die am häufigsten angesehenen Videos, Fernsehsendungen und andere Medienformen zu identifizieren. Es gibt ein evolutionäres Muster, das durch den Einsatz genetischer Algorithmen erreicht werden kann. Video- und Medienanalysen können durch den Einsatz genetischer Algorithmen durchgeführt werden.

Maschinelles Lernen

Maschinelles Lernen ist eine weitere Technik, die verwendet werden kann, um zu kategorisieren und das wahrscheinliche Ergebnis eines bestimmten Datensatzes zu bestimmen. Machine Learning definiert eine Software, die in der Lage sein kann, die möglichen Ergebnisse eines bestimmten Ereignisses zu bestimmen. Es wird daher in der Predictive Analytics verwendet. Ein Beispiel für Predictive Analytics ist die Gewinnwahrscheinlichkeit von Rechtsfällen oder der Erfolg bestimmter Produktionen.

Verarbeitung natürlicher Sprache

Eine Reihe von Techniken aus einem Teilgebiet der Informatik (in einem Bereich, der historisch als „künstliche Intelligenz“ bezeichnet wird) und der Linguistik, die Computeralgorithmen zur Analyse der menschlichen (natürlichen) Sprache verwendet. Viele NLP-Techniken sind Arten des maschinellen Lernens. Eine Anwendung von NLP ist die Sentimentanalyse in sozialen Medien, um zu bestimmen, wie potenzielle Kunden auf eine Branding-Kampagne reagieren.

Neuronale Netze

Nichtlineare Vorhersagemodelle, die durch Training lernen und in ihrer Struktur biologischen neuronalen Netzen ähneln. Sie können zur Mustererkennung und -optimierung verwendet werden. Einige neuronale Netzanwendungen beinhalten überwachtes Lernen und andere beinhalten unüberwachtes Lernen. Beispiele für Anwendungen sind die Identifizierung hochwertiger Kunden, bei denen das Risiko besteht, ein bestimmtes Unternehmen zu verlassen, und die Identifizierung betrügerischer Versicherungsansprüche.

Lesen Sie auch: 40 verblüffende Fakten über Big Data

Optimierung

Ein Portfolio numerischer Techniken, die verwendet werden, um komplexe Systeme und Prozesse neu zu entwerfen, um ihre Leistung gemäß einem oder mehreren objektiven Maßen (z. B. Kosten, Geschwindigkeit oder Zuverlässigkeit) zu verbessern. Beispiele für Anwendungen sind die Verbesserung betrieblicher Prozesse wie Terminplanung, Routing und Raumaufteilung sowie das Treffen strategischer Entscheidungen wie Produktsortimentsstrategie, verknüpfte Investitionsanalyse und F&E-Portfoliostrategie. Genetische Algorithmen sind ein Beispiel für eine Optimierungstechnik.

In meinem nächsten Blog beschreibe ich die verbleibenden 13 Big-Data-Analysetechniken.

Lesen Sie: Nächster Teil von Ein Einblick in 26 Big-Data-Analysetechniken

Ransomware-Angriffe nehmen zu, aber kann KI helfen, den neuesten Computervirus zu bekämpfen? Ist KI die Antwort? Lesen Sie hier, ob KI boone oder bane ist

ReactOS, ein quelloffenes und kostenloses Betriebssystem, ist hier mit der neuesten Version. Kann es den Anforderungen moderner Windows-Benutzer genügen und Microsoft zu Fall bringen? Lassen Sie uns mehr über dieses alte, aber neuere Betriebssystem erfahren.

Whatsapp hat endlich die Desktop-App für Mac- und Windows-Benutzer auf den Markt gebracht. Jetzt können Sie ganz einfach von Windows oder Mac auf WhatsApp zugreifen. Verfügbar für Windows 8+ und Mac OS 10.9+

Lesen Sie dies, um zu erfahren, wie Künstliche Intelligenz bei kleinen Unternehmen beliebt wird und wie sie die Wahrscheinlichkeit erhöht, sie wachsen zu lassen und ihren Konkurrenten einen Vorsprung zu verschaffen.

Vor kurzem hat Apple macOS Catalina 10.15.4 als Ergänzungsupdate veröffentlicht, um Probleme zu beheben, aber es scheint, dass das Update mehr Probleme verursacht, die zum Bricking von Mac-Computern führen. Lesen Sie diesen Artikel, um mehr zu erfahren

13 Tools zur kommerziellen Datenextraktion von Big Data

Unser Computer speichert alle Daten in einer organisierten Weise, die als Journaling-Dateisystem bekannt ist. Es ist eine effiziente Methode, die es dem Computer ermöglicht, Dateien zu suchen und anzuzeigen, sobald Sie auf die Suche klicken.https://wethegeek.com/?p=94116&preview=true

Da sich die Wissenschaft schnell weiterentwickelt und einen Großteil unserer Bemühungen übernimmt, steigt auch das Risiko, uns einer unerklärlichen Singularität auszusetzen. Lesen Sie, was Singularität für uns bedeuten könnte.

Ein Einblick in 26 Big-Data-Analysetechniken: Teil 1

KI im Gesundheitswesen hat in den letzten Jahrzehnten große Fortschritte gemacht. Somit wächst die Zukunft der KI im Gesundheitswesen immer noch von Tag zu Tag.