Kann KI mit zunehmender Anzahl von Ransomware-Angriffen kämpfen?

Ransomware-Angriffe nehmen zu, aber kann KI helfen, den neuesten Computervirus zu bekämpfen? Ist KI die Antwort? Lesen Sie hier, ob KI boone oder bane ist

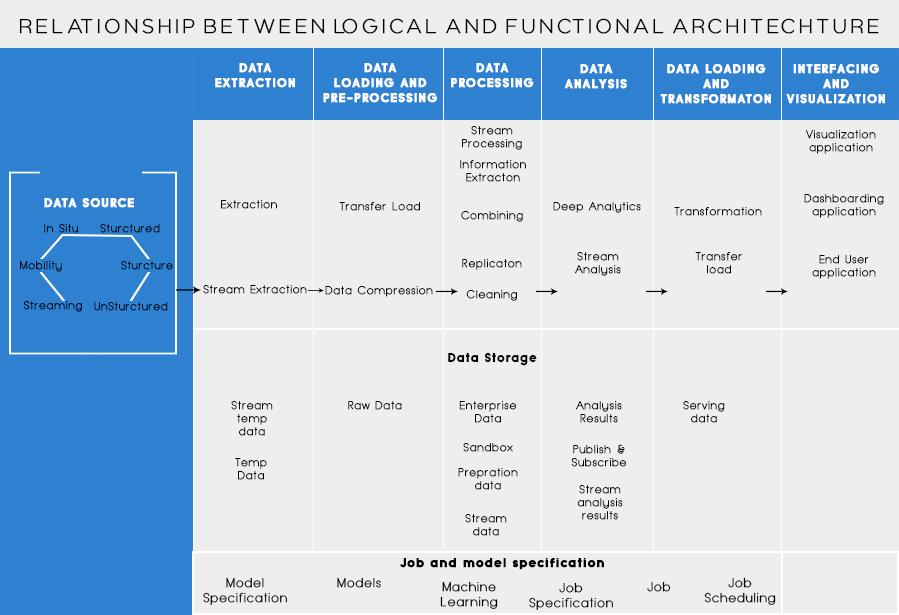

In meinem letzten Beitrag haben wir über die Analyse des Geschäftsproblems und grundlegende Schritte zum Entwerfen der Big-Data-Architektur gesprochen. Heute werde ich über verschiedene Schichten in der Big Data Architektur und deren Funktionalitäten sprechen.

Logische Schichten der Big-Data-Referenzarchitektur

Der Kerngedanke der Big-Data-Architektur besteht darin, ein richtiges Fundament von Architektur, Infrastruktur und Anwendungen zu dokumentieren. Dadurch können Unternehmen Big Data im Alltag effektiver nutzen.

Es wird von Big-Data-Designern/-Architekten erstellt, bevor eine Lösung physisch implementiert wird. Die Erstellung einer Big-Data-Architektur erfordert im Allgemeinen das Verständnis des Geschäfts/der Organisation und ihrer Big-Data-Anforderungen. Typischerweise skizzieren Big-Data-Architekturen die Hardware- und Softwarekomponenten, die zur Erfüllung einer Big-Data-Lösung erforderlich sind. Big-Data-Architekturdokumente können auch Protokolle für die gemeinsame Nutzung von Daten, Anwendungsintegrationen und Informationssicherheit beschreiben.

Weitere Informationen: Ein Leitfaden für Anfänger zur Big-Data-Analyse

Dazu gehört auch die Vernetzung und Organisation vorhandener Ressourcen, um Big-Data-Anforderungen zu erfüllen.

The logical layers of the reference architecture are as below:

Source profiling is one of the most important steps in deciding the architecture or big data. It involves identifying different source systems and categorizing them, based on their nature and type.

Points to be considered while profiling data sources:

Bei der Datenaufnahme dreht sich alles um die Extraktion der Daten aus den oben genannten Quellen. Diese Daten werden im Speicher gespeichert und anschließend zur weiteren Verarbeitung darauf umgewandelt.

Zu berücksichtigende Punkte:

One should be able to store large amounts of data of any type and should be able to scale on need basis. We should also consider the number of IOPS (Input output operations per second) that it can provide. Hadoop distributed file system is the most commonly used storage framework in Big Data world, others are the NoSQL data stores – MongoDB, HBase, Cassandra etc.

Things to consider while planning storage methodology:

Not only the amount of data being stored but the processing also has increased multifold.

Daten, auf die früher häufig zugegriffen wurde, wurden in dynamischen RAMs gespeichert. Aber jetzt wird es aufgrund des Volumens auf mehreren Festplatten auf einer Reihe von Computern gespeichert, die über das Netzwerk verbunden sind. Anstatt Datenblöcke für die Verarbeitung zu sammeln, werden daher Verarbeitungsmodule für Big Data verwendet. Dadurch wird die Netzwerk-E/A erheblich reduziert. Die Verarbeitungsmethodik richtet sich nach den Geschäftsanforderungen. Es kann basierend auf dem SLA in Batch, Echtzeit oder Hybrid kategorisiert werden.

Diese Schicht verbraucht die von der Verarbeitungsschicht bereitgestellte Ausgabe. Verschiedene Benutzer wie Administrator, Geschäftsbenutzer, Anbieter, Partner usw. können Daten in unterschiedlichen Formaten konsumieren. Die Analyseausgabe kann von der Empfehlungsmaschine verwendet werden oder Geschäftsprozesse können basierend auf der Analyse ausgelöst werden.

Verschiedene Formen des Datenverbrauchs sind:

Lesen Sie auch: Big Data: Ein Albtraum der Zukunft?

Funktionsschichten der Big-Data-Architektur:

There could be one more way of defining the architecture i.e. is through the functionality division. But the functionality categories could be grouped together into the logical layer of reference architecture, so, the preferred Architecture is one done using Logical Layers.

The layering based on the Functionalities is as below:

Analyzing all the sources from which an organization receives a data and which could help the organization in making its future decisions should be listed in this category. The data sources listed here are irrespective of the fact whether the data is structured, unstructured or semi-structured.

Before you can store, analyze or visualize your data, you’ve got to have some. Data extraction is all about taking something that is unstructured, like a webpage, and turning it into a structured table. Once you’ve got it structured, you can manipulate it in all sorts of ways, using the tools described below, to find insights.

The basic necessity while working with big data is to think how to store that data. Part of how Big Data got the distinction as “BIG” is that it became too much for the traditional systems to handle. A good data storage provider should offer you an infrastructure on which to run all your other analytics tools as well as a place to store and query your data.

Ein notwendiger Schritt, bevor wir tatsächlich damit beginnen, die Daten zu gewinnen, um Erkenntnisse zu gewinnen. Es empfiehlt sich immer, einen sauberen, gut strukturierten Datensatz zu erstellen. Datensätze können in allen Formen und Größen vorliegen, insbesondere wenn sie aus dem Internet stammen. Wählen Sie ein Tool gemäß Ihren Datenanforderungen.

Data Mining ist der Prozess der Gewinnung von Erkenntnissen in einer Datenbank. Das Ziel von Data Mining ist es, Entscheidungen und Vorhersagen über die Ihnen zur Verfügung stehenden Daten zu treffen. Wählen Sie eine Software, die Ihnen die besten Vorhersagen für alle Arten von Daten liefert und Ihnen ermöglicht, Ihre eigenen Algorithmen zum Mining der Daten zu erstellen.

Während es beim Data Mining darum geht, Ihre Daten auf der Suche nach zuvor nicht erkannten Mustern zu durchsuchen, geht es bei der Datenanalyse darum, diese Daten aufzuschlüsseln und die Auswirkungen dieser Muster im Laufe der Zeit zu bewerten. Bei Analytics geht es darum, spezifische Fragen zu stellen und die Antworten in Daten zu finden. Sie können sogar Fragen stellen, was in Zukunft passieren wird!

Visualisierungen sind eine helle und einfache Möglichkeit, komplexe Dateneinblicke zu vermitteln. Und das Beste daran ist, dass die meisten von ihnen keine Codierung erfordern. Datenvisualisierungsunternehmen erwecken Ihre Daten zum Leben. Ein Teil der Herausforderung für jeden Data Scientist besteht darin, die Erkenntnisse aus diesen Daten an den Rest Ihres Unternehmens weiterzugeben. Tools können Ihnen dabei helfen, aus Ihren Datenerkenntnissen Diagramme, Karten und ähnliche Grafiken zu erstellen.

Datenintegrationsplattformen sind der Klebstoff zwischen den einzelnen Programmen. Sie verbinden die unterschiedlichen Schlüsse der Tools mit anderen Softwares. Über diese Tools können Sie die Ergebnisse Ihrer Visualisierungstools direkt auf Facebook teilen.

Es wird Zeiten in Ihrer Datenkarriere geben, in denen ein Tool einfach nicht ausreicht. Während die heutigen Tools immer leistungsfähiger und benutzerfreundlicher werden, ist es manchmal einfach besser, sie selbst zu programmieren. Es gibt verschiedene Sprachen, die Ihnen bei verschiedenen Aspekten wie statistischen Berechnungen und Grafiken helfen. Diese Sprachen könnten als Ergänzung für die Data-Mining- und Statistik-Software dienen.

Die wichtigsten Dinge, die Sie beim Entwerfen einer Big-Data-Architektur beachten sollten, sind:

Ich weiß, dass Sie über verschiedene Tools nachdenken würden, die Sie verwenden können, um eine umfassende Big Data-Lösung zu erstellen. Nun, in meinen kommenden Posts zu Big Data werde ich einige der besten Tools behandeln, um verschiedene Aufgaben in der Big-Data-Architektur zu erfüllen .

Ransomware-Angriffe nehmen zu, aber kann KI helfen, den neuesten Computervirus zu bekämpfen? Ist KI die Antwort? Lesen Sie hier, ob KI boone oder bane ist

ReactOS, ein quelloffenes und kostenloses Betriebssystem, ist hier mit der neuesten Version. Kann es den Anforderungen moderner Windows-Benutzer genügen und Microsoft zu Fall bringen? Lassen Sie uns mehr über dieses alte, aber neuere Betriebssystem erfahren.

Whatsapp hat endlich die Desktop-App für Mac- und Windows-Benutzer auf den Markt gebracht. Jetzt können Sie ganz einfach von Windows oder Mac auf WhatsApp zugreifen. Verfügbar für Windows 8+ und Mac OS 10.9+

Lesen Sie dies, um zu erfahren, wie Künstliche Intelligenz bei kleinen Unternehmen beliebt wird und wie sie die Wahrscheinlichkeit erhöht, sie wachsen zu lassen und ihren Konkurrenten einen Vorsprung zu verschaffen.

Vor kurzem hat Apple macOS Catalina 10.15.4 als Ergänzungsupdate veröffentlicht, um Probleme zu beheben, aber es scheint, dass das Update mehr Probleme verursacht, die zum Bricking von Mac-Computern führen. Lesen Sie diesen Artikel, um mehr zu erfahren

13 Tools zur kommerziellen Datenextraktion von Big Data

Unser Computer speichert alle Daten in einer organisierten Weise, die als Journaling-Dateisystem bekannt ist. Es ist eine effiziente Methode, die es dem Computer ermöglicht, Dateien zu suchen und anzuzeigen, sobald Sie auf die Suche klicken.https://wethegeek.com/?p=94116&preview=true

Da sich die Wissenschaft schnell weiterentwickelt und einen Großteil unserer Bemühungen übernimmt, steigt auch das Risiko, uns einer unerklärlichen Singularität auszusetzen. Lesen Sie, was Singularität für uns bedeuten könnte.

Ein Einblick in 26 Big-Data-Analysetechniken: Teil 1

KI im Gesundheitswesen hat in den letzten Jahrzehnten große Fortschritte gemacht. Somit wächst die Zukunft der KI im Gesundheitswesen immer noch von Tag zu Tag.