Comment générer des clés SSH?

Découvrez comment générer une clé SSH pour accéder à votre serveur sans mot de passe. Suivez nos étapes faciles à comprendre pour créer et ajouter des clés SSH.

Dans mon dernier article , nous avons discuté de l'analyse du problème commercial et des étapes de base pour concevoir l'architecture Big Data. Aujourd'hui, je vais parler des différentes couches de l'architecture Big Data et de leurs fonctionnalités.

Couches logiques de l'architecture de référence Big Data

Derrière l'architecture Big Data, l'idée centrale est de documenter une bonne base d'architecture, d'infrastructure et d'applications. Par conséquent, cela permet aux entreprises d'utiliser le Big Data plus efficacement au quotidien.

Il est créé par des concepteurs/architectes Big Data avant de mettre physiquement en œuvre une solution. La création d'une architecture Big Data nécessite généralement de comprendre l'entreprise/l'organisation et ses besoins en Big Data. En règle générale, les architectures Big Data décrivent les composants matériels et logiciels nécessaires à la réalisation d'une solution Big Data. Les documents d'architecture de Big Data peuvent également décrire des protocoles de partage de données, d'intégration d'applications et de sécurité de l'information.

Plus d'informations : Guide du débutant sur l'analyse des mégadonnées

Cela implique également d'interconnecter et d'organiser les ressources existantes pour répondre aux besoins de Big Data.

Les couches logiques de l'architecture de référence sont les suivantes :

Le profilage de la source est l'une des étapes les plus importantes pour décider de l'architecture ou du Big Data. Il s'agit d'identifier les différents systèmes sources et de les catégoriser en fonction de leur nature et de leur type.

Points à prendre en compte lors du profilage des sources de données :

L'ingestion de données consiste à extraire les données des sources mentionnées ci-dessus. Ces données sont stockées dans le stockage, puis transformées pour un traitement ultérieur.

Points à considérer :

On devrait être capable de stocker de grandes quantités de données de tout type et devrait pouvoir évoluer en fonction des besoins. Nous devons également considérer le nombre d'IOPS (opérations d'entrée et de sortie par seconde) qu'il peut fournir. Le système de fichiers distribué Hadoop est le cadre de stockage le plus couramment utilisé dans le monde du Big Data, les autres sont les magasins de données NoSQL - MongoDB, HBase, Cassandra, etc.

Éléments à prendre en compte lors de la planification de la méthodologie de stockage :

Non seulement la quantité de données stockées, mais le traitement a également été multiplié par plusieurs.

Auparavant, les données fréquemment consultées étaient stockées dans des RAM dynamiques. Mais maintenant, il est stocké sur plusieurs disques sur un certain nombre de machines connectées via le réseau en raison du volume considérable. Par conséquent, au lieu de collecter des morceaux de données pour le traitement, les modules de traitement sont transférés vers les mégadonnées. Ainsi, réduisant considérablement les E/S du réseau. La méthodologie de traitement est guidée par les exigences de l'entreprise. Il peut être classé en batch, en temps réel ou hybride en fonction du SLA.

Cette couche consomme la sortie fournie par la couche de traitement. Différents utilisateurs tels que l'administrateur, les utilisateurs professionnels, les fournisseurs, les partenaires, etc. peuvent consommer des données dans différents formats. La sortie de l'analyse peut être consommée par le moteur de recommandation ou les processus métier peuvent être déclenchés en fonction de l'analyse.

Les différentes formes de consommation de données sont :

Lire aussi : Big Data : un futur cauchemar ?

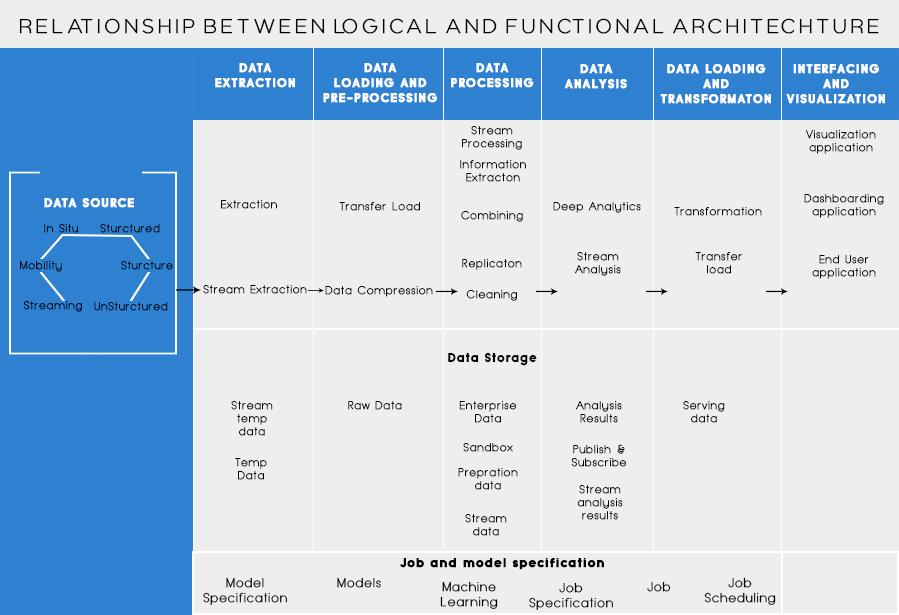

Couches fonctionnelles de l'architecture Big Data :

Il pourrait y avoir une autre façon de définir l'architecture, c'est-à-dire à travers la division des fonctionnalités. Mais les catégories de fonctionnalités pourraient être regroupées dans la couche logique de l'architecture de référence, donc, l'architecture préférée est celle réalisée à l'aide de couches logiques.

La superposition basée sur les fonctionnalités est la suivante :

L'analyse de toutes les sources à partir desquelles une organisation reçoit des données et qui pourraient aider l'organisation à prendre ses décisions futures devrait être répertoriée dans cette catégorie. Les sources de données répertoriées ici sont indépendantes du fait que les données soient structurées, non structurées ou semi-structurées.

Avant de pouvoir stocker, analyser ou visualiser vos données, vous devez en avoir. L'extraction de données consiste à prendre quelque chose qui n'est pas structuré, comme une page Web, et à le transformer en un tableau structuré. Une fois que vous l'avez structuré, vous pouvez le manipuler de toutes sortes de manières, en utilisant les outils décrits ci-dessous, pour trouver des informations.

La nécessité de base lorsque l'on travaille avec des données volumineuses est de réfléchir à la manière de stocker ces données. Une partie de la façon dont le Big Data a obtenu la distinction de « BIG » est qu'il est devenu trop difficile à gérer pour les systèmes traditionnels. Un bon fournisseur de stockage de données devrait vous offrir une infrastructure sur laquelle exécuter tous vos autres outils d'analyse ainsi qu'un endroit pour stocker et interroger vos données.

Une étape préalable nécessaire avant de commencer à exploiter les données pour obtenir des informations. Il est toujours recommandé de créer un ensemble de données propre et bien structuré. Les ensembles de données peuvent être de toutes formes et de toutes tailles, en particulier lorsqu'ils proviennent du Web. Choisissez un outil selon vos besoins en données.

L'exploration de données est le processus de découverte d'informations dans une base de données. Le but de l'exploration de données est de prendre des décisions et des prédictions sur les données dont vous disposez. Choisissez un logiciel qui vous donne les meilleures prédictions pour tous les types de données et vous permet de créer vos propres algorithmes pour extraire les données.

Alors que l'exploration de données consiste à passer au crible vos données à la recherche de modèles auparavant non reconnus, l'analyse des données consiste à décomposer ces données et à évaluer l'impact de ces modèles au fil du temps. L'analyse consiste à poser des questions spécifiques et à trouver les réponses dans les données. Vous pouvez même poser des questions sur ce qui se passera dans le futur !

Les visualisations sont un moyen clair et facile de transmettre des informations complexes sur les données. Et le meilleur, c'est que la plupart d'entre eux ne nécessitent aucun codage. Les entreprises de visualisation de données donneront vie à vos données. Une partie du défi pour tout scientifique des données consiste à transmettre les informations de ces données au reste de votre entreprise. Les outils peuvent vous aider à créer des graphiques, des cartes et d'autres graphiques à partir de vos informations de données.

Les plates-formes d'intégration de données sont le ciment entre chaque programme. Ils relient les différentes inférences des outils avec d'autres logiciels. Vous pouvez partager les résultats de vos outils de visualisation directement sur Facebook grâce à ces outils.

Il y aura des moments dans votre carrière de données où un outil ne suffira tout simplement pas. Alors que les outils d'aujourd'hui deviennent de plus en plus puissants et plus faciles à utiliser, il est parfois préférable de les coder vous-même. Il existe différents langages qui vous aident dans différents aspects tels que le calcul statistique et les graphiques. Ces langages pourraient fonctionner en complément des logiciels d'exploration de données et de statistiques.

Les éléments clés à retenir lors de la conception d'une architecture Big Data sont :

Je sais que vous penseriez à différents outils à utiliser pour créer une solution Big Data à toute épreuve. Eh bien, dans mes prochains articles sur le Big Data, je couvrirai certains des meilleurs outils pour réaliser différentes tâches dans l'architecture Big Data .

Découvrez comment générer une clé SSH pour accéder à votre serveur sans mot de passe. Suivez nos étapes faciles à comprendre pour créer et ajouter des clés SSH.

Découvrez comment créer un serveur de messagerie avec hMailServer sous Windows pour recevoir des e-mails facilement.

Les attaques de ransomware sont en augmentation, mais l'IA peut-elle aider à lutter contre le dernier virus informatique ? L'IA est-elle la réponse ? Lisez ici, sachez que l'IA est un boone ou un fléau

ReactOS, un système d'exploitation open source et gratuit est ici avec la dernière version. Cela peut-il suffire aux besoins des utilisateurs de Windows modernes et faire tomber Microsoft ? Découvrons-en plus sur cet ancien style, mais une expérience de système d'exploitation plus récente.

Whatsapp a finalement lancé l'application de bureau pour les utilisateurs Mac et Windows. Vous pouvez désormais accéder facilement à Whatsapp depuis Windows ou Mac. Disponible pour Windows 8+ et Mac OS 10.9+

Lisez ceci pour savoir comment l'intelligence artificielle devient populaire parmi les petites entreprises et comment elle augmente les probabilités de les faire grandir et de donner à leurs concurrents un avantage.

Récemment, Apple a publié macOS Catalina 10.15.4, une mise à jour supplémentaire pour résoudre les problèmes, mais il semble que la mise à jour cause davantage de problèmes, ce qui entraîne le bridage des machines mac. Lisez cet article pour en savoir plus

13 outils commerciaux d'extraction de données de Big Data

Notre ordinateur stocke toutes les données d'une manière organisée connue sous le nom de système de fichiers de journalisation. C'est une méthode efficace qui permet à l'ordinateur de rechercher et d'afficher des fichiers dès que vous appuyez sur la recherche.https://wethegeek.com/?p=94116&preview=true

Alors que la science évolue à un rythme rapide, prenant le pas sur une grande partie de nos efforts, les risques de nous soumettre à une Singularité inexplicable augmentent également. Lisez, ce que la singularité pourrait signifier pour nous.