Comment générer des clés SSH?

Découvrez comment générer une clé SSH pour accéder à votre serveur sans mot de passe. Suivez nos étapes faciles à comprendre pour créer et ajouter des clés SSH.

Jusqu'à présent, dans mes blogs sur le Big Data , je vous ai présenté différents aspects du Big Data, de ce que cela signifie réellement aux faits et aux choses à faire et à ne pas faire. Dans le blog précédent, nous avons vu quelques techniques d'analyse de Big Data. Aller plus loin dans la liste dans ce blog.

La reconnaissance de formes est une branche de l'apprentissage automatique qui se concentre sur la reconnaissance de formes et de régularités dans les données, bien qu'elle soit dans certains cas considérée comme presque synonyme d'apprentissage automatique. Les systèmes de reconnaissance de formes sont dans de nombreux cas entraînés à partir de données « d'entraînement » étiquetées (apprentissage supervisé), mais lorsqu'aucune donnée étiquetée n'est disponible, d'autres algorithmes peuvent être utilisés pour découvrir des modèles auparavant inconnus (apprentissage non supervisé).

L'analyse prédictive comprend une variété de techniques qui prédisent les résultats futurs sur la base de données historiques et actuelles. Dans la pratique, l'analyse prédictive peut être appliquée à presque toutes les disciplines - de la prédiction de la panne des moteurs à réaction sur la base du flux de données de plusieurs milliers de capteurs, à la prédiction des prochains mouvements des clients en fonction de ce qu'ils achètent, quand ils achètent et même ce qu'ils achètent. disent-ils sur les réseaux sociaux. Les techniques d'analyse prédictive sont principalement basées sur des méthodes statistiques.

Voir aussi : Guide du débutant sur l'analyse des mégadonnées

Il s'agit d'une technique qui utilise des variables indépendantes et la façon dont elles affectent les variables dépendantes. Cela peut être une technique très utile pour déterminer l'analyse des médias sociaux, comme la probabilité de trouver l'amour sur une plate-forme Internet.

L'analyse des sentiments aide les chercheurs à déterminer les sentiments des orateurs ou des écrivains par rapport à un sujet. L'analyse des sentiments est utilisée pour aider à :

Le traitement du signal est une technologie habilitante qui englobe la théorie fondamentale, les applications, les algorithmes et les implémentations du traitement ou du transfert d'informations contenues dans de nombreux formats physiques, symboliques ou abstraits largement désignés comme des signaux . Il utilise des représentations, des formalismes et des techniques mathématiques, statistiques, informatiques, heuristiques et linguistiques pour la représentation, la modélisation, l'analyse, la synthèse, la découverte, la récupération, la détection, l'acquisition, l'extraction, l'apprentissage, la sécurité ou la criminalistique. Les exemples d'applications incluent la modélisation pour l'analyse de séries chronologiques ou la mise en œuvre de la fusion de données pour déterminer une lecture plus précise en combinant les données d'un ensemble de sources de données moins précises (c'est-à-dire extraire le signal du bruit).

L'analyse spatiale est le processus par lequel nous transformons les données brutes en informations utiles. C'est le processus d'examen des emplacements, des attributs et des relations des entités dans les données spatiales par superposition et d'autres techniques analytiques afin de répondre à une question ou d'acquérir des connaissances utiles. L'analyse spatiale extrait ou crée de nouvelles informations à partir de données spatiales.

En statistique, l'analyse exploratoire des données est une approche d'analyse des ensembles de données pour résumer leurs principales caractéristiques, souvent avec des méthodes visuelles. Un modèle statistique peut être utilisé ou non, mais l'EDA sert principalement à voir ce que les données peuvent nous dire au-delà de la tâche de modélisation formelle ou de test d'hypothèses. Des techniques statistiques sont également utilisées pour réduire la probabilité d'erreurs de type I (« faux positifs ») et d'erreurs de type II (« faux négatifs »). Un exemple d'application est le test A/B pour déterminer quels types de supports marketing augmenteront le plus les revenus.

Voir aussi : 40 faits ahurissants sur le Big Data

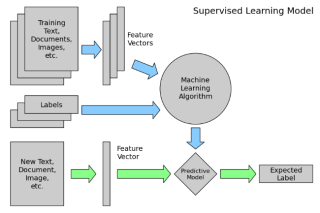

L'apprentissage supervisé est la tâche d'apprentissage automatique consistant à déduire une fonction à partir de données d'entraînement étiquetées. Les données d'apprentissage consistent en un ensemble d' exemples d'apprentissage . Dans l'apprentissage supervisé, chaque exemple est une paire constituée d'un objet d'entrée (généralement un vecteur) et d'une valeur de sortie souhaitée (également appelée signal de supervision ). Un algorithme d'apprentissage supervisé analyse les données d'apprentissage et produit une fonction inférée, qui peut être utilisée pour mapper de nouveaux exemples.

L'analyse des réseaux sociaux est une technique qui a d'abord été utilisée dans l'industrie des télécommunications, puis rapidement adoptée par les sociologues pour étudier les relations interpersonnelles. Il est maintenant appliqué pour analyser les relations entre les personnes dans de nombreux domaines et activités commerciales. Les nœuds représentent les individus au sein d'un réseau, tandis que les liens représentent les relations entre les individus.

Modélisation du comportement de systèmes complexes, souvent utilisés pour la prévision, la prévision et la planification de scénarios. Les simulations de Monte Carlo, par exemple, sont une classe d'algorithmes qui reposent sur un échantillonnage aléatoire répété, c'est-à-dire exécutant des milliers de simulations, chacune basée sur des hypothèses différentes. Le résultat est un histogramme qui donne une distribution de probabilité des résultats. Une application évalue la probabilité d'atteindre les objectifs financiers compte tenu des incertitudes quant au succès de diverses initiatives

L'analyse de séries chronologiques comprend des méthodes d'analyse de données de séries chronologiques afin d'extraire des statistiques significatives et d'autres caractéristiques des données. Les données de séries chronologiques surviennent souvent lors de la surveillance des processus industriels ou du suivi des mesures commerciales de l'entreprise. L'analyse des séries chronologiques tient compte du fait que les points de données pris au fil du temps peuvent avoir une structure interne (telle qu'une autocorrélation, une tendance ou une variation saisonnière) qui doit être prise en compte. Des exemples d'analyse de séries chronologiques incluent la valeur horaire d'un indice boursier ou le nombre de patients diagnostiqués avec une condition donnée chaque jour.

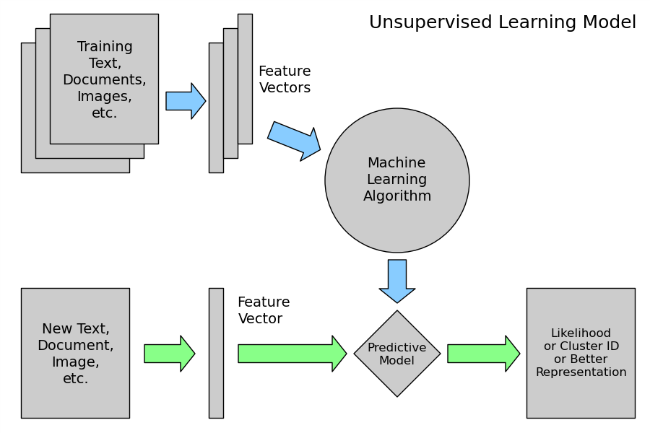

L'apprentissage non supervisé est la tâche d'apprentissage automatique consistant à déduire une fonction pour décrire une structure cachée à partir de données non étiquetées. Étant donné que les exemples donnés à l'apprenant ne sont pas étiquetés, il n'y a pas de signal d'erreur ou de récompense pour évaluer une solution potentielle - cela distingue l'apprentissage non supervisé de l'apprentissage supervisé et de l'apprentissage par renforcement.

Cependant, l'apprentissage non supervisé englobe également de nombreuses autres techniques qui cherchent à résumer et à expliquer les principales caractéristiques des données.

La visualisation des données est la préparation des données dans un format pictural ou graphique. Il permet aux décideurs de voir les analyses présentées visuellement, afin qu'ils puissent saisir des concepts difficiles ou identifier de nouveaux modèles. Avec la visualisation interactive, vous pouvez aller plus loin dans le concept en utilisant la technologie pour explorer des tableaux et des graphiques pour plus de détails, en modifiant de manière interactive les données que vous voyez et la façon dont elles sont traitées.

Conclusion

L'analyse des mégadonnées a été l'une des percées les plus importantes dans l'industrie des technologies de l'information. En fait, le Big Data a montré son importance et son besoin presque dans tous les secteurs, et dans tous les départements de ces industries. Il n'y a pas un seul aspect de la vie qui n'ait pas été affecté par le Big Data, pas même notre vie personnelle. Par conséquent, nous avons besoin de Big Data Analytics pour gérer efficacement ces énormes quantités de données.

Comme dit précédemment, cette liste n'est pas exhaustive. Les chercheurs expérimentent toujours de nouvelles façons d'analyser ces énormes quantités de données qui sont présentes sous une variété de formes dont la vitesse de génération augmente avec le temps pour dériver des valeurs pour nos utilisations spécifiques.

Découvrez comment générer une clé SSH pour accéder à votre serveur sans mot de passe. Suivez nos étapes faciles à comprendre pour créer et ajouter des clés SSH.

Découvrez comment créer un serveur de messagerie avec hMailServer sous Windows pour recevoir des e-mails facilement.

Les attaques de ransomware sont en augmentation, mais l'IA peut-elle aider à lutter contre le dernier virus informatique ? L'IA est-elle la réponse ? Lisez ici, sachez que l'IA est un boone ou un fléau

ReactOS, un système d'exploitation open source et gratuit est ici avec la dernière version. Cela peut-il suffire aux besoins des utilisateurs de Windows modernes et faire tomber Microsoft ? Découvrons-en plus sur cet ancien style, mais une expérience de système d'exploitation plus récente.

Whatsapp a finalement lancé l'application de bureau pour les utilisateurs Mac et Windows. Vous pouvez désormais accéder facilement à Whatsapp depuis Windows ou Mac. Disponible pour Windows 8+ et Mac OS 10.9+

Lisez ceci pour savoir comment l'intelligence artificielle devient populaire parmi les petites entreprises et comment elle augmente les probabilités de les faire grandir et de donner à leurs concurrents un avantage.

Récemment, Apple a publié macOS Catalina 10.15.4, une mise à jour supplémentaire pour résoudre les problèmes, mais il semble que la mise à jour cause davantage de problèmes, ce qui entraîne le bridage des machines mac. Lisez cet article pour en savoir plus

13 outils commerciaux d'extraction de données de Big Data

Notre ordinateur stocke toutes les données d'une manière organisée connue sous le nom de système de fichiers de journalisation. C'est une méthode efficace qui permet à l'ordinateur de rechercher et d'afficher des fichiers dès que vous appuyez sur la recherche.https://wethegeek.com/?p=94116&preview=true

Alors que la science évolue à un rythme rapide, prenant le pas sur une grande partie de nos efforts, les risques de nous soumettre à une Singularité inexplicable augmentent également. Lisez, ce que la singularité pourrait signifier pour nous.