Comment générer des clés SSH?

Découvrez comment générer une clé SSH pour accéder à votre serveur sans mot de passe. Suivez nos étapes faciles à comprendre pour créer et ajouter des clés SSH.

Le « Big Data » est l'application de techniques et de technologies spécialisées pour traiter de très grands ensembles de données. Ces ensembles de données sont souvent si volumineux et complexes qu'il devient difficile de les traiter à l'aide d'outils de gestion de bases de données disponibles.

La croissance radicale de la technologie de l'information a conduit à plusieurs conditions complémentaires dans l'industrie. L'un des résultats les plus persistants et sans doute les plus actuels est la présence du Big Data. Le terme Big Data est un slogan qui a été inventé pour décrire la présence d'énormes quantités de données. L'effet résultant d'une telle quantité de données est l'analyse de données.

L'analyse de données est le processus de structuration du Big Data. Au sein du Big Data, il existe différents modèles et corrélations qui permettent à l'analyse de données de mieux caractériser les données. Cela fait de l'analyse des données l'une des parties les plus importantes des technologies de l'information.

Par conséquent, je répertorie ici les 26 techniques d'analyse de données volumineuses. Cette liste n'est en aucun cas exhaustive.

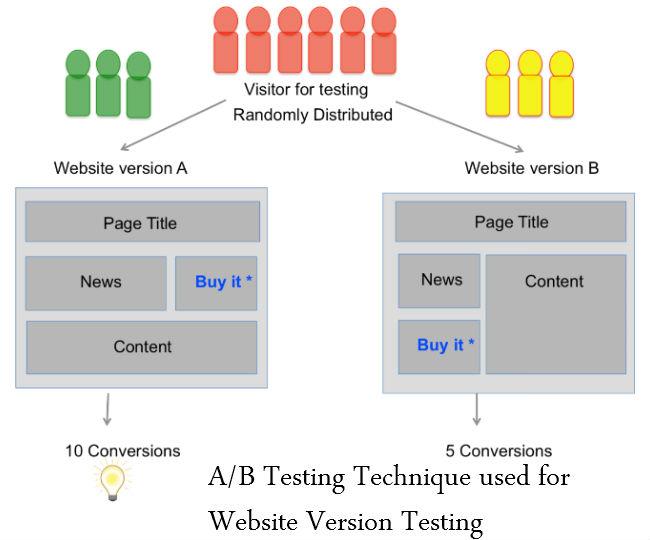

Tests A/B

L'A/B Testing est un outil d'évaluation permettant d'identifier quelle version d'une page Web ou d'une application aide une organisation ou un individu à atteindre un objectif commercial plus efficacement. Cette décision est prise en comparant quelle version de quelque chose fonctionne le mieux. Les tests A/B sont couramment utilisés dans le développement Web pour garantir que les modifications apportées à une page Web ou à un composant de page sont motivées par des données et non par une opinion personnelle.

Il est également appelé test de déversement ou test de seau.

Voir aussi : La zone grise du Big Data – À faire et à ne pas faire

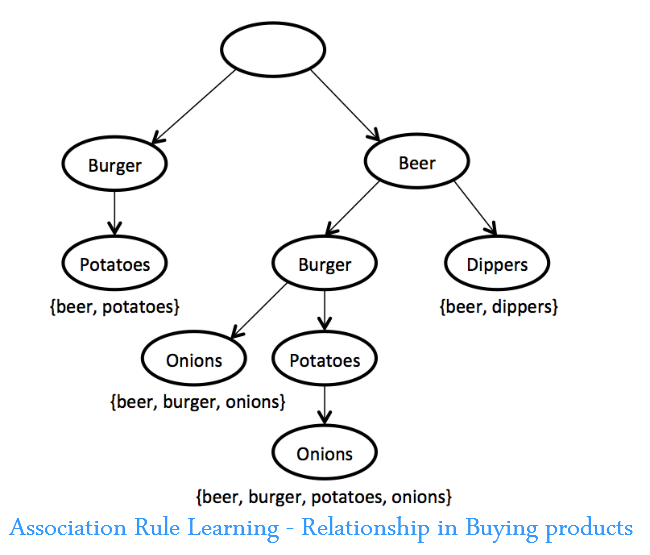

Apprentissage des règles d'association

Un ensemble de techniques pour découvrir des relations intéressantes, c'est-à-dire des « règles d'association », entre des variables dans de grandes bases de données. Ces techniques consistent en une variété d'algorithmes pour générer et tester des règles possibles.

Une application est l'analyse du panier de consommation, dans laquelle un détaillant peut déterminer quels produits sont fréquemment achetés ensemble et utiliser ces informations pour le marketing. (Un exemple couramment cité est la découverte que de nombreux acheteurs de supermarchés qui achètent des nachos achètent également de la bière.)

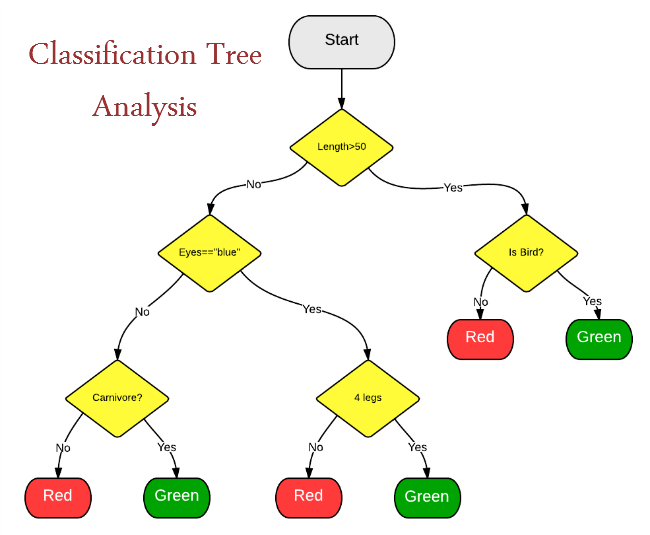

Analyse de l'arbre de classification

La classification statistique est une méthode d'identification des catégories auxquelles appartient une nouvelle observation. Cela nécessite un ensemble d'observations correctement identifiées – des données historiques en d'autres termes.

La classification statistique est utilisée pour :

L'analyse par grappes

Méthode statistique de classification d'objets qui divise un groupe diversifié en plus petits groupes d'objets similaires, dont les caractéristiques de similitude ne sont pas connues à l'avance. Un exemple d'analyse de cluster consiste à segmenter les consommateurs en groupes autosimilaires pour un marketing ciblé. Utilisé pour l'exploration de données.

Crowdsourcing

Dans le crowdsourcing, la nuance est qu'une tâche ou un travail est sous-traité mais pas à un professionnel ou à une organisation désigné mais au grand public sous la forme d'un appel ouvert. Le crowdsourcing est une technique qui peut être déployée pour collecter des données à partir de diverses sources telles que des messages texte, des mises à jour sur les réseaux sociaux, des blogs, etc. Il s'agit d'un type de collaboration de masse et d'une instance d'utilisation du Web.

Fusion de données et intégration de données

Un processus à plusieurs niveaux traitant de l'association, de la corrélation, de la combinaison de données et d'informations provenant de sources uniques et multiples pour obtenir une position affinée, identifier des estimations et des évaluations complètes et opportunes des situations, des menaces et de leur importance.

Les techniques de fusion de données combinent des données provenant de plusieurs capteurs et des informations connexes provenant de bases de données associées pour obtenir une précision améliorée et des inférences plus spécifiques que celles qui pourraient être obtenues par l'utilisation d'un seul capteur.

Voir aussi : Guide du débutant sur l'analyse des mégadonnées

Exploration de données

L'exploration de données consiste à trier les données pour identifier des modèles et établir des relations. L'exploration de données fait référence aux techniques d'extraction de données collectives qui sont effectuées sur un grand volume de données. Les paramètres d'exploration de données incluent l'association, l'analyse de séquence, la classification, le clustering et la prévision.

Les applications incluent l'exploration de données client pour déterminer les segments les plus susceptibles de répondre à une offre, l'exploration de données de ressources humaines pour identifier les caractéristiques des employés les plus performants ou l'analyse du panier de marché pour modéliser le comportement d'achat des clients.

Apprentissage d'ensemble

C'est un art de combiner divers ensembles d'algorithmes d'apprentissage pour improviser sur la stabilité et la puissance prédictive du modèle. Il s'agit d'un type d'apprentissage supervisé.

Algorithmes génétiques

Techniques d'optimisation qui utilisent des processus tels que la combinaison génétique, la mutation et la sélection naturelle dans une conception basée sur les concepts d'évolution naturelle. Les algorithmes génétiques sont des techniques utilisées pour identifier les vidéos, émissions de télévision et autres formes de médias les plus visionnées. Il existe un modèle évolutif qui peut être fait par l'utilisation d'algorithmes génétiques. L'analyse des vidéos et des médias peut être effectuée à l'aide d'algorithmes génétiques.

Apprentissage automatique

L'apprentissage automatique est une autre technique qui peut être utilisée pour classer et déterminer le résultat probable d'un ensemble spécifique de données. L'apprentissage automatique définit un logiciel capable de déterminer les résultats possibles d'un certain ensemble d'événements. Il est donc utilisé en analyse prédictive. Un exemple d'analyse prédictive est la probabilité de gagner des affaires juridiques ou le succès de certaines productions.

Traitement du langage naturel

Un ensemble de techniques d'une sous-spécialité de l'informatique (dans un domaine historiquement appelé «intelligence artificielle») et de la linguistique qui utilise des algorithmes informatiques pour analyser le langage humain (naturel). De nombreuses techniques de PNL sont des types d'apprentissage automatique. Une application de la PNL utilise l'analyse des sentiments sur les réseaux sociaux pour déterminer comment les clients potentiels réagissent à une campagne de branding.

Les réseaux de neurones

Modèles prédictifs non linéaires qui apprennent par la formation et ressemblent à des réseaux de neurones biologiques dans leur structure. Ils peuvent être utilisés pour la reconnaissance et l'optimisation des formes. Certaines applications de réseaux neuronaux impliquent un apprentissage supervisé et d'autres impliquent un apprentissage non supervisé. Des exemples d'applications incluent l'identification de clients de grande valeur qui risquent de quitter une entreprise particulière et l'identification de réclamations d'assurance frauduleuses.

Lire aussi : 40 faits ahurissants sur le Big Data

Optimisation

Un portefeuille de techniques numériques utilisées pour reconcevoir des systèmes et des processus complexes afin d'améliorer leurs performances selon une ou plusieurs mesures objectives (par exemple, le coût, la vitesse ou la fiabilité). Des exemples d'applications incluent l'amélioration des processus opérationnels tels que la planification, l'acheminement et l'aménagement des étages, et la prise de décisions stratégiques telles que la stratégie de gamme de produits, l'analyse des investissements liés et la stratégie de portefeuille de R&D. Les algorithmes génétiques sont un exemple de technique d'optimisation.

Dans mon prochain blog, je décrirais les 13 techniques d'analyse de Big Data restantes.

Lire : Partie suivante d'un aperçu de 26 techniques d'analyse de Big Data

Découvrez comment générer une clé SSH pour accéder à votre serveur sans mot de passe. Suivez nos étapes faciles à comprendre pour créer et ajouter des clés SSH.

Découvrez comment créer un serveur de messagerie avec hMailServer sous Windows pour recevoir des e-mails facilement.

Les attaques de ransomware sont en augmentation, mais l'IA peut-elle aider à lutter contre le dernier virus informatique ? L'IA est-elle la réponse ? Lisez ici, sachez que l'IA est un boone ou un fléau

ReactOS, un système d'exploitation open source et gratuit est ici avec la dernière version. Cela peut-il suffire aux besoins des utilisateurs de Windows modernes et faire tomber Microsoft ? Découvrons-en plus sur cet ancien style, mais une expérience de système d'exploitation plus récente.

Whatsapp a finalement lancé l'application de bureau pour les utilisateurs Mac et Windows. Vous pouvez désormais accéder facilement à Whatsapp depuis Windows ou Mac. Disponible pour Windows 8+ et Mac OS 10.9+

Lisez ceci pour savoir comment l'intelligence artificielle devient populaire parmi les petites entreprises et comment elle augmente les probabilités de les faire grandir et de donner à leurs concurrents un avantage.

Récemment, Apple a publié macOS Catalina 10.15.4, une mise à jour supplémentaire pour résoudre les problèmes, mais il semble que la mise à jour cause davantage de problèmes, ce qui entraîne le bridage des machines mac. Lisez cet article pour en savoir plus

13 outils commerciaux d'extraction de données de Big Data

Notre ordinateur stocke toutes les données d'une manière organisée connue sous le nom de système de fichiers de journalisation. C'est une méthode efficace qui permet à l'ordinateur de rechercher et d'afficher des fichiers dès que vous appuyez sur la recherche.https://wethegeek.com/?p=94116&preview=true

Alors que la science évolue à un rythme rapide, prenant le pas sur une grande partie de nos efforts, les risques de nous soumettre à une Singularité inexplicable augmentent également. Lisez, ce que la singularité pourrait signifier pour nous.