Cara Memasang Panel Kontrol Hosting Mudah di Ubuntu 16.04

Pelajari langkah-langkah untuk memasang Panel Kontrol Hosting Mudah (EHCP) di Ubuntu 16.04 dengan panduan ini.

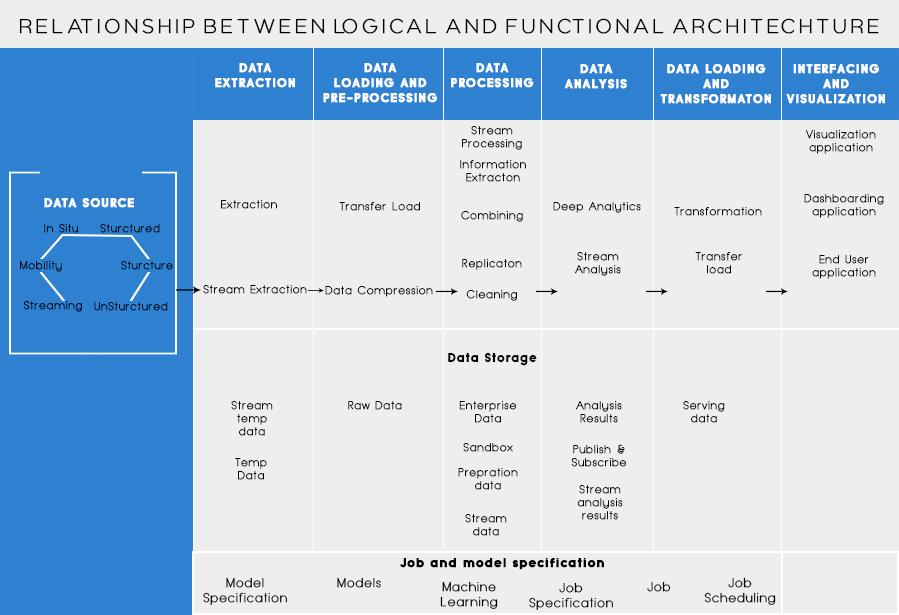

Dalam posting terakhir saya , kami membahas tentang menganalisis masalah bisnis dan langkah-langkah dasar untuk merancang Arsitektur Big Data. Hari ini, saya akan berbicara tentang lapisan yang berbeda dalam Arsitektur Big Data dan fungsinya.

Lapisan Logis Arsitektur Referensi Big Data

Di balik arsitektur big data, ide intinya adalah mendokumentasikan fondasi arsitektur, infrastruktur, dan aplikasi yang tepat. Akibatnya, ini memungkinkan bisnis untuk menggunakan data besar secara lebih efektif setiap hari.

Itu dibuat oleh perancang/arsitek data besar sebelum mengimplementasikan solusi secara fisik. Membuat arsitektur big data umumnya membutuhkan pemahaman bisnis/organisasi dan kebutuhan big datanya. Biasanya, arsitektur data besar menguraikan komponen perangkat keras dan perangkat lunak yang diperlukan untuk memenuhi solusi data besar. Dokumen arsitektur data besar juga dapat menjelaskan protokol untuk berbagi data, integrasi aplikasi, dan keamanan informasi.

Info Lebih Lanjut: Panduan Pemula untuk Big Data Analytics

Ini juga memerlukan interkoneksi dan pengorganisasian sumber daya yang ada untuk melayani kebutuhan big data.

Lapisan logis dari arsitektur referensi adalah sebagai berikut:

Pembuatan profil sumber adalah salah satu langkah terpenting dalam menentukan arsitektur atau data besar. Ini melibatkan mengidentifikasi sistem sumber yang berbeda dan mengkategorikannya, berdasarkan sifat dan jenisnya.

Poin yang harus dipertimbangkan saat membuat profil sumber data:

Pengambilan data adalah semua tentang ekstraksi data dari sumber yang disebutkan di atas. Data ini disimpan dalam penyimpanan dan kemudian setelah diubah untuk diproses lebih lanjut di atasnya.

Poin yang harus dipertimbangkan:

Seseorang harus dapat menyimpan sejumlah besar data dari jenis apa pun dan harus dapat menskalakan berdasarkan kebutuhan. Kita juga harus mempertimbangkan jumlah IOPS (Operasi keluaran input per detik) yang dapat diberikannya. Sistem file terdistribusi Hadoop adalah kerangka penyimpanan yang paling umum digunakan di dunia Big Data, yang lainnya adalah penyimpanan data NoSQL – MongoDB, HBase, Cassandra, dll.

Hal-hal yang perlu dipertimbangkan saat merencanakan metodologi penyimpanan:

Tidak hanya jumlah data yang disimpan tetapi pemrosesannya juga meningkat berlipat ganda.

Data yang sering diakses sebelumnya disimpan dalam RAM Dinamis. Tapi sekarang, itu disimpan di beberapa disk di sejumlah mesin yang terhubung melalui jaringan karena volume yang tipis. Oleh karena itu, alih-alih mengumpulkan potongan data untuk diproses, modul pemrosesan dibawa ke data besar. Dengan demikian, secara signifikan mengurangi jaringan I/O. Metodologi Pemrosesan didorong oleh kebutuhan bisnis. Itu dapat dikategorikan ke dalam Batch, real-time atau Hybrid berdasarkan SLA.

Lapisan ini mengkonsumsi output yang disediakan oleh lapisan pemrosesan. Pengguna yang berbeda seperti administrator, pengguna Bisnis, vendor, mitra, dll. Dapat menggunakan data dalam format yang berbeda. Output analisis dapat dikonsumsi oleh mesin rekomendasi atau proses bisnis dapat dipicu berdasarkan analisis.

Berbagai bentuk konsumsi data adalah:

Baca Juga: Big Data: Mimpi Buruk di Masa Depan?

Lapisan Fungsional Arsitektur Big Data:

Mungkin ada satu cara lagi untuk mendefinisikan arsitektur yaitu melalui pembagian fungsionalitas. Tetapi kategori fungsionalitas dapat dikelompokkan bersama ke dalam lapisan logis dari arsitektur referensi, jadi, Arsitektur yang disukai adalah yang dilakukan dengan menggunakan Lapisan Logis.

Layering berdasarkan Fungsionalitas adalah sebagai berikut:

Menganalisis semua sumber dari mana organisasi menerima data dan yang dapat membantu organisasi dalam membuat keputusan masa depan harus dicantumkan dalam kategori ini. Sumber data yang tercantum di sini terlepas dari fakta apakah data terstruktur, tidak terstruktur, atau semi terstruktur.

Sebelum Anda dapat menyimpan, menganalisis, atau memvisualisasikan data Anda, Anda harus memilikinya. Ekstraksi data adalah tentang mengambil sesuatu yang tidak terstruktur, seperti halaman web, dan mengubahnya menjadi tabel terstruktur. Setelah Anda membuatnya terstruktur, Anda dapat memanipulasinya dengan berbagai cara, menggunakan alat yang dijelaskan di bawah ini, untuk menemukan wawasan.

Kebutuhan dasar saat bekerja dengan data besar adalah memikirkan bagaimana menyimpan data itu. Bagian dari bagaimana Big Data mendapat perbedaan sebagai "BIG" adalah bahwa itu menjadi terlalu banyak untuk ditangani oleh sistem tradisional. Penyedia penyimpanan data yang baik harus menawarkan infrastruktur untuk menjalankan semua alat analitik Anda yang lain serta tempat untuk menyimpan dan menanyakan data Anda.

Langkah yang diperlukan sebelum kita benar-benar mulai menambang data untuk wawasan. Itu selalu merupakan praktik yang baik untuk membuat kumpulan data yang bersih dan terstruktur dengan baik. Kumpulan data bisa datang dalam berbagai bentuk dan ukuran, terutama jika berasal dari web. Pilih alat sesuai kebutuhan data Anda.

Data mining adalah proses menemukan wawasan dalam database. Tujuan dari data mining adalah untuk membuat keputusan dan prediksi pada data yang Anda miliki. Pilih perangkat lunak yang memberi Anda prediksi terbaik untuk semua jenis data dan memungkinkan Anda membuat algoritme sendiri untuk menambang data.

Sementara penambangan data adalah tentang memilah-milah data Anda untuk mencari pola yang sebelumnya tidak dikenali, analisis data adalah tentang memecah data itu dan menilai dampak dari pola tersebut dari waktu ke waktu. Analytics adalah tentang mengajukan pertanyaan spesifik dan menemukan jawaban dalam data. Anda bahkan dapat mengajukan pertanyaan tentang apa yang akan terjadi di masa depan!

Visualisasi adalah cara yang cerdas dan mudah untuk menyampaikan wawasan data yang kompleks. Dan bagian terbaiknya adalah kebanyakan dari mereka tidak memerlukan pengkodean. Perusahaan visualisasi data akan membuat data Anda menjadi hidup. Bagian dari tantangan bagi ilmuwan data mana pun adalah menyampaikan wawasan dari data tersebut ke seluruh perusahaan Anda. Alat dapat membantu Anda membuat bagan, peta, dan grafik lainnya dari wawasan data Anda.

Platform integrasi data adalah perekat antara setiap program. Mereka menghubungkan kesimpulan yang berbeda dari alat dengan Perangkat Lunak lain. Anda dapat membagikan hasil alat visualisasi Anda langsung di Facebook melalui alat ini.

Akan ada saat-saat dalam karir data Anda ketika alat tidak akan memotongnya. Sementara alat saat ini menjadi lebih kuat dan lebih mudah digunakan, terkadang lebih baik membuat kode sendiri. Ada berbagai bahasa yang membantu Anda dalam berbagai aspek seperti komputasi statistik dan grafik. Bahasa-bahasa ini dapat berfungsi sebagai suplemen untuk penambangan data dan Perangkat Lunak statistik.

Hal utama yang perlu diingat dalam mendesain Arsitektur Big Data adalah:

Saya tahu Anda akan memikirkan alat yang berbeda untuk digunakan untuk membuat Solusi Data Besar bukti lengkap. Nah, dalam posting saya yang akan datang di Big Data, saya akan membahas beberapa alat terbaik untuk mencapai berbagai tugas dalam arsitektur data besar .

Pelajari langkah-langkah untuk memasang Panel Kontrol Hosting Mudah (EHCP) di Ubuntu 16.04 dengan panduan ini.

Wawasan tentang 26 Teknik Analisis Data Besar: Bagian 1

Banyak dari Anda tahu Switch keluar pada Maret 2017 dan fitur-fitur barunya. Bagi yang belum tahu, kami sudah menyiapkan daftar fitur yang membuat 'Switch' menjadi 'gadget yang wajib dimiliki'.

Apakah Anda menunggu raksasa teknologi untuk memenuhi janji mereka? periksa apa yang belum terkirim.

Baca blog untuk mengetahui berbagai lapisan dalam Arsitektur Big Data dan fungsinya dengan cara yang paling sederhana.

Baca ini untuk mengetahui bagaimana Kecerdasan Buatan menjadi populer di antara perusahaan skala kecil dan bagaimana hal itu meningkatkan kemungkinan untuk membuat mereka tumbuh dan memberi keunggulan pada pesaing mereka.

CAPTCHA telah berkembang cukup sulit bagi pengguna untuk dipecahkan dalam beberapa tahun terakhir. Apakah itu akan tetap efektif dalam deteksi spam dan bot di masa mendatang?

Saat Sains Berkembang dengan kecepatan tinggi, mengambil alih banyak upaya kita, risiko menundukkan diri kita pada Singularitas yang tidak dapat dijelaskan juga meningkat. Baca, apa arti singularitas bagi kita.

Apa itu telemedicine, perawatan kesehatan jarak jauh dan dampaknya terhadap generasi mendatang? Apakah itu tempat yang bagus atau tidak dalam situasi pandemi? Baca blog untuk menemukan tampilan!

Anda mungkin pernah mendengar bahwa peretas menghasilkan banyak uang, tetapi pernahkah Anda bertanya-tanya bagaimana cara mereka mendapatkan uang sebanyak itu? mari berdiskusi.