O perspectivă asupra a 26 de tehnici de analiză a datelor mari: partea 1

O perspectivă asupra a 26 de tehnici de analiză a datelor mari: partea 1

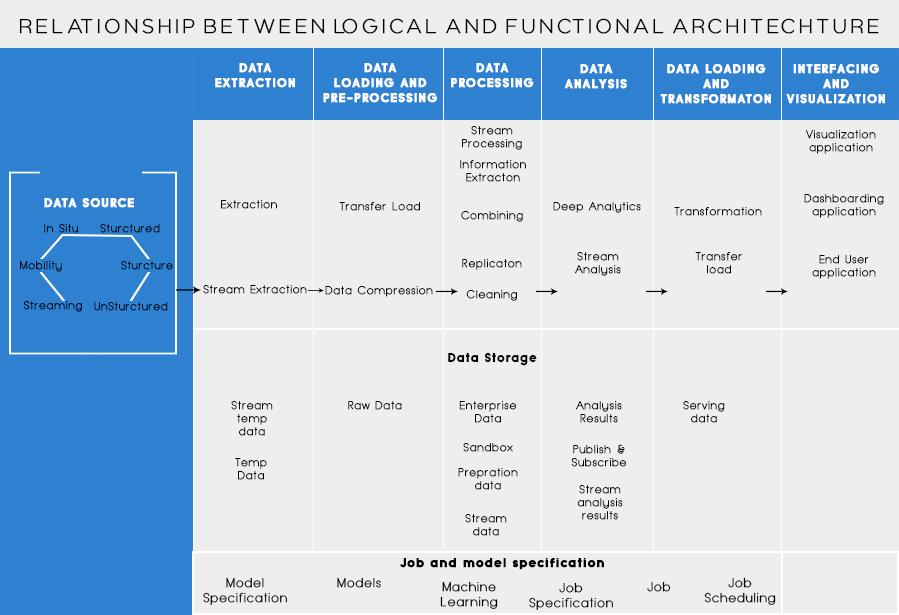

În ultima mea postare , am discutat despre analiza problemei afacerii și pașii de bază pentru proiectarea arhitecturii Big Data. Astăzi, voi vorbi despre diferitele straturi din Arhitectura Big Data și funcționalitățile acestora.

Straturi logice ale arhitecturii de referință a datelor mari

În spatele arhitecturii de date mari, ideea de bază este de a documenta o bază corectă a arhitecturii, infrastructurii și aplicațiilor. În consecință, acest lucru permite companiilor să utilizeze datele mari în mod mai eficient în fiecare zi.

Este creat de designeri/arhitecți de date mari înainte de a implementa fizic o soluție. Crearea arhitecturii de date mari necesită în general înțelegerea afacerii/organizației și a nevoilor sale de date mari. De obicei, arhitecturile de date mari prezintă componentele hardware și software care sunt necesare pentru a îndeplini soluția de date mari. Documentele de arhitectură de date mari pot descrie, de asemenea, protocoale pentru partajarea datelor, integrări de aplicații și securitatea informațiilor.

Mai multe informații: Ghid pentru începători pentru Big Data Analytics

De asemenea, presupune interconectarea și organizarea resurselor existente pentru a satisface nevoile de date mari.

Straturile logice ale arhitecturii de referință sunt următoarele:

Profilarea sursă este unul dintre cei mai importanți pași în deciderea arhitecturii sau a datelor mari. Aceasta implică identificarea diferitelor sisteme sursă și clasificarea lor, în funcție de natura și tipul lor.

Puncte care trebuie luate în considerare la crearea profilului surselor de date:

Ingestia de date se referă la extragerea datelor din sursele menționate mai sus. Aceste date sunt stocate în stocare și apoi sunt transformate pentru procesare ulterioară pe ea.

Puncte de luat în considerare:

Unul ar trebui să poată stoca cantități mari de date de orice tip și ar trebui să poată fi scalat în funcție de nevoi. De asemenea, ar trebui să luăm în considerare numărul de IOPS (operații de intrare ieșire pe secundă) pe care le poate furniza. Sistemul de fișiere distribuit Hadoop este cel mai des folosit cadru de stocare în lumea Big Data, altele sunt magazinele de date NoSQL – MongoDB, HBase, Cassandra etc.

Lucruri de luat în considerare la planificarea metodologiei de stocare:

Nu numai cantitatea de date stocate, ci și procesarea a crescut de mai multe ori.

Datele accesate frecvent erau stocate anterior în RAM-uri dinamice. Dar acum, este stocat pe mai multe discuri pe un număr de mașini conectate prin rețea datorită volumului mare. Prin urmare, în loc să strângă bucăți de date pentru procesare, modulele de procesare sunt duse la big data. Astfel, reducând semnificativ I/O rețea. Metodologia de procesare este condusă de cerințele afacerii. Poate fi clasificat în lot, în timp real sau hibrid pe baza SLA.

Acest strat consumă producția furnizată de stratul de procesare. Diferiți utilizatori, cum ar fi administrator, utilizatori de afaceri, furnizor, parteneri etc. pot consuma date în format diferit. Rezultatele analizei pot fi consumate de motorul de recomandare sau procesele de afaceri pot fi declanșate pe baza analizei.

Diferite forme de consum de date sunt:

Citește și: Big Data: un coșmar viitor?

Straturi funcționale ale arhitecturii Big Data:

Ar putea exista o altă modalitate de definire a arhitecturii, adică prin divizia de funcționalități. Dar categoriile de funcționalități ar putea fi grupate împreună în stratul logic al arhitecturii de referință, deci, Arhitectura preferată este cea realizată folosind Straturi logice.

Stratificarea bazată pe funcționalități este următoarea:

Analizarea tuturor surselor de la care o organizație primește date și care ar putea ajuta organizația în luarea deciziilor viitoare ar trebui enumerată în această categorie. Sursele de date enumerate aici sunt indiferent dacă datele sunt structurate, nestructurate sau semistructurate.

Înainte de a vă putea stoca, analiza sau vizualiza datele, trebuie să aveți câteva. Extragerea datelor înseamnă a lua ceva care este nestructurat, cum ar fi o pagină web, și a-l transforma într-un tabel structurat. Odată ce l-ați structurat, îl puteți manipula în tot felul de moduri, folosind instrumentele descrise mai jos, pentru a găsi informații.

Necesitatea de bază în timp ce lucrați cu date mari este să vă gândiți cum să stocați acele date. O parte din modul în care Big Data a obținut distincția ca „BIG” este faptul că a devenit prea mult pentru sistemele tradiționale. Un furnizor bun de stocare a datelor ar trebui să vă ofere o infrastructură pe care să rulați toate celelalte instrumente de analiză, precum și un loc pentru stocarea și interogarea datelor.

Un pas pre-necesar înainte de a începe efectiv să extragem datele pentru informații. Este întotdeauna o practică bună să creați un set de date curat și bine structurat. Seturile de date pot avea toate formele și dimensiunile, mai ales atunci când provin de pe web. Alegeți un instrument conform cerințelor dvs. de date.

Miningul de date este procesul de descoperire a informațiilor într-o bază de date. Scopul minării de date este de a lua decizii și predicții asupra datelor pe care le aveți la îndemână. Alegeți un software care vă oferă cele mai bune predicții pentru toate tipurile de date și vă permite să vă creați proprii algoritmi pentru extragerea datelor.

În timp ce data mining-ul se referă la analizarea datelor dvs. în căutarea unor modele nerecunoscute anterior, analiza datelor se referă la defalcarea acestor date și la evaluarea impactului acestor modele peste timp. Analytics înseamnă a pune întrebări specifice și a găsi răspunsurile în date. Puteți chiar să puneți întrebări despre ce se va întâmpla în viitor!

Vizualizările sunt o modalitate luminoasă și ușoară de a transmite informații complexe despre date. Și cea mai bună parte este că majoritatea dintre ele nu necesită codare. Companiile de vizualizare a datelor vor face ca datele dvs. să prindă viață. O parte a provocării pentru orice cercetător de date este transmiterea informațiilor din acele date către restul companiei dvs. Instrumentele vă pot ajuta să creați diagrame, hărți și alte astfel de elemente grafice din informațiile dvs. de date.

Platformele de integrare a datelor sunt lipiciul dintre fiecare program. Acestea conectează diferitele inferențe ale instrumentelor cu alte programe software. Puteți partaja rezultatele instrumentelor dvs. de vizualizare direct pe Facebook prin intermediul acestor instrumente.

Vor exista momente în cariera dvs. de date când un instrument pur și simplu nu o va tăia. În timp ce instrumentele de astăzi devin din ce în ce mai puternice și mai ușor de utilizat, uneori este mai bine să le codificați singur. Există diferite limbi care vă ajută în diferite aspecte, cum ar fi calculul statistic și grafica. Aceste limbi ar putea funcționa ca un supliment pentru software-urile de extragere a datelor și statistice.

Lucrul cheie de reținut în proiectarea arhitecturii Big Data sunt:

Știu că te-ai gândi la diferite instrumente pe care să le folosești pentru a realiza o soluție completă pentru Big Data. Ei bine, în postările mele viitoare despre Big Data, aș acoperi unele dintre cele mai bune instrumente pentru a realiza diferite sarcini în arhitectura Big Data .

O perspectivă asupra a 26 de tehnici de analiză a datelor mari: partea 1

Mulți dintre voi cunoașteți Switch care va fi lansat în martie 2017 și noile sale funcții. Pentru cei care nu știu, am pregătit o listă de funcții care fac din „Switch” un „gadget obligatoriu”.

Aștepți ca giganții tehnologiei să-și îndeplinească promisiunile? vezi ce a ramas nelivrat.

Citiți blogul pentru a cunoaște diferitele straturi din Arhitectura Big Data și funcționalitățile acestora în cel mai simplu mod.

Citiți asta pentru a afla cum devine populară inteligența artificială în rândul companiilor la scară mică și cum crește probabilitățile de a le face să crească și de a le oferi concurenților avantaje.

CAPTCHA a devenit destul de dificil de rezolvat pentru utilizatori în ultimii ani. Va fi capabil să rămână eficient în detectarea spam-ului și a botului în viitor?

Pe măsură ce Știința Evoluează într-un ritm rapid, preluând multe dintre eforturile noastre, crește și riscurile de a ne supune unei Singularități inexplicabile. Citiți, ce ar putea însemna singularitatea pentru noi.

Ce este telemedicina, îngrijirea medicală la distanță și impactul acesteia asupra generației viitoare? Este un loc bun sau nu în situația de pandemie? Citiți blogul pentru a găsi o vedere!

Poate ați auzit că hackerii câștigă mulți bani, dar v-ați întrebat vreodată cum câștigă acești bani? sa discutam.

Recent, Apple a lansat macOS Catalina 10.15.4 o actualizare suplimentară pentru a remedia problemele, dar se pare că actualizarea provoacă mai multe probleme care duc la blocarea mașinilor Mac. Citiți acest articol pentru a afla mai multe