Fino ad ora, nei miei blog sui Big Data , ti ho fatto conoscere diversi aspetti dei Big Data, da cosa significano effettivamente a fatti e cose da fare e da non fare. Nel blog precedente abbiamo visto alcune Tecniche di Big Data Analytics. Prendendo ulteriormente l'elenco in questo blog.

- Riconoscimento del modello

Il riconoscimento di modelli è una branca dell'apprendimento automatico che si concentra sul riconoscimento di modelli e regolarità nei dati, sebbene in alcuni casi sia considerato quasi sinonimo di apprendimento automatico. I sistemi di riconoscimento dei modelli sono in molti casi addestrati da dati di "addestramento" etichettati (apprendimento supervisionato), ma quando non sono disponibili dati etichettati, è possibile utilizzare altri algoritmi per scoprire modelli precedentemente sconosciuti (apprendimento non supervisionato).

- Modellazione predittiva

L'analisi predittiva comprende una varietà di tecniche che prevedono i risultati futuri sulla base di dati storici e attuali. In pratica, l'analisi predittiva può essere applicata a quasi tutte le discipline: dalla previsione del guasto dei motori a reazione sulla base del flusso di dati di diverse migliaia di sensori, alla previsione delle prossime mosse dei clienti in base a ciò che acquistano, quando acquistano e persino a cosa dicono sui social. Le tecniche di analisi predittiva si basano principalmente su metodi statistici.

Vedi anche: Guida per principianti all'analisi dei Big Data

- Analisi di regressione

Questa è una tecnica che prende l'uso di variabili indipendenti e il modo in cui influenzano le variabili dipendenti. Questa può essere una tecnica molto utile per determinare l'analisi dei social media come la probabilità di trovare l'amore su una piattaforma Internet.

- Analisi del sentimento

Sentiment Analysis aiuta i ricercatori a determinare i sentimenti di oratori o scrittori rispetto a un argomento. L'analisi del sentiment viene utilizzata per aiutare:

- Migliora il servizio in una catena di hotel analizzando i commenti degli ospiti.

- Personalizza incentivi e servizi per rispondere a ciò che i clienti chiedono veramente.

- Determina cosa pensano veramente i consumatori in base alle opinioni dei social media.

- Elaborazione del segnale

L'elaborazione del segnale è una tecnologia abilitante che comprende la teoria fondamentale, le applicazioni, gli algoritmi e le implementazioni dell'elaborazione o del trasferimento delle informazioni contenute in molti formati fisici, simbolici o astratti, generalmente designati come segnali . Utilizza rappresentazioni matematiche, statistiche, computazionali, euristiche e linguistiche, formalismi e tecniche di rappresentazione, modellazione, analisi, sintesi, scoperta, recupero, rilevamento, acquisizione, estrazione, apprendimento, sicurezza o medicina legale. Le applicazioni di esempio includono la modellazione per l'analisi delle serie temporali o l'implementazione della fusione dei dati per determinare una lettura più precisa combinando i dati da un insieme di fonti di dati meno precise (cioè, estraendo il segnale dal rumore).

- Analisi spaziale

L'analisi spaziale è il processo attraverso il quale trasformiamo i dati grezzi in informazioni utili. È il processo di esame delle posizioni, degli attributi e delle relazioni delle caratteristiche nei dati spaziali attraverso la sovrapposizione e altre tecniche analitiche al fine di affrontare una domanda o acquisire conoscenze utili. L'analisi spaziale estrae o crea nuove informazioni dai dati spaziali.

- Statistiche

In statistica, l'analisi esplorativa dei dati è un approccio all'analisi dei set di dati per riassumerne le caratteristiche principali, spesso con metodi visivi. Un modello statistico può essere utilizzato o meno, ma principalmente l'EDA serve a vedere cosa possono dirci i dati al di là della modellazione formale o dell'attività di verifica delle ipotesi. Vengono anche utilizzate tecniche statistiche per ridurre la probabilità di errori di tipo I ("falsi positivi") e di tipo II ("falsi negativi"). Un esempio di un'applicazione è il test A/B per determinare quali tipi di materiale di marketing aumenteranno maggiormente le entrate.

Vedi anche: 40 fatti sbalorditivi sui big data

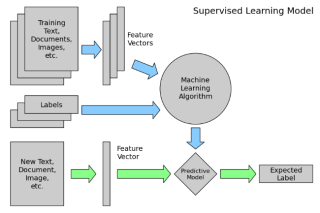

- Apprendimento supervisionato

L'apprendimento supervisionato è l'attività di apprendimento automatico che consiste nell'inferire una funzione dai dati di addestramento etichettati. I dati di addestramento sono costituiti da una serie di esempi di addestramento . Nell'apprendimento supervisionato, ogni esempio è una coppia costituita da un oggetto di ingresso (tipicamente un vettore) e un valore di uscita desiderato (chiamato anche segnale di supervisione ). Un algoritmo di apprendimento supervisionato analizza i dati di addestramento e produce una funzione dedotta, che può essere utilizzata per mappare nuovi esempi.

- Analisi dei social network

L'analisi dei social network è una tecnica che è stata utilizzata per la prima volta nel settore delle telecomunicazioni, e poi rapidamente adottata dai sociologi per studiare le relazioni interpersonali. Viene ora applicato per analizzare le relazioni tra le persone in molti campi e attività commerciali. I nodi rappresentano gli individui all'interno di una rete, mentre i legami rappresentano le relazioni tra gli individui.

- Simulazione

Modellazione del comportamento di sistemi complessi, spesso utilizzati per previsioni, previsioni e pianificazione di scenari. Le simulazioni Monte Carlo, ad esempio, sono una classe di algoritmi che si basano su un campionamento casuale ripetuto, ovvero eseguono migliaia di simulazioni, ciascuna basata su ipotesi diverse. Il risultato è un istogramma che fornisce una distribuzione di probabilità dei risultati. Un'applicazione sta valutando la probabilità di raggiungere gli obiettivi finanziari date le incertezze sul successo di varie iniziative

- Analisi delle serie temporali

L'analisi delle serie temporali comprende metodi per analizzare i dati delle serie temporali al fine di estrarre statistiche significative e altre caratteristiche dei dati. I dati delle serie temporali si verificano spesso durante il monitoraggio dei processi industriali o il monitoraggio delle metriche aziendali. L'analisi delle serie temporali tiene conto del fatto che i punti dati presi nel tempo possono avere una struttura interna (come l'autocorrelazione, la tendenza o la variazione stagionale) di cui tenere conto. Esempi di analisi di serie temporali includono il valore orario di un indice di borsa o il numero di pazienti a cui è stata diagnosticata una determinata condizione ogni giorno.

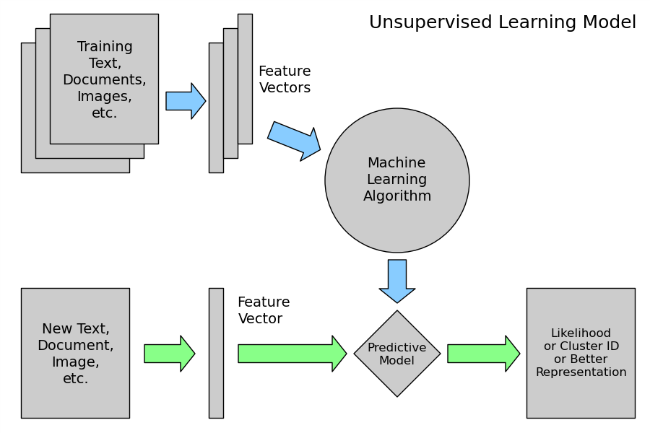

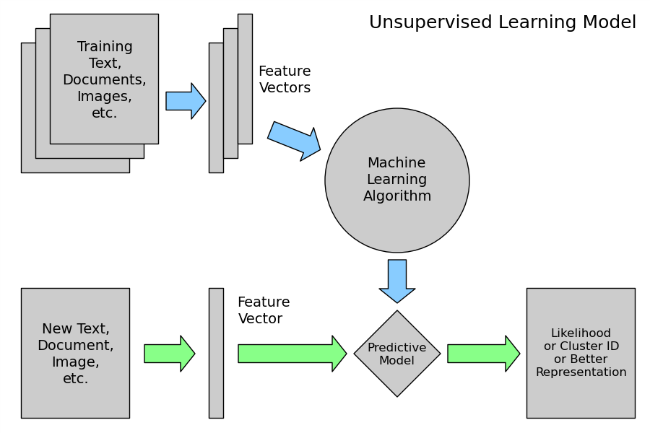

- Apprendimento senza supervisione

L'apprendimento non supervisionato è il compito di apprendimento automatico di dedurre una funzione per descrivere la struttura nascosta da dati non etichettati. Poiché gli esempi forniti allo studente non sono etichettati, non vi è alcun segnale di errore o ricompensa per valutare una potenziale soluzione: ciò distingue l'apprendimento non supervisionato dall'apprendimento supervisionato e dall'apprendimento per rinforzo.

Tuttavia, l'apprendimento non supervisionato comprende anche molte altre tecniche che cercano di riassumere e spiegare le caratteristiche chiave dei dati.

- Visualizzazione

La visualizzazione dei dati è la preparazione dei dati in un formato pittorico o grafico. Consente ai decisori di vedere l'analisi presentata visivamente, in modo che possano cogliere concetti difficili o identificare nuovi modelli. Con la visualizzazione interattiva, puoi portare il concetto un ulteriore passo avanti utilizzando la tecnologia per eseguire il drill-down in grafici e grafici per maggiori dettagli, modificando in modo interattivo quali dati vedi e come vengono elaborati.

Conclusione

L'analisi dei big data è stata una delle scoperte più importanti nel settore delle tecnologie dell'informazione. In effetti, i Big Data hanno mostrato la loro importanza e necessità quasi in tutti i settori, e in tutti i reparti di quelle industrie. Non c'è un singolo aspetto della vita che non sia stato influenzato dai Big Data, nemmeno le nostre vite personali. Quindi abbiamo bisogno di Big Data Analytics per gestire in modo efficiente questa enorme quantità di dati.

Come detto prima, questo elenco non è esaustivo. I ricercatori stanno ancora sperimentando nuovi modi di analizzare questa enorme quantità di dati che è presente in una varietà di forme la cui velocità di generazione aumenta con il tempo per ricavare valori per i nostri usi specifici.