' Big Data ' è l'applicazione di tecniche e tecnologie specializzate per elaborare insiemi di dati molto grandi. Questi set di dati sono spesso così grandi e complessi che diventa difficile elaborarli utilizzando gli strumenti di gestione del database disponibili.

La crescita radicale dell'Information Technology ha portato a diverse condizioni complementari nel settore. Uno dei risultati più persistenti e probabilmente più presenti è la presenza dei Big Data. Il termine Big Data è uno slogan coniato per descrivere la presenza di enormi quantità di dati. L'effetto risultante di avere una tale quantità di dati è Data Analytics.

Data Analytics è il processo di strutturazione dei Big Data. All'interno dei Big Data, esistono diversi modelli e correlazioni che consentono all'analisi dei dati di effettuare una migliore caratterizzazione calcolata dei dati. Ciò rende l'analisi dei dati una delle parti più importanti della tecnologia dell'informazione.

Quindi, qui sto elencando le 26 tecniche di analisi dei big data. Questo elenco non è affatto esaustivo.

-

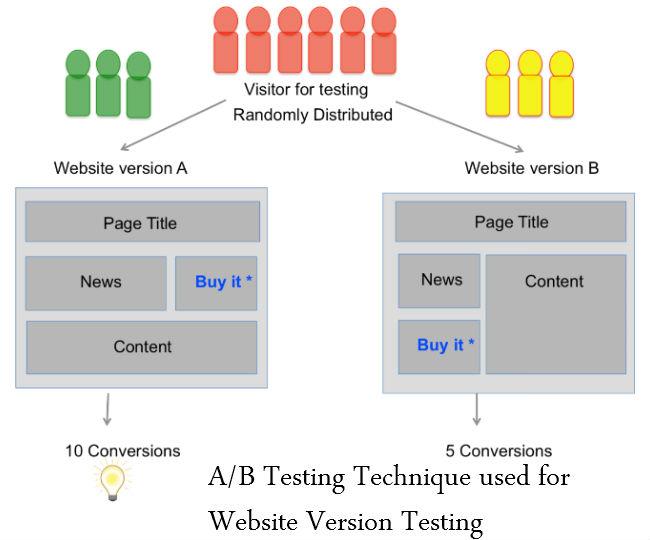

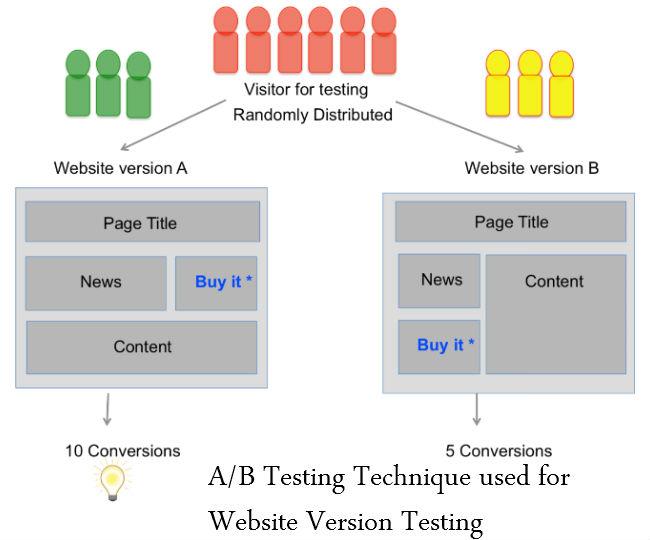

Test A/B

Il test A/B è uno strumento di valutazione per identificare quale versione di una pagina web o di un'app aiuta un'organizzazione o un individuo a raggiungere un obiettivo aziendale in modo più efficace. Questa decisione viene presa confrontando quale versione di qualcosa funziona meglio. Il test A/B è comunemente usato nello sviluppo web per garantire che le modifiche a una pagina web o a un componente della pagina siano guidate da dati e non da opinioni personali.

Viene anche chiamato test versato o test del secchio.

Vedi anche: L'area grigia dei big data: cosa fare e cosa non fare

-

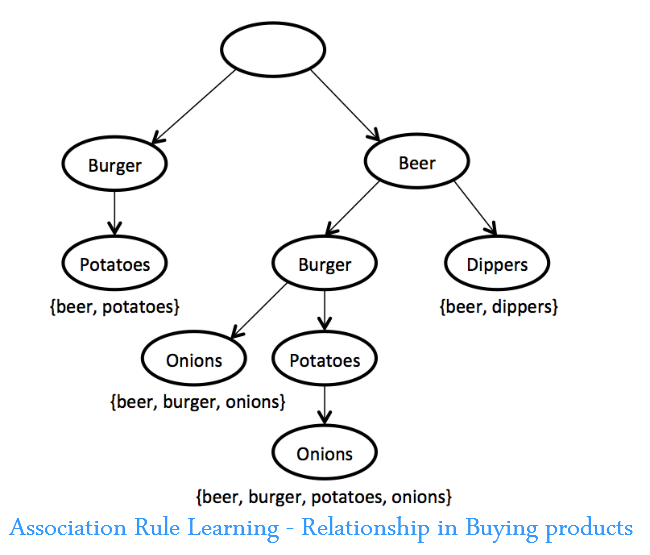

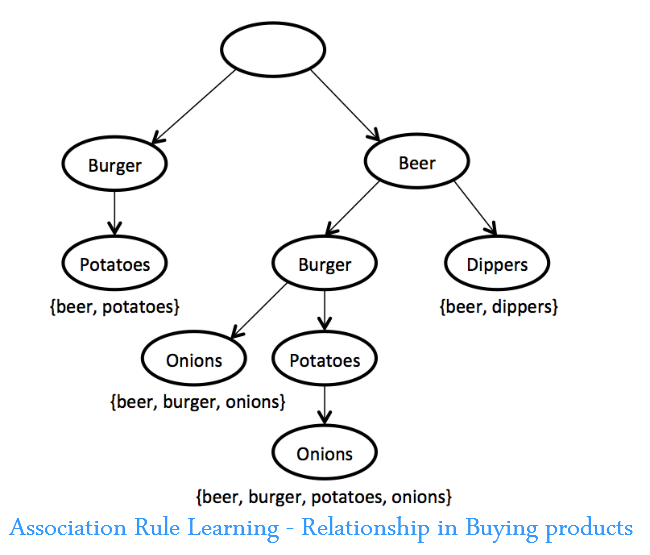

Apprendimento delle regole dell'associazione

Un insieme di tecniche per scoprire relazioni interessanti, ad esempio "regole di associazione", tra variabili in grandi database. Queste tecniche consistono in una varietà di algoritmi per generare e testare possibili regole.

Un'applicazione è l'analisi del paniere di mercato, in cui un rivenditore può determinare quali prodotti vengono acquistati di frequente insieme e utilizzare queste informazioni per il marketing. (Un esempio comunemente citato è la scoperta che molti acquirenti del supermercato che acquistano nachos comprano anche birra.)

-

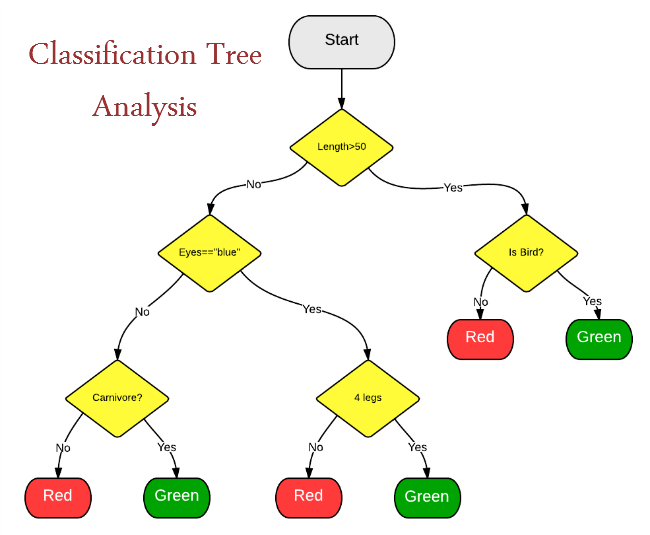

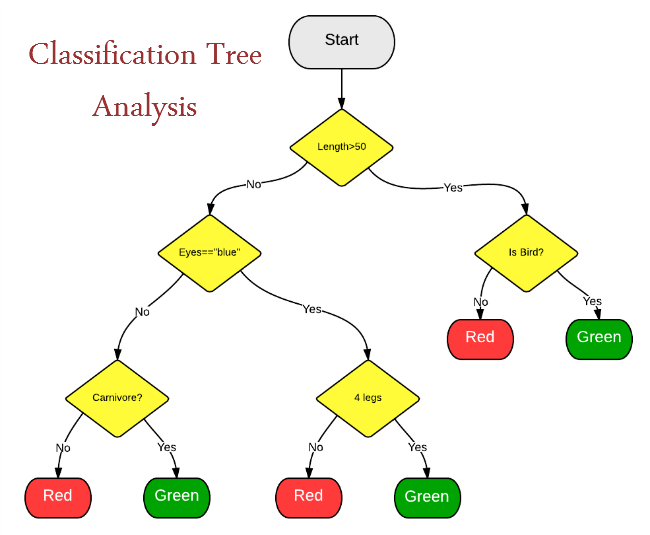

Analisi dell'albero di classificazione

La classificazione statistica è un metodo per identificare le categorie a cui appartiene una nuova osservazione. Richiede un training set di osservazioni correttamente identificate - dati storici in altre parole.

La classificazione statistica viene utilizzata per:

- Assegna automaticamente i documenti alle categorie

- Classificare gli organismi in gruppi

- Sviluppa i profili degli studenti che seguono corsi online

-

Analisi di gruppo

Metodo statistico per la classificazione di oggetti che suddivide un gruppo eterogeneo in gruppi più piccoli di oggetti simili, le cui caratteristiche di somiglianza non sono note in anticipo. Un esempio di cluster analysis è la segmentazione dei consumatori in gruppi auto-simili per il marketing mirato. Utilizzato per l'estrazione di dati.

-

Crowdsourcing

Nel crowdsourcing, la sfumatura è che un'attività o un lavoro viene esternalizzato ma non a un professionista o a un'organizzazione designati ma al pubblico in generale sotto forma di una chiamata aperta. Il crowdsourcing è una tecnica che può essere utilizzata per raccogliere dati da varie fonti come messaggi di testo, aggiornamenti sui social media, blog, ecc. Questo è un tipo di collaborazione di massa e un'istanza di utilizzo del Web.

-

Fusione e integrazione dei dati

Un processo a più livelli che si occupa dell'associazione, correlazione, combinazione di dati e informazioni provenienti da fonti singole e multiple per ottenere posizioni raffinate, identificare stime e valutazioni complete e tempestive di situazioni, minacce e loro significato.

Le tecniche di fusione dei dati combinano i dati provenienti da più sensori e le informazioni correlate dai database associati per ottenere una maggiore precisione e inferenze più specifiche di quelle che si potrebbero ottenere con l'uso di un solo sensore.

Vedi anche: Guida per principianti all'analisi dei Big Data

-

Estrazione dei dati

Il data mining consiste nell'ordinare i dati per identificare modelli e stabilire relazioni. Il data mining si riferisce alle tecniche di estrazione collettiva dei dati eseguite su grandi volumi di dati. I parametri di data mining includono associazione, analisi della sequenza, classificazione, clustering e previsione.

Le applicazioni includono l'estrazione dei dati dei clienti per determinare i segmenti che hanno maggiori probabilità di rispondere a un'offerta, l'estrazione dei dati delle risorse umane per identificare le caratteristiche dei dipendenti di maggior successo o l'analisi del paniere di mercato per modellare il comportamento di acquisto dei clienti.

-

Apprendimento d'insieme

È un'arte combinare insieme diversi set di algoritmi di apprendimento per improvvisare sulla stabilità e sul potere predittivo del modello. Questo è un tipo di apprendimento supervisionato.

-

Algoritmi genetici

Tecniche di ottimizzazione che utilizzano processi come combinazione genetica, mutazione e selezione naturale in un progetto basato sui concetti di evoluzione naturale. Gli algoritmi genetici sono tecniche utilizzate per identificare i video, i programmi TV e altre forme di media più visualizzati. Esiste un modello evolutivo che può essere realizzato mediante l'uso di algoritmi genetici. L'analisi dei video e dei media può essere eseguita mediante l'uso di algoritmi genetici.

-

Apprendimento automatico

L'apprendimento automatico è un'altra tecnica che può essere utilizzata per classificare e determinare il probabile risultato di uno specifico insieme di dati. Machine Learning definisce un software in grado di determinare i possibili esiti di un determinato insieme di eventi. Viene quindi utilizzato nell'analisi predittiva. Un esempio di analisi predittiva è la probabilità di vincere cause legali o il successo di determinate produzioni.

-

Elaborazione del linguaggio naturale

Un insieme di tecniche di una sottospecialità dell'informatica (all'interno di un campo storicamente chiamato "intelligenza artificiale") e della linguistica che utilizza algoritmi informatici per analizzare il linguaggio umano (naturale). Molte tecniche di PNL sono tipi di apprendimento automatico. Un'applicazione della PNL utilizza l'analisi del sentiment sui social media per determinare come i potenziali clienti stanno reagendo a una campagna di branding.

-

Reti neurali

Modelli predittivi non lineari che apprendono attraverso l'addestramento e assomigliano alle reti neurali biologiche nella struttura. Possono essere utilizzati per il riconoscimento e l'ottimizzazione dei modelli. Alcune applicazioni di rete neurale implicano l'apprendimento supervisionato e altre implicano l'apprendimento non supervisionato. Esempi di applicazioni includono l'identificazione di clienti di alto valore che rischiano di lasciare una determinata azienda e l'identificazione di richieste di risarcimento fraudolente.

Leggi anche: 40 fatti sbalorditivi sui big data

-

Ottimizzazione

Un portafoglio di tecniche numeriche utilizzate per riprogettare sistemi e processi complessi per migliorarne le prestazioni secondo una o più misure oggettive (ad es. costo, velocità o affidabilità). Esempi di applicazioni includono il miglioramento dei processi operativi come la pianificazione, l'instradamento e il layout del piano e l'adozione di decisioni strategiche come la strategia della gamma di prodotti, l'analisi degli investimenti collegati e la strategia del portafoglio di ricerca e sviluppo. Gli algoritmi genetici sono un esempio di una tecnica di ottimizzazione.

Nel mio prossimo blog, descriverei le restanti 13 tecniche di analisi dei Big Data.

Leggi: la parte successiva di una panoramica di 26 tecniche di analisi dei big data