Kan AI vechten met toenemend aantal ransomware-aanvallen?

Ransomware-aanvallen nemen toe, maar kan AI helpen het nieuwste computervirus het hoofd te bieden? Is AI het antwoord? Lees hier weten is AI boezem of vloek

In mijn laatste bericht hebben we het gehad over het analyseren van het bedrijfsprobleem en de basisstappen voor het ontwerpen van de Big Data-architectuur. Vandaag ga ik het hebben over verschillende lagen in de Big Data Architectuur en hun functionaliteiten.

Logische lagen van Big Data-referentiearchitectuur

Achter big data-architectuur is het kernidee het documenteren van een juiste basis van architectuur, infrastructuur en applicaties. Hierdoor kunnen bedrijven big data dagelijks effectiever gebruiken.

Het wordt gemaakt door big data-ontwerpers/architecten voordat een oplossing fysiek wordt geïmplementeerd. Het creëren van big data-architectuur vereist over het algemeen inzicht in het bedrijf/de organisatie en zijn big data-behoeften. Doorgaans schetsen big data-architecturen de hardware- en softwarecomponenten die nodig zijn om big data-oplossingen te realiseren. Big data-architectuurdocumenten kunnen ook protocollen beschrijven voor het delen van gegevens, applicatie-integraties en informatiebeveiliging.

Meer informatie: een beginnershandleiding voor big data-analyse

Het omvat ook het onderling verbinden en organiseren van bestaande bronnen om aan de big data-behoeften te voldoen.

De logische lagen van de referentie-architectuur zijn als volgt:

Bronprofilering is een van de belangrijkste stappen bij het bepalen van de architectuur of big data. Het gaat om het identificeren van verschillende bronsystemen en deze te categoriseren op basis van aard en type.

Aandachtspunten bij het profileren van gegevensbronnen:

Bij gegevensopname draait alles om het extraheren van de gegevens uit de bovengenoemde bronnen. Deze gegevens worden opgeslagen in de opslag en vervolgens getransformeerd voor verdere verwerking erop.

Aandachtspunten:

Men moet in staat zijn om grote hoeveelheden gegevens van elk type op te slaan en op basis van behoefte te schalen. We moeten ook rekening houden met het aantal IOPS (invoer-uitvoerbewerkingen per seconde) dat het kan bieden. Het Hadoop-gedistribueerde bestandssysteem is het meest gebruikte opslagframework in de Big Data-wereld, andere zijn de NoSQL-gegevensopslag - MongoDB, HBase, Cassandra enz.

Dingen om te overwegen bij het plannen van opslagmethodologie:

Niet alleen de hoeveelheid gegevens die wordt opgeslagen, maar ook de verwerking is veelvoudig toegenomen.

Eerder vaak gebruikte gegevens werden opgeslagen in dynamische RAM's. Maar nu wordt het vanwege het enorme volume op meerdere schijven opgeslagen op een aantal machines die via een netwerk zijn verbonden. Daarom worden verwerkingsmodules, in plaats van databrokken voor verwerking te verzamelen, naar de big data gebracht. Dus aanzienlijk verminderen van netwerk-I/O. De verwerkingsmethode wordt gedreven door zakelijke vereisten. Het kan worden onderverdeeld in batch, realtime of hybride op basis van de SLA.

Deze laag verbruikt de output die wordt geleverd door de verwerkingslaag. Verschillende gebruikers zoals beheerder, zakelijke gebruikers, leveranciers, partners enz. kunnen gegevens in verschillende formaten gebruiken. Analyse-output kan worden gebruikt door aanbevelingsengine of bedrijfsprocessen kunnen worden geactiveerd op basis van de analyse.

Verschillende vormen van dataverbruik zijn:

Lees ook: Big Data: een toekomstige nachtmerrie?

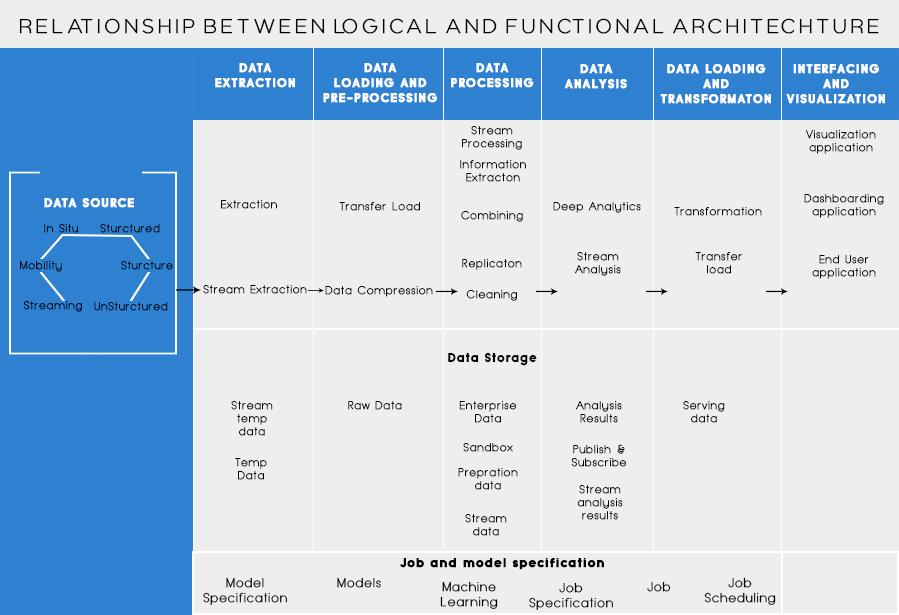

Functionele lagen van de Big Data-architectuur:

Er zou nog een manier kunnen zijn om de architectuur te definiëren, namelijk via de functieverdeling. Maar de functionaliteitscategorieën kunnen worden gegroepeerd in de logische laag van referentiearchitectuur, dus de voorkeursarchitectuur is er een die wordt gedaan met behulp van logische lagen.

De gelaagdheid op basis van de functionaliteiten is als volgt:

Het analyseren van alle bronnen waaruit een organisatie gegevens ontvangt en die de organisatie zouden kunnen helpen bij het nemen van toekomstige beslissingen, zou in deze categorie moeten worden vermeld. De hier vermelde gegevensbronnen zijn ongeacht of de gegevens gestructureerd, ongestructureerd of semi-gestructureerd zijn.

Voordat u uw gegevens kunt opslaan, analyseren of visualiseren, moet u er een paar hebben. Bij gegevensextractie gaat het erom iets dat ongestructureerd is, zoals een webpagina, om te zetten in een gestructureerde tabel. Als je het eenmaal gestructureerd hebt, kun je het op allerlei manieren manipuleren, met behulp van de hieronder beschreven tools, om inzichten te krijgen.

De basisbehoefte bij het werken met big data is nadenken over het opslaan van die gegevens. Een deel van hoe Big Data het onderscheid als "BIG" kreeg, is dat het te veel werd voor de traditionele systemen om te verwerken. Een goede aanbieder van gegevensopslag moet u een infrastructuur bieden waarop u al uw andere analysetools kunt gebruiken, evenals een plek om uw gegevens op te slaan en op te vragen.

Een noodzakelijke stap voordat we de data daadwerkelijk gaan ontginnen voor inzichten. Het is altijd een goede gewoonte om een schone, goed gestructureerde dataset te maken. Datasets kunnen in alle soorten en maten voorkomen, vooral als ze van internet komen. Kies een tool volgens uw gegevensvereiste.

Datamining is het proces van het ontdekken van inzichten in een database. Het doel van datamining is om beslissingen te nemen en voorspellingen te doen over de data die je bij de hand hebt. Kies een software die u de beste voorspellingen geeft voor alle soorten gegevens en waarmee u uw eigen algoritmen kunt maken voor het ontginnen van de gegevens.

Terwijl datamining draait om het doorzoeken van uw gegevens op zoek naar voorheen niet-herkende patronen, gaat het bij data-analyse om het opsplitsen van die gegevens en het beoordelen van de impact van die patronen in de loop van de tijd. Analytics gaat over het stellen van specifieke vragen en het vinden van de antwoorden in data. Je kunt zelfs vragen stellen over wat er in de toekomst gaat gebeuren!

Visualisaties zijn een heldere en gemakkelijke manier om complexe data-inzichten over te brengen. En het beste is dat de meeste van hen geen codering vereisen. Datavisualisatiebedrijven zullen uw data tot leven laten komen. Een deel van de uitdaging voor elke datawetenschapper is het overbrengen van de inzichten uit die data naar de rest van uw bedrijf. Tools kunnen u helpen om grafieken, kaarten en andere dergelijke afbeeldingen te maken op basis van uw gegevensinzichten.

Data-integratieplatforms zijn de lijm tussen elk programma. Ze verbinden de verschillende gevolgtrekkingen van de tools met andere software. Via deze tools kunt u de resultaten van uw visualisatietools rechtstreeks op Facebook delen.

Er zullen momenten zijn in uw datacarrière dat een tool het gewoon niet haalt. Terwijl de tools van vandaag krachtiger en gebruiksvriendelijker worden, is het soms gewoon beter om ze zelf te coderen. Er zijn verschillende talen die u helpen bij verschillende aspecten, zoals statistische berekeningen en afbeeldingen. Deze talen zouden kunnen dienen als aanvulling op de datamining en statistische software.

Het belangrijkste om te onthouden bij het ontwerpen van Big Data-architectuur zijn:

Ik weet dat je zou nadenken over verschillende tools om te gebruiken om een volledig bewijs Big Data-oplossing te maken. Welnu, in mijn komende berichten over Big Data zou ik enkele beste tools behandelen om verschillende taken in big data-architectuur uit te voeren .

Ransomware-aanvallen nemen toe, maar kan AI helpen het nieuwste computervirus het hoofd te bieden? Is AI het antwoord? Lees hier weten is AI boezem of vloek

ReactOS, een open source en gratis besturingssysteem is hier met de nieuwste versie. Kan het voldoen aan de behoeften van moderne Windows-gebruikers en Microsoft uitschakelen? Laten we meer te weten komen over deze oude stijl, maar een nieuwere OS-ervaring.

WhatsApp heeft eindelijk de Desktop-app voor Mac- en Windows-gebruikers gelanceerd. Nu heb je eenvoudig toegang tot WhatsApp vanuit Windows of Mac. Beschikbaar voor Windows 8+ en Mac OS 10.9+

Lees dit om te weten hoe kunstmatige intelligentie populair wordt onder de kleinschalige bedrijven en hoe het de kansen vergroot om ze te laten groeien en hun concurrenten voorsprong te geven.

Onlangs heeft Apple macOS Catalina 10.15.4 uitgebracht, een aanvullende update om problemen op te lossen, maar het lijkt erop dat de update meer problemen veroorzaakt die ertoe leiden dat mac-machines worden gemetseld. Lees dit artikel voor meer informatie

13 Commerciële data-extractietools voor big data

Onze computer slaat alle gegevens op een georganiseerde manier op, het zogenaamde Journaling-bestandssysteem. Het is een efficiënte methode waarmee de computer bestanden kan zoeken en weergeven zodra u op zoeken drukt.https://wethegeek.com/?p=94116&preview=true

Naarmate de wetenschap zich snel ontwikkelt en veel van onze inspanningen overneemt, nemen ook de risico's toe om onszelf te onderwerpen aan een onverklaarbare singulariteit. Lees, wat singulariteit voor ons kan betekenen.

Een inzicht in 26 Big Data-analysetechnieken: deel 1

AI in de zorg heeft de afgelopen decennia grote sprongen gemaakt. De toekomst van AI in de gezondheidszorg groeit dus nog steeds met de dag.