麥克風在 Google Meet 中無法使用?嘗試這些常見的修復

發現解決 Google Meet 麥克風問題的有效方法,包括音頻設置、驅動程序更新等技巧。

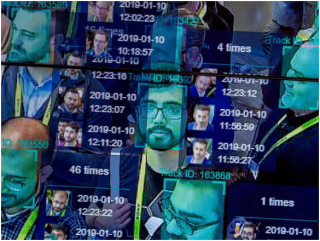

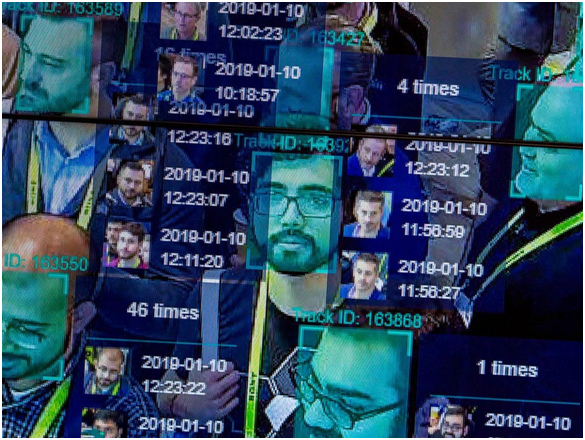

自從在執法中加強面部識別技術的新算法變得突出以來,面部識別技術及其能力已經遠遠超出了我們的想像。目前,執法部隊在數據收集過程的最低級別使用人臉識別技術,以在擁擠的聚會中識別犯罪者。該技術使用公共場所和街道上的閉路電視攝像機的鏡頭,然後將收集到的數據與機構檔案進行對比,以檢測因刑事犯罪而被通緝的面孔。

這項技術已進一步嵌入到最小的小工具中,包括手機和智能可穿戴設備。因此,它不僅可以在街上保護您,還可以保護您存儲在智能設備上的個人信息。在社交媒體活動的現代時代,使用“面部印記”進行營銷和廣告實踐已經變得很普遍。然後,商場、零售店等都有私人監控。

從這個角度,人們可以很快指出面部識別技術不可否認的優勢。但它也因其對用戶隱私、數據保護,當然還有法律與公眾之間的透明度構成的威脅而受到審查。了解這種侵入性技術的優點和缺點是一件好事。然而,人臉識別技術還有一個人們似乎忽視的缺點,那就是種族貌相和種族歧視。

在這篇文章中,我們將研究這項技術如何助長種族偏見和歧視,以及這種侵入性技術的影響有多大。

面部識別如何工作?

圖片來源:國家郵政

第 1 步:從相機、您的帳戶、電子郵件等中拍攝您的照片。它可以是直接的個人資料照片,也可以是人群中的隨機快照。

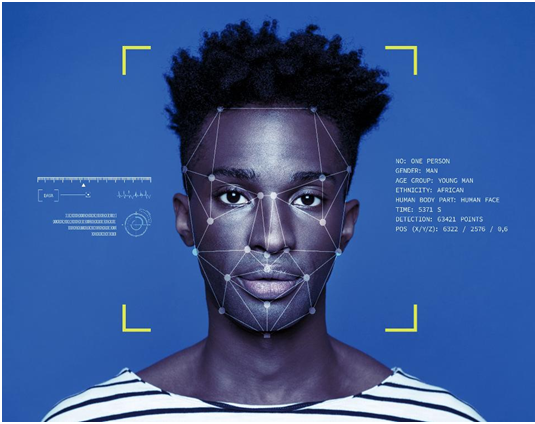

第 2 步:面部識別軟件將通過存儲的面部指紋數據庫運行您的面部。面部印記是通過對您面部的幾何跟踪來收集的。

第 3 步:使用算法生成您的圖片與任何已知面部印記的匹配百分比,並據此做出決定。

自動化偏見:面部識別技術的眾多缺陷之一

自動化偏差或機器偏差是指機器算法在輸入數據的校準中表現出一定偏差,從而給出不利輸出的情況。當算法代碼中存在錯誤、缺少用於校準的存儲數據集、不正確的輸入值或過多的輸入數據(超出機器的校準能力)時,就會發生這種情況。

種族分析如何與所有這些相結合?

圖片來源:衛報

讓我們從一個在當時被認為微不足道的古老事件開始。2001 年,由於 2001 年超級碗,遊客湧入城市街道,坦帕市使用人臉識別軟件監視擁擠的城市。根據《紐約時報》的報導,該軟件確定了 19 名據稱對他們持有未決認股權證的人;然而,沒有逮捕任何人,因為體育場的基礎設施使得無法在壓倒性的人群中找到已確定的罪魁禍首。

雖然在這個特殊案例中沒有任何地方看到種族定性的跡象,但這是第一次使用監視技術來防止侵犯公民自由和個人隱私。在接下來的幾年裡,坦帕警方以不可靠的結果為由放棄了這些監視系統。

圖片來源:ICO

快進到最近的一個場景,阿里·布雷蘭德為《衛報》報導了關於逮捕威利·林奇的報導,威利·林奇是一名黑人,被指控在布倫特伍德地區是臭名昭著的毒販,主要是有色人種社區。對林奇不利的唯一證據是他在手機上的照片,在警方確定他為罪魁禍首之前,這些照片已在警方數據庫中運行。林奇被判有罪八年,他現在已對定罪提出上訴。無論他是否是被指控的經銷商,都不可避免地引起了人們的關注,即僅基於機器的結果是否足以維持任何被調查者的定罪?

2019 年,據《衛報》湯姆·帕金斯( Tom Perkins)報導,底特律警方在過去兩年中被發現使用人臉識別進行逮捕。底特律是一個黑人佔 80% 以上的地方。底特律警察委員會一名黑人成員的聲明對這種做法表示擔憂。他說黑人有一個共同的面部特徵,這會危及系統的算法,稱之為“技術種族主義”。

圖片來源:Vox

在 2019 年由 Fabio Bacchini 和 Ludovica Lorusso 為 Journal of Information Communication and Ethics Society 所做的一項研究中,發現這些生物識別和人臉識別系統對執法部門並非 100% 可靠。此外,種族歧視對所有此類系統都產生了負面影響,這進一步產生了負面的社會影響。該研究特別針對西方社會,在那裡此類系統被廣泛用於監視。

這些只是由人臉識別系統引起的種族差異的許多此類例子中的三個。但是為什麼這些系統在算法編碼技術升級的準確性越來越高的情況下如此無能。

西方國家的白人至上:白人主導的科技產業

2014 年,發現包括巨頭蘋果公司在內的大多數科技公司招聘的大部分是白人男性員工。在 Apple,55% 的員工是白人,同樣,Apple 的領導層佔白人員工的 63%。共享類似多樣性報告的公司還包括Facebook、谷歌和 Twitter。五年後,《連線》雜誌的一份報告披露,這些數字的改善微乎其微。

雖然 Facebook 在數量上表現出不錯的改善,但蘋果的黑人技術工人的百分比沒有變化,僅佔總勞動力的 6%。亞馬遜是唯一一家在其美國辦事處註冊了 42% 的黑人或拉丁美洲工人的組織。

這些統計數據意味著什麼?在美國,大多數被分配到諸如設計監視系統算法之類的重大項目的編碼員都是白人。這些人對公司要推出/推出的產品或服務做出最重要的決定。因此,最終的創作是他們的觀點、方法和思維過程。這並不意味著白人是種族主義者,並且有意設計了此類監視系統。不!

圖片來源:福布斯

當一個白人設計人臉識別算法並且只有白人同事諮詢/協助他時,他們在最終確定代碼之前不會考慮其他顏色的人的面部特徵。由於白人工程師主導著科技行業,用於準備初始代碼的數據檔案也由白人技術人員創建和校準。因此,代碼本身在其核心計算算法中存在偏差,導致監視結果存在這些種族差異。

該代碼只是了解白人在其中體現的內容。沒有其他顏色的任何人的觀點或貢獻。

校準問題

美國執法部門嚴重依賴監視和數據跟踪。在很多情況下,告密者刪除了有關未經授權監視平民的信息。愛德華·斯諾登 (Edward Snowden) 揭露美國國家安全局 (NSA) 的非法監視就是這樣一個例子。

圖片來源:CBS 本地

這些監視計劃得到了數百萬公民的面部印記和其他個人信息的支持。如果我們只考慮面部印記,數百萬美國人會在社交媒體平台上公開分享照片。然後在全國的每條街道上都有閉路電視攝像機,可以提供數十萬路人的現場鏡頭。目前,警察數據庫中大約有 1.17 億張圖像,而 FBI 有超過 4 億個數據集用於校準監控人臉識別算法。

現在想像將這些數據集與單個圖像進行比較,該圖像可能已經或可能沒有捕獲特定人的所有面部特徵。在這種情況下,很可能會出現錯誤。有太多的數據無法理解並針對一張臉印運行它。在校準如此復雜的情況下,沒有任何算法可以保證其結果百分百保證。這最終構成了人臉識別技術引起的種族定性。

人臉識別的巨大可靠性

圖片來源:紐約郵報

威利·林奇 (Willie Lynch) 的案例提醒人們,在執法方面,面部識別不應成為唯一可靠的證據。這就是坦帕市警察放棄這項技術的原因。

誠然,人臉識別是一個絕佳的手段,對警方很有幫助。波士頓馬拉松爆炸案的罪魁禍首是通過對監視錄音的廣泛而詳細的分析來確定的。但這不能成為定罪任何人的唯一證據。必須有支持證據來證明人臉識別算法的結果,並且在做出最終決定之前必須考慮自動化偏差的概念。

硬件問題:手機和相機中的人臉識別

圖片來源:TechCrunch

監控攝像頭系統及相關硬件和軟件並非由一家公司設計。這是一個價值數十億美元的行業,數十家公司競相從執法機構獲得合同。其中許多系統來自中國製造商。這一切都是為了獲得質量最好的最便宜的技術。這就是它的主要工作方式。因此,不同系統的校準總是存在差異,以及監測結果質量的差異。許多攝像頭監控算法僅僅因為技術無能而無法校準有色人種的圖像,從而美化種族歧視。

Apple Face Lock 功能中也注意到了通過面部識別導致種族主義的技術問題。來自中國的一個案例表明,iPhone X 面部鎖定無法區分兩個不同的中國同事,使該功能毫無用處。類似的報導被駁回,理由是將兩個黑人彼此分開的特徵存在問題。如上所述,蘋果在技術團隊中只有 6% 的黑人。這是面部識別技術如何在我們的手持設備中促進種族主義的一個明顯例子。

結論

是的,面部識別是種族主義,這是現在的常識。雖然技術每天都在發展以糾正這些問題,但結果都是一樣的。技術應該通過技術進步和發展的共同目標將世界團結起來,但有些技術只是對種族和社區和諧造成傷害。

目前,執法人員能做的最好的事情就是不根據算法校準的證據來支持他們的案件,這些證據甚至都不可靠。此外,現在是認真對待工作場所的多樣性和包容性的時候了,這樣所有種族的人都可以聚在一起創造一種沒有種族差異的產品。世界上有數以千計的種族,人們已經成長為將種族差異放在一邊,這種差異一直困擾著全球社會。如果必須保持這一點,那麼我們非常依賴的機器也必須接受同樣的教育。

發現解決 Google Meet 麥克風問題的有效方法,包括音頻設置、驅動程序更新等技巧。

在 Twitter 上發送訊息時出現訊息發送失敗或類似錯誤?了解如何修復 X (Twitter) 訊息發送失敗的問題。

無法使用手腕檢測功能?以下是解決 Apple Watch 手腕偵測不起作用問題的 9 種方法。

解決 Twitter 上「出錯了,重試」錯誤的最佳方法,提升用戶體驗。

如果您無法在瀏覽器中登入 Google 帳戶,請嘗試這些故障排除提示以立即重新取得存取權限。

借助 Google Meet 等視頻會議工具,您可以在電視上召開會議,提升遠程工作的體驗。

為了讓您的對話更加安全,您可以按照以下步驟在行動裝置和桌面裝置上為 Instagram 聊天啟用端對端加密。

了解如何檢查您的 Dropbox 安全設定有助於確保您的帳戶免受惡意攻擊。

YouTube TV 為我們提供了許多堅持使用的理由,因為它融合了直播電視、點播視頻和 DVR 功能。讓我們探索一些最好的 YouTube 電視提示和技巧。

您的三星手機沒有收到任何通知?嘗試這些提示來修復通知在您的 Samsung Galaxy 手機上不起作用的問題。