Como alterar o nome de usuário e o nome de exibição do Twitch

Quer dar um novo começo ao seu perfil do Twitch? Veja como alterar o nome de usuário e o nome de exibição do Twitch com facilidade.

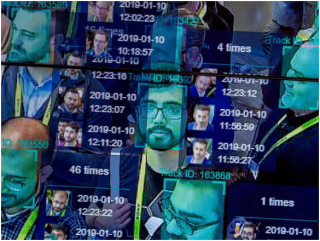

A tecnologia de reconhecimento facial e suas habilidades têm crescido muito além da nossa imaginação desde que novos algoritmos para reforçar essa tecnologia na aplicação da lei se tornaram proeminentes. Atualmente, a tecnologia de reconhecimento facial é usada pelas forças de segurança nos níveis mais baixos dos processos de coleta de dados para identificar criminosos em meio a reuniões lotadas. A tecnologia usa imagens de câmeras CCTV em locais públicos e ruas e, em seguida, executa os dados coletados nos arquivos da agência para detectar um rosto procurado por crimes.

Esta tecnologia foi ainda incorporada no menor dos gadgets, incluindo telefones celulares e dispositivos portáteis inteligentes. Portanto, não está apenas protegendo você nas ruas, mas também pretende proteger suas informações pessoais armazenadas em seus dispositivos inteligentes. O uso de “impressão facial” para práticas de marketing e publicidade tornou-se comum na era moderna das campanhas de mídia social. E então, há vigilância privada em shoppings, lojas de varejo, etc.

Nessa perspectiva, pode-se apontar rapidamente as vantagens inegáveis da tecnologia de reconhecimento facial. Mas também foi examinado quanto à ameaça que representa para a privacidade do usuário, proteção de dados e, claro, transparência entre a lei e o público. É bom estar ciente das vantagens e desvantagens de uma tecnologia tão invasiva. No entanto, há mais uma desvantagem da tecnologia de reconhecimento facial, que as pessoas parecem ignorar, que é o perfilamento racial e a discriminação racial .

Neste artigo, veremos como essa tecnologia promove preconceito e discriminação racial e como são graves as repercussões dessa tecnologia invasiva.

Como funciona o reconhecimento facial?

Fonte da imagem: National Post

Etapa 1: uma foto sua é tirada de uma câmera, sua conta, e-mail, etc. É uma foto de perfil simples ou uma foto aleatória no meio da multidão.

Etapa 2: o software de reconhecimento de rosto examinará seu rosto por meio de um banco de dados de impressões faciais armazenadas. A impressão facial é obtida por meio do rastreamento geométrico de seu rosto.

Etapa 3: uma porcentagem de correspondência de sua imagem em relação a qualquer impressão facial conhecida é produzida usando um algoritmo sobre o qual é feita uma determinação.

Viés de automação: uma das muitas falhas da tecnologia de reconhecimento facial

A polarização da automação ou polarização da máquina refere-se ao cenário em que um algoritmo da máquina exibe uma certa polarização na calibração dos dados de entrada, dando assim uma saída desfavorável. Isso acontece quando há um erro no código do algoritmo, falta de conjuntos de dados armazenados para calibração, valores de entrada incorretos ou dados de entrada excessivos, que estão além da força das máquinas para calibrar.

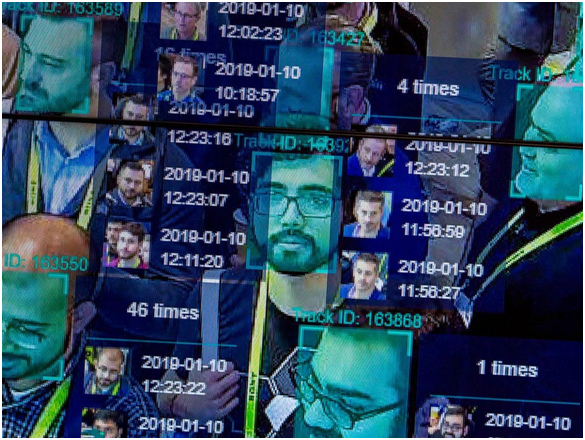

Como o perfil racial vai com tudo isso?

Fonte da imagem: The Guardian

Vamos começar com um antigo incidente que na época foi considerado insignificante. Em 2001, Tampa City usou um software de reconhecimento de rosto para vigilância sobre a cidade lotada enquanto os turistas inundavam as ruas da cidade devido ao Super Bowl de 2001. De acordo com um relatório do New York Times , o software identificou 19 pessoas que supostamente tinham garantias pendentes contra elas; no entanto, nenhuma prisão foi feita, pois a infraestrutura do estádio impossibilitou o acesso aos culpados identificados em meio a uma multidão esmagadora.

Embora os sinais de discriminação racial não tenham sido vistos em nenhum lugar neste caso específico, foi a primeira vez que técnicas de vigilância foram utilizadas contra a violação das liberdades civis e da privacidade de indivíduos. Nos próximos anos, a Polícia de Tampa desistiu desses sistemas de vigilância citando resultados não confiáveis.

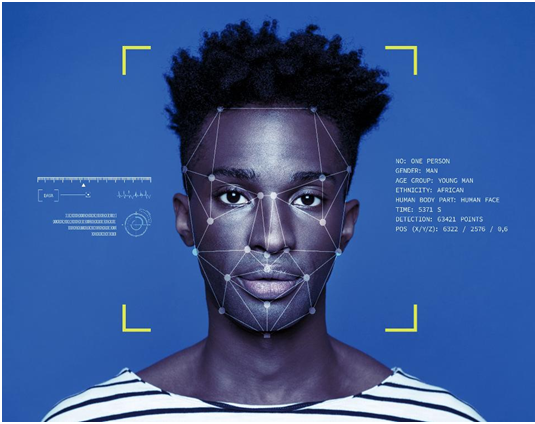

Fonte da imagem: ICO

Avançando para um cenário um pouco mais recente, Ali Breland relatou para o The Guardian , a respeito da prisão de Willie Lynch, um homem negro acusado de ser um notório traficante de drogas na área de Brentwood, predominantemente um bairro de pessoas de cor. A única evidência contra Lynch foram suas fotos em um celular, que foram executadas em um banco de dados da polícia antes que a polícia o determinasse como o culpado. Lynch foi condenado por oito anos, que agora recorreu da condenação. Se ele era o suposto traficante ou não, inevitavelmente levanta a preocupação sobre se apenas um resultado baseado em máquina é suficiente para manter a condenação de alguém sob investigação.

Em 2019, conforme relatado por Tom Perkins para o The Guardian , a polícia de Detroit foi encontrada usando reconhecimento facial para fazer prisões supostamente nos últimos dois anos. Detroit é um lugar onde mais de 80% da população é negra. Uma declaração de um membro negro da Comissão de Polícia de Detroit levantou preocupações contra a prática. Ele disse que os negros têm um traço facial comum que prejudica o algoritmo do sistema, chamando isso de “tecno-racismo”.

Fonte da imagem: Vox

Em uma pesquisa de 2019 para o Jornal da Sociedade de Informação, Comunicação e Ética, por Fabio Bacchini e Ludovica Lorusso, foi descoberto que esses sistemas biométricos e de reconhecimento facial não são 100% confiáveis para a aplicação da lei. Além disso, a discriminação racial teve um impacto negativo em todos esses sistemas, o que tem implicações sociais ainda mais inversas. O estudo teve como alvo sociedades ocidentais em particular, onde tais sistemas são amplamente usados para vigilância.

Esses são apenas três dos muitos exemplos em que casos de disparidades raciais causadas por sistemas de reconhecimento de rosto vieram à tona. Mas por que esses sistemas são tão incompetentes, apesar da crescente precisão nas atualizações de codificação algorítmica na tecnologia.

Supremacia branca nos estados ocidentais: uma indústria de tecnologia dominante branca

Em 2014, descobriu-se que a maioria das empresas de tecnologia, incluindo a gigante Apple Inc., estava contratando funcionários do sexo masculino, em sua maioria brancos. Na Apple, 55% dos funcionários eram brancos e, da mesma forma, a liderança da Apple compreendia 63% de funcionários brancos. As empresas que compartilharam relatórios de diversidade semelhantes também incluem Facebook , Google e Twitter. Cinco anos depois, um relatório da Wired revelou que houve uma melhora mínima nesses números.

Embora o Facebook tenha mostrado uma melhora decente nos números, a porcentagem de trabalhadores técnicos negros da Apple permaneceu inalterada em apenas 6% da força de trabalho total. A Amazon foi a única organização que registrou 42% de trabalhadores negros ou latino-americanos em seus escritórios nos Estados Unidos.

O que essas estatísticas significam? Nos Estados Unidos, a maioria dos codificadores, que são designados para projetos importantes, como o design de algoritmos para sistemas de vigilância, são brancos. Estas são as pessoas que tomam as decisões mais significativas em relação a um produto ou serviço a ser lançado / divulgado por uma empresa. E, portanto, são suas perspectivas, abordagem e processos de pensamento que vão na criação final. Isso não quer dizer que os brancos sejam racistas e tenham projetado esses sistemas de vigilância de propósito . NÃO!

Fonte da imagem: Forbes

Quando um cara branco projeta um algoritmo de reconhecimento de rosto e tem apenas colegas brancos para consultá-lo / auxiliá-lo, eles não consideram as pessoas com traços faciais de outras cores antes de finalizar o código. Como os engenheiros brancos dominam a indústria de tecnologia, os arquivos de dados usados para preparar o código inicial também são criados e calibrados por técnicos brancos. Assim, o próprio código é criado com um viés em seu algoritmo calculativo central, resultando nessas disparidades raciais nos resultados de vigilância.

O código simplesmente aprende o que os brancos incorporam nele. Não há perspectiva ou contribuição de qualquer pessoa de outra cor.

Os problemas de calibração

A aplicação da lei americana depende muito da vigilância e do rastreamento de dados. Houve muitos casos em que delatores retiraram informações sobre vigilância não autorizada de civis. A revelação de Edward Snowden sobre a vigilância ilegal da NSA é um exemplo.

Fonte da imagem: CBS Local

Esses programas de vigilância são apoiados por impressões faciais e outras informações pessoais de milhões de cidadãos. Se considerarmos apenas as impressões faciais, há milhões de americanos compartilhando imagens abertamente em plataformas de mídia social. Depois, há câmeras de CFTV em todas as ruas do país que oferecem imagens ao vivo de centenas de milhares de transeuntes. Atualmente, existem aproximadamente 117 milhões de imagens em bancos de dados policiais, enquanto o FBI tem mais de 400 milhões de conjuntos de dados para calibrar em algoritmos de reconhecimento facial de vigilância.

Agora imagine esses conjuntos de dados comparados a uma única imagem que pode ou não ter capturado todos os traços faciais de uma pessoa em particular. Nesse cenário, é provável que ocorram erros. Existem dados demais para compreender e compará-los com uma impressão facial. Nenhum algoritmo pode garantir cem por cento de segurança em seu resultado quando a calibração é tão complicada. Isso eventualmente se soma ao perfil racial causado pela tecnologia de reconhecimento facial.

A imensa confiabilidade do reconhecimento facial

Fonte da imagem: NY Post

O caso de Willie Lynch é um lembrete de que o reconhecimento facial não deve ser a única técnica confiável apresentada como prova quando se trata de aplicação da lei. Esta é a razão pela qual a polícia da cidade de Tampa desistiu da tecnologia.

É verdade que o reconhecimento facial é um excelente recurso e é útil para a polícia. Os culpados dos bombardeios da Maratona de Boston foram reconhecidos por meio de análises extensas e detalhadas de gravações de vigilância. Mas essa não pode ser a evidência singular para condenar ninguém. Deve haver evidências de suporte para provar os resultados dos algoritmos de reconhecimento de face, e o conceito de viés de automação deve ser considerado antes de se chegar a uma determinação final.

O problema de hardware: reconhecimento facial em celulares e câmeras

Fonte da imagem: TechCrunch

Os sistemas de câmeras de vigilância e hardware e software associados não são projetados por uma única empresa. É uma indústria que vale bilhões de dólares, na qual dezenas de corporações competem para obter contratos das agências de aplicação da lei. Muitos desses sistemas são de fabricantes chineses. É tudo uma questão de obter a tecnologia mais barata com as melhores qualidades. É assim que geralmente funciona. E, portanto, sempre há chances de diferenças na calibração de diferentes sistemas, bem como variação na qualidade dos resultados da vigilância. Muitos algoritmos de vigilância por câmera são ineficazes na calibração de imagens de pessoas de cor apenas por causa da incompetência técnica, glorificando assim a discriminação racial.

Os problemas de tecnologia que causam racismo por meio do reconhecimento de rosto também foram notados no recurso Apple Face Lock. Um caso da China revelou que o bloqueio de rosto do iPhone X não era capaz de diferenciar entre dois colegas de trabalho chineses diferentes, tornando o recurso inútil. Relatórios semelhantes foram rejeitados, citando problemas no artigo em separar dois negros um do outro. Como afirmado acima, a Apple tem apenas 6% de negros em equipes técnicas. É um exemplo claro de como uma tecnologia de reconhecimento facial pode promover o racismo mesmo em nossos dispositivos portáteis.

Conclusão

Sim, o reconhecimento facial é racista, e isso é do conhecimento comum agora. Embora a tecnologia esteja crescendo diariamente para corrigir esses problemas, os resultados são todos iguais. Supõe-se que a tecnologia une o mundo em torno de objetivos comuns de avanços e desenvolvimento técnico, mas algumas técnicas estão apenas causando danos à harmonia racial e comunitária.

Por enquanto, a melhor coisa que os policiais podem fazer é não apoiar seus casos com base em evidências de calibrações algorítmicas, que nem mesmo são confiáveis. Além disso, é hora de levar a sério a diversidade e a inclusão nos locais de trabalho, para que pessoas de todas as etnias possam se unir para criar um produto livre de disparidades raciais. Existem milhares de raças no mundo, e as pessoas cresceram para deixar de lado as diferenças raciais, que assombraram a sociedade global por tanto tempo. Se isso deve ser mantido, então as máquinas nas quais tanto confiamos devem ser ensinados da mesma forma.

Quer dar um novo começo ao seu perfil do Twitch? Veja como alterar o nome de usuário e o nome de exibição do Twitch com facilidade.

Descubra como alterar o plano de fundo no Microsoft Teams para tornar suas videoconferências mais envolventes e personalizadas.

Não consigo acessar o ChatGPT devido a problemas de login? Aqui estão todos os motivos pelos quais isso acontece, juntamente com 8 maneiras de consertar o login do ChatGPT que não funciona.

Você experimenta picos altos de ping e latência no Valorant? Confira nosso guia e descubra como corrigir problemas de ping alto e atraso no Valorant.

Deseja manter seu aplicativo do YouTube bloqueado e evitar olhares curiosos? Leia isto para saber como colocar uma senha no aplicativo do YouTube.

Descubra como bloquear e desbloquear contatos no Microsoft Teams e explore alternativas para um ambiente de trabalho mais limpo.

Você pode facilmente impedir que alguém entre em contato com você no Messenger. Leia nosso guia dedicado para saber mais sobre as implicações de restringir qualquer contato no Facebook.

Aprenda como cortar sua imagem em formatos incríveis no Canva, incluindo círculo, coração e muito mais. Veja o passo a passo para mobile e desktop.

Obtendo o erro “Ação bloqueada no Instagram”? Consulte este guia passo a passo para remover esta ação foi bloqueada no Instagram usando alguns truques simples!

Descubra como verificar quem viu seus vídeos no Facebook Live e explore as métricas de desempenho com dicas valiosas e atualizadas.